-

기계공학과 구승범 교수팀, NeurIPS 2024 MyoChallenge 대회 보행 부문 우승

우리 대학 기계공학과 구승범 교수 연구팀(박건우 박사과정, 신범수 박사과정, 박종현 박사과정)은 2024년 12월 캐나다 밴쿠버에서 열린 NeurIPS 학회의 경쟁 대회 중 하나인 MyoChallenge 대회에 참가하여, 15개국에서 54팀이 참여한 가운데, 보행 운동 부문 1위를 차지하였다. 이 대회는 Google Deepmind, Google Cloud와 Össur가 후원하였다.

이 대회에서는 인체의 신경근육제어 원리를 연구하기 위한 다물체 동역학 기반의 인체 근골격 시뮬레이션 환경이 제시되었다. 자체 알고리즘으로 작동하는 의족/의수 (Prosthetic limb)가 결합된 인체 모델이 일상 생활 동작(상지 운동, 보행 운동)을 할 수 있도록 인체 근육 제어기를 학습하고, 그 성능을 경쟁하였다. 보행 운동 부문에서는 의족을 장착한 인체 모델이 주어진 트랙(평지, 거친길, 언덕, 계단)에 맞춰 보행할 수 있도록 인체 제어기를 학습하고, 그 안정성과 속도를 평가하였다.

하지에 54개 근육과 오른 다리 의족이 장착된 인체 모델의 근육 활성도를 제어하여, 지면이 고르지 않은 5m x 120m 경기장에서 넘어지지 않고 앞으로 나아가는 경기가 진행되었다. 구승범 교수 연구팀은 심층강화학습 기술과 인체 운동 데이터 기반 동작 생성 기술을 적용하여, 실제 사람이 근육을 제어하여 운동하는 모습을 모방할 수 있는 고성능 인체 운동 제어기를 학습하였다. 특히, 올해는 연구실에서 자체 구축한 120명의 평지, 계단 및 경사로 보행 동작 데이터셋을 사용해서, 인체 모델이 계단 및 경사로 지형에서도 안정적으로 보행할 수 있도록 학습하였다.

이 기술은 인체의 신경운동제어를 모방하여 다양한 상황에서의 보행 동작을 생성할 수 있다. 또한 이번 대회와 같이 인체에 착용하는 보조 장비와 상호 작용 시뮬레이션이 가능하여, 장비/기구의 개발 및 성능 개선에 사용 가능하다.

이번 대회에는 과학기술정보통신부(IITP ETRI 연구개발지원사업, 연구재단 미래유망융합기술파이오니어사업, 연구재단 중견연구자지원사업)의 지원을 받아 참여하였다.

기계공학과 구승범 교수팀, NeurIPS 2024 MyoChallenge 대회 보행 부문 우승

우리 대학 기계공학과 구승범 교수 연구팀(박건우 박사과정, 신범수 박사과정, 박종현 박사과정)은 2024년 12월 캐나다 밴쿠버에서 열린 NeurIPS 학회의 경쟁 대회 중 하나인 MyoChallenge 대회에 참가하여, 15개국에서 54팀이 참여한 가운데, 보행 운동 부문 1위를 차지하였다. 이 대회는 Google Deepmind, Google Cloud와 Össur가 후원하였다.

이 대회에서는 인체의 신경근육제어 원리를 연구하기 위한 다물체 동역학 기반의 인체 근골격 시뮬레이션 환경이 제시되었다. 자체 알고리즘으로 작동하는 의족/의수 (Prosthetic limb)가 결합된 인체 모델이 일상 생활 동작(상지 운동, 보행 운동)을 할 수 있도록 인체 근육 제어기를 학습하고, 그 성능을 경쟁하였다. 보행 운동 부문에서는 의족을 장착한 인체 모델이 주어진 트랙(평지, 거친길, 언덕, 계단)에 맞춰 보행할 수 있도록 인체 제어기를 학습하고, 그 안정성과 속도를 평가하였다.

하지에 54개 근육과 오른 다리 의족이 장착된 인체 모델의 근육 활성도를 제어하여, 지면이 고르지 않은 5m x 120m 경기장에서 넘어지지 않고 앞으로 나아가는 경기가 진행되었다. 구승범 교수 연구팀은 심층강화학습 기술과 인체 운동 데이터 기반 동작 생성 기술을 적용하여, 실제 사람이 근육을 제어하여 운동하는 모습을 모방할 수 있는 고성능 인체 운동 제어기를 학습하였다. 특히, 올해는 연구실에서 자체 구축한 120명의 평지, 계단 및 경사로 보행 동작 데이터셋을 사용해서, 인체 모델이 계단 및 경사로 지형에서도 안정적으로 보행할 수 있도록 학습하였다.

이 기술은 인체의 신경운동제어를 모방하여 다양한 상황에서의 보행 동작을 생성할 수 있다. 또한 이번 대회와 같이 인체에 착용하는 보조 장비와 상호 작용 시뮬레이션이 가능하여, 장비/기구의 개발 및 성능 개선에 사용 가능하다.

이번 대회에는 과학기술정보통신부(IITP ETRI 연구개발지원사업, 연구재단 미래유망융합기술파이오니어사업, 연구재단 중견연구자지원사업)의 지원을 받아 참여하였다.

2024.12.24

조회수 3830

-

인간의 인지 방식과 유사한 AI 모델 개발

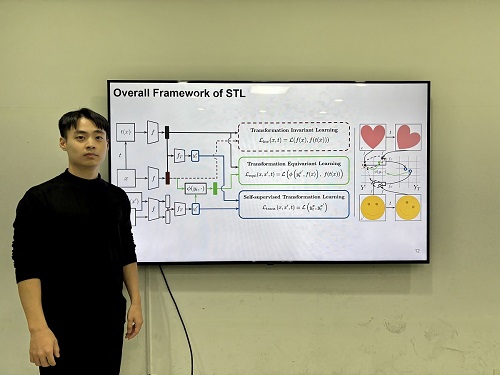

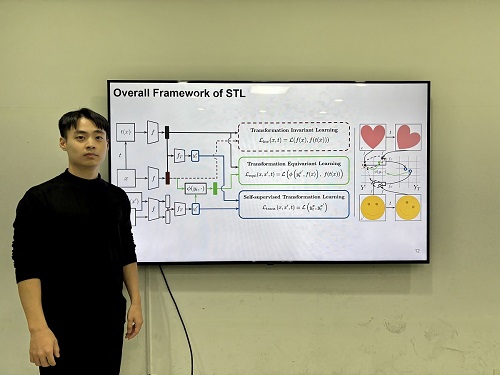

우리 연구진이 인간의 인지 방식을 모방해 이미지 변화를 이해하고, 시각적 일반화와 특정성을 동시에 확보하는 인공지능 기술을 개발했다. 이 기술은 의료 영상 분석, 자율주행, 로보틱스 등 다양한 분야에서 이미지를 이해하여 객체를 분류, 탐지하는 데 활용될 전망이다.

우리 대학 전기및전자공학부 김준모 교수 연구팀이 변환 레이블(transformational labels) 없이도 스스로 변환 민감 특징(transformation-sensitive features)을 학습할 수 있는 새로운 시각 인공지능 모델 STL(Self-supervised Transformation Learning)을 개발했다고 13일 밝혔다.

연구팀이 개발한 시각 인공지능 모델 STL은 스스로 이미지의 변환을 학습하여, 이미지 변환의 종류를 인간이 직접 알려주면서 학습하는 기존 방법들보다 높은 시각 정보 이해 능력을 보였다. 특히, 기존 방법론들을 통해 학습한 모델이 이해할 수 없는 세부적인 특징까지도 학습하여 기존 방법 대비 최대 42% 우수한 성능을 보여줬다.

컴퓨터 비전에서 이미지 변환을 통한 데이터 증강을 활용해 강건한 시각 표현을 학습하는 방식은 일반화 능력을 갖추는 데 효과적이지만, 변환에 따른 시각적 세부 사항을 무시하는 경향이 있어 범용 시각 인공지능 모델로서 한계가 있다.

연구팀이 제안한 STL은 변환 라벨 없이 변환 정보를 학습할 수 있도록 설계된 새로운 학습 기법으로, 라벨 없이 변환 민감 특징을 학습할 수 있다. 또한, 기존 학습 방법 대비 학습 복잡도를 유지한 채로 효율적인 최적화할 수 있는 방법을 제안했다.

실험 결과, STL은 정확하게 객체를 분류하고 탐지 실험에서 가장 낮은 오류율을 기록했다. 또한, STL이 생성한 표현 공간은 변환의 강도와 유형에 따라 명확히 군집화되어 변환 간 관계를 잘 반영하는 것으로 나타났다.

김준모 교수는 "이번에 개발한 STL은 복잡한 변환 패턴을 학습하고 이를 표현 공간에서 효과적으로 반영하는 능력을 통해 변환 민감 특징 학습의 새로운 가능성을 제시했다”며, "라벨 없이도 변환 정보를 학습할 수 있는 기술은 다양한 AI 응용 분야에서 핵심적인 역할을 할 것”이라고 말했다.

우리 대학 전기및전자공학부 유재명 박사과정이 제1 저자로 참여한 이번 연구는 최고 권위 국제 학술지 ‘신경정보처리시스템학회(NeurIPS) 2024’에서 올 12월 발표될 예정이다.(논문명: Self-supervised Transformation Learning for Equivariant Representations)

한편 이번 연구는 이 논문은 2024년도 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행된 연구 성과물(No.RS-2024-00439020, 지속가능한 실시간 멀티모달 인터렉티브 생성 AI 개발, SW스타랩) 이다.

인간의 인지 방식과 유사한 AI 모델 개발

우리 연구진이 인간의 인지 방식을 모방해 이미지 변화를 이해하고, 시각적 일반화와 특정성을 동시에 확보하는 인공지능 기술을 개발했다. 이 기술은 의료 영상 분석, 자율주행, 로보틱스 등 다양한 분야에서 이미지를 이해하여 객체를 분류, 탐지하는 데 활용될 전망이다.

우리 대학 전기및전자공학부 김준모 교수 연구팀이 변환 레이블(transformational labels) 없이도 스스로 변환 민감 특징(transformation-sensitive features)을 학습할 수 있는 새로운 시각 인공지능 모델 STL(Self-supervised Transformation Learning)을 개발했다고 13일 밝혔다.

연구팀이 개발한 시각 인공지능 모델 STL은 스스로 이미지의 변환을 학습하여, 이미지 변환의 종류를 인간이 직접 알려주면서 학습하는 기존 방법들보다 높은 시각 정보 이해 능력을 보였다. 특히, 기존 방법론들을 통해 학습한 모델이 이해할 수 없는 세부적인 특징까지도 학습하여 기존 방법 대비 최대 42% 우수한 성능을 보여줬다.

컴퓨터 비전에서 이미지 변환을 통한 데이터 증강을 활용해 강건한 시각 표현을 학습하는 방식은 일반화 능력을 갖추는 데 효과적이지만, 변환에 따른 시각적 세부 사항을 무시하는 경향이 있어 범용 시각 인공지능 모델로서 한계가 있다.

연구팀이 제안한 STL은 변환 라벨 없이 변환 정보를 학습할 수 있도록 설계된 새로운 학습 기법으로, 라벨 없이 변환 민감 특징을 학습할 수 있다. 또한, 기존 학습 방법 대비 학습 복잡도를 유지한 채로 효율적인 최적화할 수 있는 방법을 제안했다.

실험 결과, STL은 정확하게 객체를 분류하고 탐지 실험에서 가장 낮은 오류율을 기록했다. 또한, STL이 생성한 표현 공간은 변환의 강도와 유형에 따라 명확히 군집화되어 변환 간 관계를 잘 반영하는 것으로 나타났다.

김준모 교수는 "이번에 개발한 STL은 복잡한 변환 패턴을 학습하고 이를 표현 공간에서 효과적으로 반영하는 능력을 통해 변환 민감 특징 학습의 새로운 가능성을 제시했다”며, "라벨 없이도 변환 정보를 학습할 수 있는 기술은 다양한 AI 응용 분야에서 핵심적인 역할을 할 것”이라고 말했다.

우리 대학 전기및전자공학부 유재명 박사과정이 제1 저자로 참여한 이번 연구는 최고 권위 국제 학술지 ‘신경정보처리시스템학회(NeurIPS) 2024’에서 올 12월 발표될 예정이다.(논문명: Self-supervised Transformation Learning for Equivariant Representations)

한편 이번 연구는 이 논문은 2024년도 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행된 연구 성과물(No.RS-2024-00439020, 지속가능한 실시간 멀티모달 인터렉티브 생성 AI 개발, SW스타랩) 이다.

2024.12.15

조회수 4217

-

천천히 걸음 속도 높여도 다 아는 인공지능 기술 개발

최근 건강에 관한 관심이 점차 커지면서 일상생활에서 스마트 워치, 스마트 링 등을 통해 자기 신체 변화를 살펴보는 일이 보편화되었다. 그런데 기존 헬스케어 앱에서는 걷기에서 뛰기로 갑자기 변화를 줄 경우는 잘 측정이 되지만 천천히 속도를 높이는 경우는 측정이 안 되는 현상이 발생했다. 우리 연구진이 완만한 변화에도 동작을 정확하게 파악하는 기술을 개발했다.

우리 대학 전산학부 이재길 교수 연구팀이 다양한 착용 기기 센서 데이터에서 사용자 상태 변화를 정확하게 검출하는 새로운 인공지능 기술을 개발했다고 12일 밝혔다.

보통 헬스케어 앱에서는 센서 데이터를 통해 사용자의 상태 변화를 탐지하여 현재 동작을 정확히 인식하는 기능이 필수이다. 이를 변화점 탐지라 부르며 다양한 인공지능 기술이 변화점 탐지 품질을 향상하기 위해 적용되고 있다.

이재길 교수팀은 사용자의 상태가 급진적으로 변하거나 점진적으로 변하는지에 관계없이 정확하게 잘 동작하는 변화점 탐지 방법론을 개발했다.

연구팀은 각 시점의 센서 데이터를 인공지능 기술을 통해 벡터*로 표현하였을 때, 이러한 벡터가 시간이 지남에 따라 이동하는 방향을 주목하였다. 같은 동작이 유지될 때는 벡터가 이동하는 방향이 급변하는 경향이 크고, 동작이 바뀔 때는 벡터가 직선상으로 이동하는 경향이 크게 나타났다.

*벡터: 사용자의 시점별 상태 특성(이동속도, 자세, 움직임 등)을 나타내는 가장 좋은 수학적 개념

연구팀은 제안한 방법론을 ‘리커브(RECURVE)’라고 명명했다. 리커브(RECURVE)는 양궁 경기에 쓰이는 활의 한 종류이며, 활이 휘어 있는 모습이 데이터의 이동 방향 변화 정도(곡률)로 변화점을 탐지하는 본 방법론의 동작 방식을 잘 나타낸다고 보았다. 이 방법은 변화점 탐지의 기준을 거리에서 곡률이라는 새로운 관점으로 바라본 매우 신선한 방법이라는 평가를 받았다.

연구팀은 변화점 탐지 문제에서 다양한 헬스케어 센서 스트림 데이터를 사용하여 방법론의 우수성을 검증하여 기존 방법론에 비해 최대 12.7% 정확도 향상을 달성했다.

연구팀을 지도한 이재길 교수는 "센서 스트림 데이터 변화점 탐지 분야의 새로운 지평을 열 만한 획기적인 방법이며 실용화 및 기술 이전이 이뤄지면 실시간 데이터 분석 연구 및 디지털 헬스케어 산업에 큰 파급효과를 낼 수 있을 것이다ˮ고 말했다.

데이터사이언스대학원을 졸업한 신유주 박사가 제1 저자, 전산학부 박재현 석사과정 학생이 제2 저자로 참여한 이번 연구는 최고권위 국제학술대회 `신경정보처리시스템학회(NeurIPS) 2024'에서 올 12월 발표될 예정이다. (논문명 : Exploiting Representation Curvature for Boundary Detection in Time Series)

한편, 이 기술은 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 SW컴퓨팅산업원천기술개발사업 SW스타랩 과제로 개발한 연구성과 결과물(RS-2020-II200862, DB4DL: 딥러닝 지원 고사용성 및 고성능 분산 인메모리 DBMS 개발)이다.

천천히 걸음 속도 높여도 다 아는 인공지능 기술 개발

최근 건강에 관한 관심이 점차 커지면서 일상생활에서 스마트 워치, 스마트 링 등을 통해 자기 신체 변화를 살펴보는 일이 보편화되었다. 그런데 기존 헬스케어 앱에서는 걷기에서 뛰기로 갑자기 변화를 줄 경우는 잘 측정이 되지만 천천히 속도를 높이는 경우는 측정이 안 되는 현상이 발생했다. 우리 연구진이 완만한 변화에도 동작을 정확하게 파악하는 기술을 개발했다.

우리 대학 전산학부 이재길 교수 연구팀이 다양한 착용 기기 센서 데이터에서 사용자 상태 변화를 정확하게 검출하는 새로운 인공지능 기술을 개발했다고 12일 밝혔다.

보통 헬스케어 앱에서는 센서 데이터를 통해 사용자의 상태 변화를 탐지하여 현재 동작을 정확히 인식하는 기능이 필수이다. 이를 변화점 탐지라 부르며 다양한 인공지능 기술이 변화점 탐지 품질을 향상하기 위해 적용되고 있다.

이재길 교수팀은 사용자의 상태가 급진적으로 변하거나 점진적으로 변하는지에 관계없이 정확하게 잘 동작하는 변화점 탐지 방법론을 개발했다.

연구팀은 각 시점의 센서 데이터를 인공지능 기술을 통해 벡터*로 표현하였을 때, 이러한 벡터가 시간이 지남에 따라 이동하는 방향을 주목하였다. 같은 동작이 유지될 때는 벡터가 이동하는 방향이 급변하는 경향이 크고, 동작이 바뀔 때는 벡터가 직선상으로 이동하는 경향이 크게 나타났다.

*벡터: 사용자의 시점별 상태 특성(이동속도, 자세, 움직임 등)을 나타내는 가장 좋은 수학적 개념

연구팀은 제안한 방법론을 ‘리커브(RECURVE)’라고 명명했다. 리커브(RECURVE)는 양궁 경기에 쓰이는 활의 한 종류이며, 활이 휘어 있는 모습이 데이터의 이동 방향 변화 정도(곡률)로 변화점을 탐지하는 본 방법론의 동작 방식을 잘 나타낸다고 보았다. 이 방법은 변화점 탐지의 기준을 거리에서 곡률이라는 새로운 관점으로 바라본 매우 신선한 방법이라는 평가를 받았다.

연구팀은 변화점 탐지 문제에서 다양한 헬스케어 센서 스트림 데이터를 사용하여 방법론의 우수성을 검증하여 기존 방법론에 비해 최대 12.7% 정확도 향상을 달성했다.

연구팀을 지도한 이재길 교수는 "센서 스트림 데이터 변화점 탐지 분야의 새로운 지평을 열 만한 획기적인 방법이며 실용화 및 기술 이전이 이뤄지면 실시간 데이터 분석 연구 및 디지털 헬스케어 산업에 큰 파급효과를 낼 수 있을 것이다ˮ고 말했다.

데이터사이언스대학원을 졸업한 신유주 박사가 제1 저자, 전산학부 박재현 석사과정 학생이 제2 저자로 참여한 이번 연구는 최고권위 국제학술대회 `신경정보처리시스템학회(NeurIPS) 2024'에서 올 12월 발표될 예정이다. (논문명 : Exploiting Representation Curvature for Boundary Detection in Time Series)

한편, 이 기술은 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 SW컴퓨팅산업원천기술개발사업 SW스타랩 과제로 개발한 연구성과 결과물(RS-2020-II200862, DB4DL: 딥러닝 지원 고사용성 및 고성능 분산 인메모리 DBMS 개발)이다.

2024.11.12

조회수 4704

기계공학과 구승범 교수팀, NeurIPS 2024 MyoChallenge 대회 보행 부문 우승

우리 대학 기계공학과 구승범 교수 연구팀(박건우 박사과정, 신범수 박사과정, 박종현 박사과정)은 2024년 12월 캐나다 밴쿠버에서 열린 NeurIPS 학회의 경쟁 대회 중 하나인 MyoChallenge 대회에 참가하여, 15개국에서 54팀이 참여한 가운데, 보행 운동 부문 1위를 차지하였다. 이 대회는 Google Deepmind, Google Cloud와 Össur가 후원하였다.

이 대회에서는 인체의 신경근육제어 원리를 연구하기 위한 다물체 동역학 기반의 인체 근골격 시뮬레이션 환경이 제시되었다. 자체 알고리즘으로 작동하는 의족/의수 (Prosthetic limb)가 결합된 인체 모델이 일상 생활 동작(상지 운동, 보행 운동)을 할 수 있도록 인체 근육 제어기를 학습하고, 그 성능을 경쟁하였다. 보행 운동 부문에서는 의족을 장착한 인체 모델이 주어진 트랙(평지, 거친길, 언덕, 계단)에 맞춰 보행할 수 있도록 인체 제어기를 학습하고, 그 안정성과 속도를 평가하였다.

하지에 54개 근육과 오른 다리 의족이 장착된 인체 모델의 근육 활성도를 제어하여, 지면이 고르지 않은 5m x 120m 경기장에서 넘어지지 않고 앞으로 나아가는 경기가 진행되었다. 구승범 교수 연구팀은 심층강화학습 기술과 인체 운동 데이터 기반 동작 생성 기술을 적용하여, 실제 사람이 근육을 제어하여 운동하는 모습을 모방할 수 있는 고성능 인체 운동 제어기를 학습하였다. 특히, 올해는 연구실에서 자체 구축한 120명의 평지, 계단 및 경사로 보행 동작 데이터셋을 사용해서, 인체 모델이 계단 및 경사로 지형에서도 안정적으로 보행할 수 있도록 학습하였다.

이 기술은 인체의 신경운동제어를 모방하여 다양한 상황에서의 보행 동작을 생성할 수 있다. 또한 이번 대회와 같이 인체에 착용하는 보조 장비와 상호 작용 시뮬레이션이 가능하여, 장비/기구의 개발 및 성능 개선에 사용 가능하다.

이번 대회에는 과학기술정보통신부(IITP ETRI 연구개발지원사업, 연구재단 미래유망융합기술파이오니어사업, 연구재단 중견연구자지원사업)의 지원을 받아 참여하였다.

2024.12.24 조회수 3830

기계공학과 구승범 교수팀, NeurIPS 2024 MyoChallenge 대회 보행 부문 우승

우리 대학 기계공학과 구승범 교수 연구팀(박건우 박사과정, 신범수 박사과정, 박종현 박사과정)은 2024년 12월 캐나다 밴쿠버에서 열린 NeurIPS 학회의 경쟁 대회 중 하나인 MyoChallenge 대회에 참가하여, 15개국에서 54팀이 참여한 가운데, 보행 운동 부문 1위를 차지하였다. 이 대회는 Google Deepmind, Google Cloud와 Össur가 후원하였다.

이 대회에서는 인체의 신경근육제어 원리를 연구하기 위한 다물체 동역학 기반의 인체 근골격 시뮬레이션 환경이 제시되었다. 자체 알고리즘으로 작동하는 의족/의수 (Prosthetic limb)가 결합된 인체 모델이 일상 생활 동작(상지 운동, 보행 운동)을 할 수 있도록 인체 근육 제어기를 학습하고, 그 성능을 경쟁하였다. 보행 운동 부문에서는 의족을 장착한 인체 모델이 주어진 트랙(평지, 거친길, 언덕, 계단)에 맞춰 보행할 수 있도록 인체 제어기를 학습하고, 그 안정성과 속도를 평가하였다.

하지에 54개 근육과 오른 다리 의족이 장착된 인체 모델의 근육 활성도를 제어하여, 지면이 고르지 않은 5m x 120m 경기장에서 넘어지지 않고 앞으로 나아가는 경기가 진행되었다. 구승범 교수 연구팀은 심층강화학습 기술과 인체 운동 데이터 기반 동작 생성 기술을 적용하여, 실제 사람이 근육을 제어하여 운동하는 모습을 모방할 수 있는 고성능 인체 운동 제어기를 학습하였다. 특히, 올해는 연구실에서 자체 구축한 120명의 평지, 계단 및 경사로 보행 동작 데이터셋을 사용해서, 인체 모델이 계단 및 경사로 지형에서도 안정적으로 보행할 수 있도록 학습하였다.

이 기술은 인체의 신경운동제어를 모방하여 다양한 상황에서의 보행 동작을 생성할 수 있다. 또한 이번 대회와 같이 인체에 착용하는 보조 장비와 상호 작용 시뮬레이션이 가능하여, 장비/기구의 개발 및 성능 개선에 사용 가능하다.

이번 대회에는 과학기술정보통신부(IITP ETRI 연구개발지원사업, 연구재단 미래유망융합기술파이오니어사업, 연구재단 중견연구자지원사업)의 지원을 받아 참여하였다.

2024.12.24 조회수 3830 인간의 인지 방식과 유사한 AI 모델 개발

우리 연구진이 인간의 인지 방식을 모방해 이미지 변화를 이해하고, 시각적 일반화와 특정성을 동시에 확보하는 인공지능 기술을 개발했다. 이 기술은 의료 영상 분석, 자율주행, 로보틱스 등 다양한 분야에서 이미지를 이해하여 객체를 분류, 탐지하는 데 활용될 전망이다.

우리 대학 전기및전자공학부 김준모 교수 연구팀이 변환 레이블(transformational labels) 없이도 스스로 변환 민감 특징(transformation-sensitive features)을 학습할 수 있는 새로운 시각 인공지능 모델 STL(Self-supervised Transformation Learning)을 개발했다고 13일 밝혔다.

연구팀이 개발한 시각 인공지능 모델 STL은 스스로 이미지의 변환을 학습하여, 이미지 변환의 종류를 인간이 직접 알려주면서 학습하는 기존 방법들보다 높은 시각 정보 이해 능력을 보였다. 특히, 기존 방법론들을 통해 학습한 모델이 이해할 수 없는 세부적인 특징까지도 학습하여 기존 방법 대비 최대 42% 우수한 성능을 보여줬다.

컴퓨터 비전에서 이미지 변환을 통한 데이터 증강을 활용해 강건한 시각 표현을 학습하는 방식은 일반화 능력을 갖추는 데 효과적이지만, 변환에 따른 시각적 세부 사항을 무시하는 경향이 있어 범용 시각 인공지능 모델로서 한계가 있다.

연구팀이 제안한 STL은 변환 라벨 없이 변환 정보를 학습할 수 있도록 설계된 새로운 학습 기법으로, 라벨 없이 변환 민감 특징을 학습할 수 있다. 또한, 기존 학습 방법 대비 학습 복잡도를 유지한 채로 효율적인 최적화할 수 있는 방법을 제안했다.

실험 결과, STL은 정확하게 객체를 분류하고 탐지 실험에서 가장 낮은 오류율을 기록했다. 또한, STL이 생성한 표현 공간은 변환의 강도와 유형에 따라 명확히 군집화되어 변환 간 관계를 잘 반영하는 것으로 나타났다.

김준모 교수는 "이번에 개발한 STL은 복잡한 변환 패턴을 학습하고 이를 표현 공간에서 효과적으로 반영하는 능력을 통해 변환 민감 특징 학습의 새로운 가능성을 제시했다”며, "라벨 없이도 변환 정보를 학습할 수 있는 기술은 다양한 AI 응용 분야에서 핵심적인 역할을 할 것”이라고 말했다.

우리 대학 전기및전자공학부 유재명 박사과정이 제1 저자로 참여한 이번 연구는 최고 권위 국제 학술지 ‘신경정보처리시스템학회(NeurIPS) 2024’에서 올 12월 발표될 예정이다.(논문명: Self-supervised Transformation Learning for Equivariant Representations)

한편 이번 연구는 이 논문은 2024년도 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행된 연구 성과물(No.RS-2024-00439020, 지속가능한 실시간 멀티모달 인터렉티브 생성 AI 개발, SW스타랩) 이다.

2024.12.15 조회수 4217

인간의 인지 방식과 유사한 AI 모델 개발

우리 연구진이 인간의 인지 방식을 모방해 이미지 변화를 이해하고, 시각적 일반화와 특정성을 동시에 확보하는 인공지능 기술을 개발했다. 이 기술은 의료 영상 분석, 자율주행, 로보틱스 등 다양한 분야에서 이미지를 이해하여 객체를 분류, 탐지하는 데 활용될 전망이다.

우리 대학 전기및전자공학부 김준모 교수 연구팀이 변환 레이블(transformational labels) 없이도 스스로 변환 민감 특징(transformation-sensitive features)을 학습할 수 있는 새로운 시각 인공지능 모델 STL(Self-supervised Transformation Learning)을 개발했다고 13일 밝혔다.

연구팀이 개발한 시각 인공지능 모델 STL은 스스로 이미지의 변환을 학습하여, 이미지 변환의 종류를 인간이 직접 알려주면서 학습하는 기존 방법들보다 높은 시각 정보 이해 능력을 보였다. 특히, 기존 방법론들을 통해 학습한 모델이 이해할 수 없는 세부적인 특징까지도 학습하여 기존 방법 대비 최대 42% 우수한 성능을 보여줬다.

컴퓨터 비전에서 이미지 변환을 통한 데이터 증강을 활용해 강건한 시각 표현을 학습하는 방식은 일반화 능력을 갖추는 데 효과적이지만, 변환에 따른 시각적 세부 사항을 무시하는 경향이 있어 범용 시각 인공지능 모델로서 한계가 있다.

연구팀이 제안한 STL은 변환 라벨 없이 변환 정보를 학습할 수 있도록 설계된 새로운 학습 기법으로, 라벨 없이 변환 민감 특징을 학습할 수 있다. 또한, 기존 학습 방법 대비 학습 복잡도를 유지한 채로 효율적인 최적화할 수 있는 방법을 제안했다.

실험 결과, STL은 정확하게 객체를 분류하고 탐지 실험에서 가장 낮은 오류율을 기록했다. 또한, STL이 생성한 표현 공간은 변환의 강도와 유형에 따라 명확히 군집화되어 변환 간 관계를 잘 반영하는 것으로 나타났다.

김준모 교수는 "이번에 개발한 STL은 복잡한 변환 패턴을 학습하고 이를 표현 공간에서 효과적으로 반영하는 능력을 통해 변환 민감 특징 학습의 새로운 가능성을 제시했다”며, "라벨 없이도 변환 정보를 학습할 수 있는 기술은 다양한 AI 응용 분야에서 핵심적인 역할을 할 것”이라고 말했다.

우리 대학 전기및전자공학부 유재명 박사과정이 제1 저자로 참여한 이번 연구는 최고 권위 국제 학술지 ‘신경정보처리시스템학회(NeurIPS) 2024’에서 올 12월 발표될 예정이다.(논문명: Self-supervised Transformation Learning for Equivariant Representations)

한편 이번 연구는 이 논문은 2024년도 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행된 연구 성과물(No.RS-2024-00439020, 지속가능한 실시간 멀티모달 인터렉티브 생성 AI 개발, SW스타랩) 이다.

2024.12.15 조회수 4217 천천히 걸음 속도 높여도 다 아는 인공지능 기술 개발

최근 건강에 관한 관심이 점차 커지면서 일상생활에서 스마트 워치, 스마트 링 등을 통해 자기 신체 변화를 살펴보는 일이 보편화되었다. 그런데 기존 헬스케어 앱에서는 걷기에서 뛰기로 갑자기 변화를 줄 경우는 잘 측정이 되지만 천천히 속도를 높이는 경우는 측정이 안 되는 현상이 발생했다. 우리 연구진이 완만한 변화에도 동작을 정확하게 파악하는 기술을 개발했다.

우리 대학 전산학부 이재길 교수 연구팀이 다양한 착용 기기 센서 데이터에서 사용자 상태 변화를 정확하게 검출하는 새로운 인공지능 기술을 개발했다고 12일 밝혔다.

보통 헬스케어 앱에서는 센서 데이터를 통해 사용자의 상태 변화를 탐지하여 현재 동작을 정확히 인식하는 기능이 필수이다. 이를 변화점 탐지라 부르며 다양한 인공지능 기술이 변화점 탐지 품질을 향상하기 위해 적용되고 있다.

이재길 교수팀은 사용자의 상태가 급진적으로 변하거나 점진적으로 변하는지에 관계없이 정확하게 잘 동작하는 변화점 탐지 방법론을 개발했다.

연구팀은 각 시점의 센서 데이터를 인공지능 기술을 통해 벡터*로 표현하였을 때, 이러한 벡터가 시간이 지남에 따라 이동하는 방향을 주목하였다. 같은 동작이 유지될 때는 벡터가 이동하는 방향이 급변하는 경향이 크고, 동작이 바뀔 때는 벡터가 직선상으로 이동하는 경향이 크게 나타났다.

*벡터: 사용자의 시점별 상태 특성(이동속도, 자세, 움직임 등)을 나타내는 가장 좋은 수학적 개념

연구팀은 제안한 방법론을 ‘리커브(RECURVE)’라고 명명했다. 리커브(RECURVE)는 양궁 경기에 쓰이는 활의 한 종류이며, 활이 휘어 있는 모습이 데이터의 이동 방향 변화 정도(곡률)로 변화점을 탐지하는 본 방법론의 동작 방식을 잘 나타낸다고 보았다. 이 방법은 변화점 탐지의 기준을 거리에서 곡률이라는 새로운 관점으로 바라본 매우 신선한 방법이라는 평가를 받았다.

연구팀은 변화점 탐지 문제에서 다양한 헬스케어 센서 스트림 데이터를 사용하여 방법론의 우수성을 검증하여 기존 방법론에 비해 최대 12.7% 정확도 향상을 달성했다.

연구팀을 지도한 이재길 교수는 "센서 스트림 데이터 변화점 탐지 분야의 새로운 지평을 열 만한 획기적인 방법이며 실용화 및 기술 이전이 이뤄지면 실시간 데이터 분석 연구 및 디지털 헬스케어 산업에 큰 파급효과를 낼 수 있을 것이다ˮ고 말했다.

데이터사이언스대학원을 졸업한 신유주 박사가 제1 저자, 전산학부 박재현 석사과정 학생이 제2 저자로 참여한 이번 연구는 최고권위 국제학술대회 `신경정보처리시스템학회(NeurIPS) 2024'에서 올 12월 발표될 예정이다. (논문명 : Exploiting Representation Curvature for Boundary Detection in Time Series)

한편, 이 기술은 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 SW컴퓨팅산업원천기술개발사업 SW스타랩 과제로 개발한 연구성과 결과물(RS-2020-II200862, DB4DL: 딥러닝 지원 고사용성 및 고성능 분산 인메모리 DBMS 개발)이다.

2024.11.12 조회수 4704

천천히 걸음 속도 높여도 다 아는 인공지능 기술 개발

최근 건강에 관한 관심이 점차 커지면서 일상생활에서 스마트 워치, 스마트 링 등을 통해 자기 신체 변화를 살펴보는 일이 보편화되었다. 그런데 기존 헬스케어 앱에서는 걷기에서 뛰기로 갑자기 변화를 줄 경우는 잘 측정이 되지만 천천히 속도를 높이는 경우는 측정이 안 되는 현상이 발생했다. 우리 연구진이 완만한 변화에도 동작을 정확하게 파악하는 기술을 개발했다.

우리 대학 전산학부 이재길 교수 연구팀이 다양한 착용 기기 센서 데이터에서 사용자 상태 변화를 정확하게 검출하는 새로운 인공지능 기술을 개발했다고 12일 밝혔다.

보통 헬스케어 앱에서는 센서 데이터를 통해 사용자의 상태 변화를 탐지하여 현재 동작을 정확히 인식하는 기능이 필수이다. 이를 변화점 탐지라 부르며 다양한 인공지능 기술이 변화점 탐지 품질을 향상하기 위해 적용되고 있다.

이재길 교수팀은 사용자의 상태가 급진적으로 변하거나 점진적으로 변하는지에 관계없이 정확하게 잘 동작하는 변화점 탐지 방법론을 개발했다.

연구팀은 각 시점의 센서 데이터를 인공지능 기술을 통해 벡터*로 표현하였을 때, 이러한 벡터가 시간이 지남에 따라 이동하는 방향을 주목하였다. 같은 동작이 유지될 때는 벡터가 이동하는 방향이 급변하는 경향이 크고, 동작이 바뀔 때는 벡터가 직선상으로 이동하는 경향이 크게 나타났다.

*벡터: 사용자의 시점별 상태 특성(이동속도, 자세, 움직임 등)을 나타내는 가장 좋은 수학적 개념

연구팀은 제안한 방법론을 ‘리커브(RECURVE)’라고 명명했다. 리커브(RECURVE)는 양궁 경기에 쓰이는 활의 한 종류이며, 활이 휘어 있는 모습이 데이터의 이동 방향 변화 정도(곡률)로 변화점을 탐지하는 본 방법론의 동작 방식을 잘 나타낸다고 보았다. 이 방법은 변화점 탐지의 기준을 거리에서 곡률이라는 새로운 관점으로 바라본 매우 신선한 방법이라는 평가를 받았다.

연구팀은 변화점 탐지 문제에서 다양한 헬스케어 센서 스트림 데이터를 사용하여 방법론의 우수성을 검증하여 기존 방법론에 비해 최대 12.7% 정확도 향상을 달성했다.

연구팀을 지도한 이재길 교수는 "센서 스트림 데이터 변화점 탐지 분야의 새로운 지평을 열 만한 획기적인 방법이며 실용화 및 기술 이전이 이뤄지면 실시간 데이터 분석 연구 및 디지털 헬스케어 산업에 큰 파급효과를 낼 수 있을 것이다ˮ고 말했다.

데이터사이언스대학원을 졸업한 신유주 박사가 제1 저자, 전산학부 박재현 석사과정 학생이 제2 저자로 참여한 이번 연구는 최고권위 국제학술대회 `신경정보처리시스템학회(NeurIPS) 2024'에서 올 12월 발표될 예정이다. (논문명 : Exploiting Representation Curvature for Boundary Detection in Time Series)

한편, 이 기술은 과학기술정보통신부 재원으로 정보통신기획평가원의 지원을 받아 SW컴퓨팅산업원천기술개발사업 SW스타랩 과제로 개발한 연구성과 결과물(RS-2020-II200862, DB4DL: 딥러닝 지원 고사용성 및 고성능 분산 인메모리 DBMS 개발)이다.

2024.11.12 조회수 4704