-

전산학부 구주일 박사과정 학생, 삼성전자 DS부문 산학협력 교류회 최우수논문상 수상

우리 대학 전산학부 구주일(지도교수: 성민혁) 박사과정 학생은 지난 8월 29일 삼성전자 DS부문 산학협력 교류회에서 최우수 논문상을 수상했다. 해당 시상식은 매년 삼성전자와 국내 주요 대학 간 산학협력 성과를 공유하고, 반도체, 인공지능, 바이오, 생명화학공학, 로봇공학 등 다양한 첨단 분야에서 혁신적인 연구를 수행한 연구자들을 격려하기 위해 열린다.

구주일 학생이 최우수 논문상으로 수상한 “Posterior Distillation Sampling” 논문은 세계 최고 권위의 컴퓨터 비전 학회인 Conference on Computer Vision and Pattern Recognition (CVPR 2024)에 게재되었으며, 해당 학회에서 열린 6개의 워크숍에서도 우수성을 인정받아 발표되었다.

본 연구는 텍스트 기반 2D 이미지 생성 모델을 활용해 3D 데이터 (NeRF, 3D Gaussian Splatting)와 벡터기반이미지(SVG) 같은 다양한 비주얼 컨텐츠를 텍스트만으로 변형할 수 있는 새로운 방법론을 제시한다. 해당 방법론은 픽셀기반의 이미지만 변형이 가능하던 기존 방법론들의 한계를 벗어나, 사용자가 텍스트 입력만으로 다양한 비주얼 컨텐츠를 유연하게 변형할 수 있는 가능성을 연다. 이러한 기술을 통해 메타버스와 같은 차세대 컨텐츠 플랫폼에서 컨텐츠 제작 및 변형의 효율성을 크게 향상시킬 수 있을 것으로 기대된다.

수상 논문 5분 설명 영상: https://www.youtube.com/watch?v=GNqJYk949pY

전산학부 구주일 박사과정 학생, 삼성전자 DS부문 산학협력 교류회 최우수논문상 수상

우리 대학 전산학부 구주일(지도교수: 성민혁) 박사과정 학생은 지난 8월 29일 삼성전자 DS부문 산학협력 교류회에서 최우수 논문상을 수상했다. 해당 시상식은 매년 삼성전자와 국내 주요 대학 간 산학협력 성과를 공유하고, 반도체, 인공지능, 바이오, 생명화학공학, 로봇공학 등 다양한 첨단 분야에서 혁신적인 연구를 수행한 연구자들을 격려하기 위해 열린다.

구주일 학생이 최우수 논문상으로 수상한 “Posterior Distillation Sampling” 논문은 세계 최고 권위의 컴퓨터 비전 학회인 Conference on Computer Vision and Pattern Recognition (CVPR 2024)에 게재되었으며, 해당 학회에서 열린 6개의 워크숍에서도 우수성을 인정받아 발표되었다.

본 연구는 텍스트 기반 2D 이미지 생성 모델을 활용해 3D 데이터 (NeRF, 3D Gaussian Splatting)와 벡터기반이미지(SVG) 같은 다양한 비주얼 컨텐츠를 텍스트만으로 변형할 수 있는 새로운 방법론을 제시한다. 해당 방법론은 픽셀기반의 이미지만 변형이 가능하던 기존 방법론들의 한계를 벗어나, 사용자가 텍스트 입력만으로 다양한 비주얼 컨텐츠를 유연하게 변형할 수 있는 가능성을 연다. 이러한 기술을 통해 메타버스와 같은 차세대 컨텐츠 플랫폼에서 컨텐츠 제작 및 변형의 효율성을 크게 향상시킬 수 있을 것으로 기대된다.

수상 논문 5분 설명 영상: https://www.youtube.com/watch?v=GNqJYk949pY

2024.11.29

조회수 3248

-

기계공학과 윤국진 교수 연구팀, CVPR 2024에 9편 논문 발표하며 세계적 성과 달성

우리 대학 기계공학과 윤국진 교수 연구팀이 컴퓨터비전 및 패턴인식 국제학술대회인 CVPR 2024(IEEE/CVF Conference on Computer Vision and Pattern Recognition 2024)에서 구두 발표 논문 1편과 하이라이트 논문 1편을 비롯한 9편의 논문을 발표하여, 컴퓨터비전 분야에서 세계적인 연구 성과를 인정받았다.

1983년부터 개최된 CVPR 학술대회는 매년 열리는 컴퓨터비전과 패턴인식 분야의 최고 권위의 학술 대회로, 구글 Scholar에 따르면 CVPR은 H5-색인 422를 기록하여 공학 및 컴퓨터과학 (Engineering & Computer Science) 전분야에서 1위를 차지한 학술대회이다.

CVPR 2024는 지난 2024년 6월 17일부터 21일까지 미국 시애틀 컨벤션 센터에서 개최되었는데, 올해는 11,532편의 논문이 제출되었고, 그 중 총 2,719편의 논문이 채택되어 23.6%의 채택율을 기록하였다. 특히, 324편의 논문은 하이라이트 논문으로 선정되어 2.81%의 채택율을 기록하였고, 90편의 논문은 구두 발표 논문으로 선정되어 0.78%의 채택율을 기록할 정도로 낮은 채택율을 기록하였다.

윤국진 교수 연구팀은 컴퓨터비전 분야 중에서도 특히 3차원 객체인식, 인체 자세 예측, 비디오 품질 개선, 다중 작업 최적화, 에이전트 경로 예측, 약지도 의미론적 분할 등 최근 많은 주목을 받고 있는 주제에 대해 9편의 논문을 발표하여 학계는 물론 산업계의 주목을 받았다.

특히, 발표된 논문들 중 권혁준 박사과정의 논문은 전체 논문 중 상위 0.78%에 해당하는 구두 발표 논문으로 선정되었으며, 정재우 박사과정과 박대희 박사과정의 논문은전체 논문 중 상위 2.81%에 해당하는 하이라이트 논문 선정되어, 윤국진 교수 연구팀의 연구가 컴퓨터비전 분야에서 매우 높은 학문적 가치를 지닌 것으로 평가받았음을 보여주었다. 또한 윤국진 교수 연구팀의 이번 성과는 단일 연구실에서 다수의 논문이 동일 학회에 채택되는 것이 매우 드문 일임을 고려할 때 더욱 의미있는 성과로 주목 받았다.

윤국진 교수 연구팀의 뛰어난 연구 성과는 인공지능과 컴퓨터비전 분야에서 향후 유사한 연구 분야에서의 새로운 기술 개발과 학문적 발전에 큰 기여를 할 것으로 기대된다. 윤국진 교수 연구팀은 이번 성과를 발판 삼아 앞으로도 컴퓨터 비전의 다양한 연구 주제들을 다뤄가며, 학계에 잔존하는 문제들을 해결하고자 한다.

기계공학과 윤국진 교수 연구팀, CVPR 2024에 9편 논문 발표하며 세계적 성과 달성

우리 대학 기계공학과 윤국진 교수 연구팀이 컴퓨터비전 및 패턴인식 국제학술대회인 CVPR 2024(IEEE/CVF Conference on Computer Vision and Pattern Recognition 2024)에서 구두 발표 논문 1편과 하이라이트 논문 1편을 비롯한 9편의 논문을 발표하여, 컴퓨터비전 분야에서 세계적인 연구 성과를 인정받았다.

1983년부터 개최된 CVPR 학술대회는 매년 열리는 컴퓨터비전과 패턴인식 분야의 최고 권위의 학술 대회로, 구글 Scholar에 따르면 CVPR은 H5-색인 422를 기록하여 공학 및 컴퓨터과학 (Engineering & Computer Science) 전분야에서 1위를 차지한 학술대회이다.

CVPR 2024는 지난 2024년 6월 17일부터 21일까지 미국 시애틀 컨벤션 센터에서 개최되었는데, 올해는 11,532편의 논문이 제출되었고, 그 중 총 2,719편의 논문이 채택되어 23.6%의 채택율을 기록하였다. 특히, 324편의 논문은 하이라이트 논문으로 선정되어 2.81%의 채택율을 기록하였고, 90편의 논문은 구두 발표 논문으로 선정되어 0.78%의 채택율을 기록할 정도로 낮은 채택율을 기록하였다.

윤국진 교수 연구팀은 컴퓨터비전 분야 중에서도 특히 3차원 객체인식, 인체 자세 예측, 비디오 품질 개선, 다중 작업 최적화, 에이전트 경로 예측, 약지도 의미론적 분할 등 최근 많은 주목을 받고 있는 주제에 대해 9편의 논문을 발표하여 학계는 물론 산업계의 주목을 받았다.

특히, 발표된 논문들 중 권혁준 박사과정의 논문은 전체 논문 중 상위 0.78%에 해당하는 구두 발표 논문으로 선정되었으며, 정재우 박사과정과 박대희 박사과정의 논문은전체 논문 중 상위 2.81%에 해당하는 하이라이트 논문 선정되어, 윤국진 교수 연구팀의 연구가 컴퓨터비전 분야에서 매우 높은 학문적 가치를 지닌 것으로 평가받았음을 보여주었다. 또한 윤국진 교수 연구팀의 이번 성과는 단일 연구실에서 다수의 논문이 동일 학회에 채택되는 것이 매우 드문 일임을 고려할 때 더욱 의미있는 성과로 주목 받았다.

윤국진 교수 연구팀의 뛰어난 연구 성과는 인공지능과 컴퓨터비전 분야에서 향후 유사한 연구 분야에서의 새로운 기술 개발과 학문적 발전에 큰 기여를 할 것으로 기대된다. 윤국진 교수 연구팀은 이번 성과를 발판 삼아 앞으로도 컴퓨터 비전의 다양한 연구 주제들을 다뤄가며, 학계에 잔존하는 문제들을 해결하고자 한다.

2024.07.04

조회수 5024

-

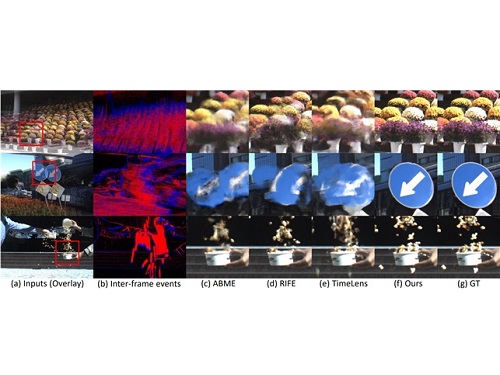

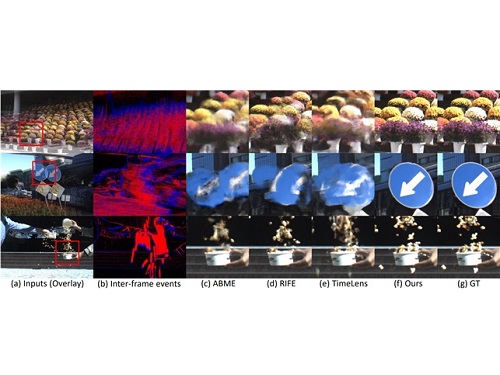

세계 최고 수준의 이벤트 카메라 기반 비디오 보간 기술 개발

비디오 보간은 비디오 사이의 새로운 프레임을 생성하여 프레임률을 높이고 비디오 내 부드러운 모션을 구현하는 기술이다. 전 세계적으로 많은 연구진이 RGB 카메라만을 사용하여 비디오 보간을 수행하였다. 하지만, 프레임 사이의 움직임 정보의 부재로 인하여 복잡한 상황에서 비디오 보간 성능의 한계를 지닌다. 특히, 현실적인 상황에서 발생하는 비선형적인 움직임에 대해서는 비디오 보간 성능이 크게 하락하는 문제점이 존재한다.

우리 대학 기계공학과 윤국진 교수팀은 인간의 시신경을 모방한 이벤트 카메라와 RGB 카메라를 동시에 사용할 수 있는 하이브리드 카메라 시스템을 구축하고 세계 최고 수준의 이벤트 카메라 기반 초고속 비디오 보간 기술을 개발했다. 본 연구는 기존의 비디오 보간 방법 대비 35% 이상의 세계 최고 성능을 달성하였고, 복잡하고 극심한 움직임 속에서도 높은 성능으로 30FPS 비디오를 10000FPS 이상의 초고속 비디오로 합성할 수 있다.

이벤트 카메라는 인간의 시신경을 모방한 카메라로서, 영상의 밝기 변화만을 감지한다. 이러한 특성으로 인하여 이벤트 카메라는 micro 초 단위의 시간 해상도와 높은 dynamic range의 정보를 제공하여 기존의 RGB 카메라가 가지지 못하는 장점을 가지고 있다. 따라서, 이벤트 카메라는 RGB video 프레임 사이의 정확한 움직임 정보를 포착할 수 있어 일반 RGB 카메라와 이벤트 카메라를 동시적으로 사용하면 정확도 높은 초고속 비디오를 생성할 수 있다.

기존의 이벤트 카메라 기반 비디오 보간 연구는 이벤트 카메라에서 나오는 이벤트 정보만을 사용하여 프레임 사이의 광학 흐름을 추정하거나 프레임 사이의 움직임을 근사하는 방법을 사용하였다. 하지만, 이벤트 정보는 공간적으로 희박하고 밝기 정보만을 기록하기 때문에 이벤트만을 사용한 광학 흐름 추정 방법의 결과가 좋지 못한 점을 연구팀은 주목했다. 이를 극복하기 위해 연구팀은 기존의 RGB 이미지와 이벤트 정보를 동시적으로 사용하는 이미지-이벤트 비대칭 양방향 움직임 추정 기법을 제안하였다. 이벤트는 풍부한 움직임의 궤적정보를 제공하는 장점과 이미지의 풍부한 시각 정보의 각 장점을 잘 융합하여 서로 다른 정보의 장단점을 보완 및 융합한 광학 흐름 추정 방법을 제안하여 그 우수성을 입증하였다.

또한, 설계 및 제작한 빔 스플리터 기반 이벤트-RGB 하이브리드 카메라 시스템을 사용하여 이벤트 카메라를 이용한 모션-기반 비디오 보간 기술 데이터셋을 구축하였다. 기존의 이벤트 카메라를 이용한 비디오 보간 데이터셋의 경우, 카메라 움직임이 존재하지 않는 문제와 낮은 프레임 레이트/해상도로 인하여 딥러닝 알고리즘의 학습 및 이벤트 카메라 기반 비디오 보간 기술 개발 및 평가에 한계점을 지닌다. 제안된 데이터셋의 경우 이벤트 카메라 기반 비디오 향상 연구 커뮤니티에 큰 기여를 할 수 있을 것으로 예상된다.

이번 연구는 고품질의 높은 프레임률을 가지는 비디오 생성이 가능하여, 기존의 초고속 카메라로 비디오 촬영이 어려운 광량이 부족한 환경 및 아주 빠른 물체의 움직임을 분석이 필요한 여러 상황 등에서 널리 사용될 수 있을 것으로 기대된다.

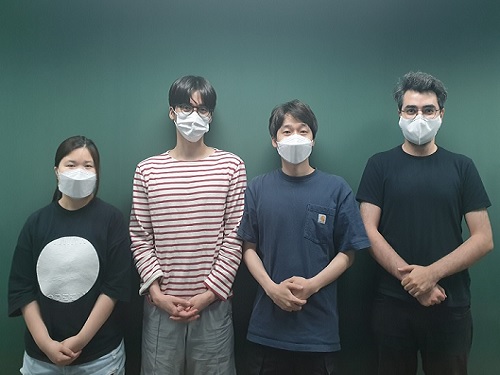

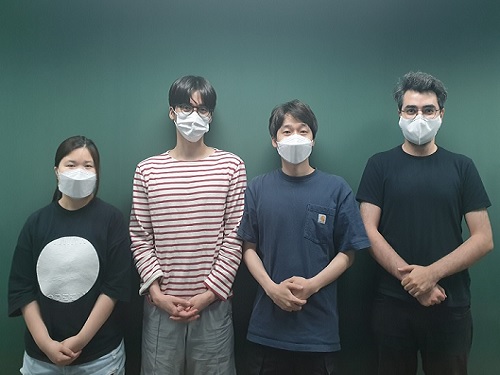

이번 연구는 윤국진 교수 연구실의 김태우 박사과정(제1 저자), 채유정 박사과정(제2 저자), 장현걸 석사과정(제3 저자)이 참여하였고, 올해 캐나다 밴쿠버에서 6월 18일에 열릴 컴퓨터 비전 및 패턴인식 분야의 국제 저명학술지인 CVPR 2023(IEEE Conference on Computer Vision and Pattern Recognition)에 highlight 논문(2.5% acceptance rate)으로 게재될 예정이다.

이 연구는 중견 연구자개발 과제의 지원을 받아 수행되었다. 윤국진 교수 연구팀은 다년간 이벤트 카메라에 관련된 연구를 수행해오면서 이벤트 카메라를 이용한 여러 가지 컴퓨터 비전 분야에 핵심 연구 들을 수행하여 오고 있으며, 앞으로도 이벤트 카메라 연구 커뮤니티에 이바지하기 위하여 지속적인 연구를 수행할 예정이다.

※ 논문명 : Event-based Video Frame Interpolation with Cross-Modal Asymmetric Bidirectional Motion Fields

※ 저자 정보 : 윤국진 (KAIST, 교신저자), 김태우(KAIST, 제1 저자), 채유정(KAIST, 제2 저자), 장현걸(KAIST, 제3 저자) - 총 4명

세계 최고 수준의 이벤트 카메라 기반 비디오 보간 기술 개발

비디오 보간은 비디오 사이의 새로운 프레임을 생성하여 프레임률을 높이고 비디오 내 부드러운 모션을 구현하는 기술이다. 전 세계적으로 많은 연구진이 RGB 카메라만을 사용하여 비디오 보간을 수행하였다. 하지만, 프레임 사이의 움직임 정보의 부재로 인하여 복잡한 상황에서 비디오 보간 성능의 한계를 지닌다. 특히, 현실적인 상황에서 발생하는 비선형적인 움직임에 대해서는 비디오 보간 성능이 크게 하락하는 문제점이 존재한다.

우리 대학 기계공학과 윤국진 교수팀은 인간의 시신경을 모방한 이벤트 카메라와 RGB 카메라를 동시에 사용할 수 있는 하이브리드 카메라 시스템을 구축하고 세계 최고 수준의 이벤트 카메라 기반 초고속 비디오 보간 기술을 개발했다. 본 연구는 기존의 비디오 보간 방법 대비 35% 이상의 세계 최고 성능을 달성하였고, 복잡하고 극심한 움직임 속에서도 높은 성능으로 30FPS 비디오를 10000FPS 이상의 초고속 비디오로 합성할 수 있다.

이벤트 카메라는 인간의 시신경을 모방한 카메라로서, 영상의 밝기 변화만을 감지한다. 이러한 특성으로 인하여 이벤트 카메라는 micro 초 단위의 시간 해상도와 높은 dynamic range의 정보를 제공하여 기존의 RGB 카메라가 가지지 못하는 장점을 가지고 있다. 따라서, 이벤트 카메라는 RGB video 프레임 사이의 정확한 움직임 정보를 포착할 수 있어 일반 RGB 카메라와 이벤트 카메라를 동시적으로 사용하면 정확도 높은 초고속 비디오를 생성할 수 있다.

기존의 이벤트 카메라 기반 비디오 보간 연구는 이벤트 카메라에서 나오는 이벤트 정보만을 사용하여 프레임 사이의 광학 흐름을 추정하거나 프레임 사이의 움직임을 근사하는 방법을 사용하였다. 하지만, 이벤트 정보는 공간적으로 희박하고 밝기 정보만을 기록하기 때문에 이벤트만을 사용한 광학 흐름 추정 방법의 결과가 좋지 못한 점을 연구팀은 주목했다. 이를 극복하기 위해 연구팀은 기존의 RGB 이미지와 이벤트 정보를 동시적으로 사용하는 이미지-이벤트 비대칭 양방향 움직임 추정 기법을 제안하였다. 이벤트는 풍부한 움직임의 궤적정보를 제공하는 장점과 이미지의 풍부한 시각 정보의 각 장점을 잘 융합하여 서로 다른 정보의 장단점을 보완 및 융합한 광학 흐름 추정 방법을 제안하여 그 우수성을 입증하였다.

또한, 설계 및 제작한 빔 스플리터 기반 이벤트-RGB 하이브리드 카메라 시스템을 사용하여 이벤트 카메라를 이용한 모션-기반 비디오 보간 기술 데이터셋을 구축하였다. 기존의 이벤트 카메라를 이용한 비디오 보간 데이터셋의 경우, 카메라 움직임이 존재하지 않는 문제와 낮은 프레임 레이트/해상도로 인하여 딥러닝 알고리즘의 학습 및 이벤트 카메라 기반 비디오 보간 기술 개발 및 평가에 한계점을 지닌다. 제안된 데이터셋의 경우 이벤트 카메라 기반 비디오 향상 연구 커뮤니티에 큰 기여를 할 수 있을 것으로 예상된다.

이번 연구는 고품질의 높은 프레임률을 가지는 비디오 생성이 가능하여, 기존의 초고속 카메라로 비디오 촬영이 어려운 광량이 부족한 환경 및 아주 빠른 물체의 움직임을 분석이 필요한 여러 상황 등에서 널리 사용될 수 있을 것으로 기대된다.

이번 연구는 윤국진 교수 연구실의 김태우 박사과정(제1 저자), 채유정 박사과정(제2 저자), 장현걸 석사과정(제3 저자)이 참여하였고, 올해 캐나다 밴쿠버에서 6월 18일에 열릴 컴퓨터 비전 및 패턴인식 분야의 국제 저명학술지인 CVPR 2023(IEEE Conference on Computer Vision and Pattern Recognition)에 highlight 논문(2.5% acceptance rate)으로 게재될 예정이다.

이 연구는 중견 연구자개발 과제의 지원을 받아 수행되었다. 윤국진 교수 연구팀은 다년간 이벤트 카메라에 관련된 연구를 수행해오면서 이벤트 카메라를 이용한 여러 가지 컴퓨터 비전 분야에 핵심 연구 들을 수행하여 오고 있으며, 앞으로도 이벤트 카메라 연구 커뮤니티에 이바지하기 위하여 지속적인 연구를 수행할 예정이다.

※ 논문명 : Event-based Video Frame Interpolation with Cross-Modal Asymmetric Bidirectional Motion Fields

※ 저자 정보 : 윤국진 (KAIST, 교신저자), 김태우(KAIST, 제1 저자), 채유정(KAIST, 제2 저자), 장현걸(KAIST, 제3 저자) - 총 4명

2023.04.05

조회수 6757

-

딥러닝 생성모델의 오류 수정 기술 개발

우리 대학 AI대학원 최재식 교수(설명가능 인공지능연구센터장) 연구팀이 심층 학습(이하 딥러닝) 생성모델의 오류 수정 기술을 개발했다고 25일 밝혔다.

최근 딥러닝 생성모델(Deep Generative Models)은 이미지, 음성뿐만 아니라 문장 등 새로운 콘텐츠를 생성하는 데 널리 활용되고 있다. 이런 생성모델의 발전에도 불구하고 최근 개발된 생성모델도 여전히 결함이 있는 결과를 만드는 경우가 많아, 국방, 의료, 제조 등 중요한 작업 및 학습에 생성모델을 활용하기는 어려운 점이 있었다.

최 교수 연구팀은 딥러닝 내부를 해석하는 설명가능 인공지능 기법을 활용해, 생성모델 내부에서 이미지 생성과정에서 문제를 일으키는 유닛(뉴런)을 찾아 제거하는 알고리즘을 고안해 생성모델의 오류를 수리했다. 이러한 생성 오류 수리 기술은 신경망 모델의 재학습을 요구하지 않으며 모델 구조에 대한 의존성이 적어, 다양한 적대적 생성 신경망에 폭넓게 응용 및 적용될 수 있을 것으로 기대된다. 또한, 고안된 기술은 딥러닝 생성모델의 신뢰도를 향상해 생성모델이 중요 작업에도 적용될 수 있을 것으로 기대된다.

AI대학원의 알리 투씨(Ali Tousi), 정해동 연구원이 공동 제1 저자로 참여한 이번 연구는 `국제 컴퓨터 비전 및 패턴인식 학술대회 (IEEE Conference on Computer Vision and Pattern Recognition, CVPR)'에서 6월 23일 발표됐다. (논문명: Automatic Correction of Internal Units in Generative Neural Networks, CVPR 2021).

적대적 생성 신경망은 생성기와 구분기의 적대적 관계를 이용한 모델로서, 생성 이미지의 품질이 높고 다양성이 높아, 이미지 생성뿐만 아니라 다양한 분야(예, 시계열 데이터 생성)에서 주목받고 있다.

딥러닝 생성모델의 성능을 향상하기 위해서 적대적 생성기법 및 생성기의 새로운 구조 설계 혹은 학습 전략의 세분화와 같은 연구가 활발히 진행되고 있다. 그러나 최신 적대적 생성 신경망 모델은 여전히 시각적 결함이 포함된 이미지를 생성하고 있으며, 재학습을 통해서 이를 해결하기에는 오류 수리를 보장할 수 없으며, 많은 학습 시간과 비용을 요구하게 된다. 이렇게 규모가 큰 최신 적대적 생성 신경망 모델의 일부 오류를 해결하기 위해 모델 전체를 재학습하는 것은 적합하지 않다.

연구팀은 문제 해결을 위해 생성 오류를 유도하는 딥러닝 내부의 유닛(뉴런)을 찾아 제거하는 알고리즘을 개발했다. 알고리즘은 딥러닝 모델의 시각적 결함의 위치를 파악하고, 딥러닝 모델 내 여러 계층에 존재하는 오류를 유발한 유닛을 찾아서 활성화하지 못하도록 하여 결함이 발생하지 않도록 했다.

연구팀은 설명가능 인공지능 기술을 활용해 시각적 결함이 생성된 이미지의 어느 부분에 분포하는지, 또 딥러닝 내부의 어떤 유닛이 결함의 생성에 관여하는지 찾을 수 있었다. 개발된 기술은 딥러닝 생성모델의 오류를 수리할 수 있고, 생성모델의 구조에 상관없이 적용할 수 있다.

연구팀은 전통적인 구조를 가지는 `진행형 생성모델(Progressive GAN, PGGAN)'에서 개발 기술이 효과적으로 생성 오류를 수리할 수 있음을 확인했다. 수리 성능은 매사추세츠 공과대학(MIT)이 보유한 수리 기술 대비 FID 점수가 10점 정도 감소했으며, 사용자 평가에서 시험 이미지 그룹의 약 50%가 결함이 제거됐고, 약 90%에서 품질이 개선됐다는 결과를 얻었다. 나아가 특이 구조를 가지는 `StyleGAN2'와 `U-net GAN'에서도 생성 오류 수리가 가능함을 보임으로써 개발 기술의 일반성과 확장 가능성을 보였다.

연구팀이 개발한 생성모델의 오류 제거 기술은 다양한 이미지 외에도 다양한 생성모델에 적용돼 모델의 결과물에 대한 신뢰성을 높일 것으로 기대된다.

공동 제1 저자인 알리 투씨와 정해동 연구원은 "딥러닝 생성모델이 생성한 결과물에 있는 시각적 오류를 찾고, 이에 상응하는 활성화를 보이는 생성모델 내부의 유닛을 순차적으로 제거함으로써 생성 오류를 수리할 수 있음을 보였다ˮ라며 이는 "충분히 학습된 모델 내부에 미학습 혹은 잘못 학습된 내부요소가 있음을 보여주는 결과다ˮ라고 말했다.

한편 이번 연구는 2021년도 과학기술정보통신부의 재원으로 정보통신기획평가원의 지원을 받은 혁신성장동력프로젝트 설명가능인공지능 및 한국과학기술원 인공지능 대학원 프로그램과제를 통해서 수행됐다.

딥러닝 생성모델의 오류 수정 기술 개발

우리 대학 AI대학원 최재식 교수(설명가능 인공지능연구센터장) 연구팀이 심층 학습(이하 딥러닝) 생성모델의 오류 수정 기술을 개발했다고 25일 밝혔다.

최근 딥러닝 생성모델(Deep Generative Models)은 이미지, 음성뿐만 아니라 문장 등 새로운 콘텐츠를 생성하는 데 널리 활용되고 있다. 이런 생성모델의 발전에도 불구하고 최근 개발된 생성모델도 여전히 결함이 있는 결과를 만드는 경우가 많아, 국방, 의료, 제조 등 중요한 작업 및 학습에 생성모델을 활용하기는 어려운 점이 있었다.

최 교수 연구팀은 딥러닝 내부를 해석하는 설명가능 인공지능 기법을 활용해, 생성모델 내부에서 이미지 생성과정에서 문제를 일으키는 유닛(뉴런)을 찾아 제거하는 알고리즘을 고안해 생성모델의 오류를 수리했다. 이러한 생성 오류 수리 기술은 신경망 모델의 재학습을 요구하지 않으며 모델 구조에 대한 의존성이 적어, 다양한 적대적 생성 신경망에 폭넓게 응용 및 적용될 수 있을 것으로 기대된다. 또한, 고안된 기술은 딥러닝 생성모델의 신뢰도를 향상해 생성모델이 중요 작업에도 적용될 수 있을 것으로 기대된다.

AI대학원의 알리 투씨(Ali Tousi), 정해동 연구원이 공동 제1 저자로 참여한 이번 연구는 `국제 컴퓨터 비전 및 패턴인식 학술대회 (IEEE Conference on Computer Vision and Pattern Recognition, CVPR)'에서 6월 23일 발표됐다. (논문명: Automatic Correction of Internal Units in Generative Neural Networks, CVPR 2021).

적대적 생성 신경망은 생성기와 구분기의 적대적 관계를 이용한 모델로서, 생성 이미지의 품질이 높고 다양성이 높아, 이미지 생성뿐만 아니라 다양한 분야(예, 시계열 데이터 생성)에서 주목받고 있다.

딥러닝 생성모델의 성능을 향상하기 위해서 적대적 생성기법 및 생성기의 새로운 구조 설계 혹은 학습 전략의 세분화와 같은 연구가 활발히 진행되고 있다. 그러나 최신 적대적 생성 신경망 모델은 여전히 시각적 결함이 포함된 이미지를 생성하고 있으며, 재학습을 통해서 이를 해결하기에는 오류 수리를 보장할 수 없으며, 많은 학습 시간과 비용을 요구하게 된다. 이렇게 규모가 큰 최신 적대적 생성 신경망 모델의 일부 오류를 해결하기 위해 모델 전체를 재학습하는 것은 적합하지 않다.

연구팀은 문제 해결을 위해 생성 오류를 유도하는 딥러닝 내부의 유닛(뉴런)을 찾아 제거하는 알고리즘을 개발했다. 알고리즘은 딥러닝 모델의 시각적 결함의 위치를 파악하고, 딥러닝 모델 내 여러 계층에 존재하는 오류를 유발한 유닛을 찾아서 활성화하지 못하도록 하여 결함이 발생하지 않도록 했다.

연구팀은 설명가능 인공지능 기술을 활용해 시각적 결함이 생성된 이미지의 어느 부분에 분포하는지, 또 딥러닝 내부의 어떤 유닛이 결함의 생성에 관여하는지 찾을 수 있었다. 개발된 기술은 딥러닝 생성모델의 오류를 수리할 수 있고, 생성모델의 구조에 상관없이 적용할 수 있다.

연구팀은 전통적인 구조를 가지는 `진행형 생성모델(Progressive GAN, PGGAN)'에서 개발 기술이 효과적으로 생성 오류를 수리할 수 있음을 확인했다. 수리 성능은 매사추세츠 공과대학(MIT)이 보유한 수리 기술 대비 FID 점수가 10점 정도 감소했으며, 사용자 평가에서 시험 이미지 그룹의 약 50%가 결함이 제거됐고, 약 90%에서 품질이 개선됐다는 결과를 얻었다. 나아가 특이 구조를 가지는 `StyleGAN2'와 `U-net GAN'에서도 생성 오류 수리가 가능함을 보임으로써 개발 기술의 일반성과 확장 가능성을 보였다.

연구팀이 개발한 생성모델의 오류 제거 기술은 다양한 이미지 외에도 다양한 생성모델에 적용돼 모델의 결과물에 대한 신뢰성을 높일 것으로 기대된다.

공동 제1 저자인 알리 투씨와 정해동 연구원은 "딥러닝 생성모델이 생성한 결과물에 있는 시각적 오류를 찾고, 이에 상응하는 활성화를 보이는 생성모델 내부의 유닛을 순차적으로 제거함으로써 생성 오류를 수리할 수 있음을 보였다ˮ라며 이는 "충분히 학습된 모델 내부에 미학습 혹은 잘못 학습된 내부요소가 있음을 보여주는 결과다ˮ라고 말했다.

한편 이번 연구는 2021년도 과학기술정보통신부의 재원으로 정보통신기획평가원의 지원을 받은 혁신성장동력프로젝트 설명가능인공지능 및 한국과학기술원 인공지능 대학원 프로그램과제를 통해서 수행됐다.

2021.06.25

조회수 22398

전산학부 구주일 박사과정 학생, 삼성전자 DS부문 산학협력 교류회 최우수논문상 수상

우리 대학 전산학부 구주일(지도교수: 성민혁) 박사과정 학생은 지난 8월 29일 삼성전자 DS부문 산학협력 교류회에서 최우수 논문상을 수상했다. 해당 시상식은 매년 삼성전자와 국내 주요 대학 간 산학협력 성과를 공유하고, 반도체, 인공지능, 바이오, 생명화학공학, 로봇공학 등 다양한 첨단 분야에서 혁신적인 연구를 수행한 연구자들을 격려하기 위해 열린다.

구주일 학생이 최우수 논문상으로 수상한 “Posterior Distillation Sampling” 논문은 세계 최고 권위의 컴퓨터 비전 학회인 Conference on Computer Vision and Pattern Recognition (CVPR 2024)에 게재되었으며, 해당 학회에서 열린 6개의 워크숍에서도 우수성을 인정받아 발표되었다.

본 연구는 텍스트 기반 2D 이미지 생성 모델을 활용해 3D 데이터 (NeRF, 3D Gaussian Splatting)와 벡터기반이미지(SVG) 같은 다양한 비주얼 컨텐츠를 텍스트만으로 변형할 수 있는 새로운 방법론을 제시한다. 해당 방법론은 픽셀기반의 이미지만 변형이 가능하던 기존 방법론들의 한계를 벗어나, 사용자가 텍스트 입력만으로 다양한 비주얼 컨텐츠를 유연하게 변형할 수 있는 가능성을 연다. 이러한 기술을 통해 메타버스와 같은 차세대 컨텐츠 플랫폼에서 컨텐츠 제작 및 변형의 효율성을 크게 향상시킬 수 있을 것으로 기대된다.

수상 논문 5분 설명 영상: https://www.youtube.com/watch?v=GNqJYk949pY

2024.11.29 조회수 3248

전산학부 구주일 박사과정 학생, 삼성전자 DS부문 산학협력 교류회 최우수논문상 수상

우리 대학 전산학부 구주일(지도교수: 성민혁) 박사과정 학생은 지난 8월 29일 삼성전자 DS부문 산학협력 교류회에서 최우수 논문상을 수상했다. 해당 시상식은 매년 삼성전자와 국내 주요 대학 간 산학협력 성과를 공유하고, 반도체, 인공지능, 바이오, 생명화학공학, 로봇공학 등 다양한 첨단 분야에서 혁신적인 연구를 수행한 연구자들을 격려하기 위해 열린다.

구주일 학생이 최우수 논문상으로 수상한 “Posterior Distillation Sampling” 논문은 세계 최고 권위의 컴퓨터 비전 학회인 Conference on Computer Vision and Pattern Recognition (CVPR 2024)에 게재되었으며, 해당 학회에서 열린 6개의 워크숍에서도 우수성을 인정받아 발표되었다.

본 연구는 텍스트 기반 2D 이미지 생성 모델을 활용해 3D 데이터 (NeRF, 3D Gaussian Splatting)와 벡터기반이미지(SVG) 같은 다양한 비주얼 컨텐츠를 텍스트만으로 변형할 수 있는 새로운 방법론을 제시한다. 해당 방법론은 픽셀기반의 이미지만 변형이 가능하던 기존 방법론들의 한계를 벗어나, 사용자가 텍스트 입력만으로 다양한 비주얼 컨텐츠를 유연하게 변형할 수 있는 가능성을 연다. 이러한 기술을 통해 메타버스와 같은 차세대 컨텐츠 플랫폼에서 컨텐츠 제작 및 변형의 효율성을 크게 향상시킬 수 있을 것으로 기대된다.

수상 논문 5분 설명 영상: https://www.youtube.com/watch?v=GNqJYk949pY

2024.11.29 조회수 3248 기계공학과 윤국진 교수 연구팀, CVPR 2024에 9편 논문 발표하며 세계적 성과 달성

우리 대학 기계공학과 윤국진 교수 연구팀이 컴퓨터비전 및 패턴인식 국제학술대회인 CVPR 2024(IEEE/CVF Conference on Computer Vision and Pattern Recognition 2024)에서 구두 발표 논문 1편과 하이라이트 논문 1편을 비롯한 9편의 논문을 발표하여, 컴퓨터비전 분야에서 세계적인 연구 성과를 인정받았다.

1983년부터 개최된 CVPR 학술대회는 매년 열리는 컴퓨터비전과 패턴인식 분야의 최고 권위의 학술 대회로, 구글 Scholar에 따르면 CVPR은 H5-색인 422를 기록하여 공학 및 컴퓨터과학 (Engineering & Computer Science) 전분야에서 1위를 차지한 학술대회이다.

CVPR 2024는 지난 2024년 6월 17일부터 21일까지 미국 시애틀 컨벤션 센터에서 개최되었는데, 올해는 11,532편의 논문이 제출되었고, 그 중 총 2,719편의 논문이 채택되어 23.6%의 채택율을 기록하였다. 특히, 324편의 논문은 하이라이트 논문으로 선정되어 2.81%의 채택율을 기록하였고, 90편의 논문은 구두 발표 논문으로 선정되어 0.78%의 채택율을 기록할 정도로 낮은 채택율을 기록하였다.

윤국진 교수 연구팀은 컴퓨터비전 분야 중에서도 특히 3차원 객체인식, 인체 자세 예측, 비디오 품질 개선, 다중 작업 최적화, 에이전트 경로 예측, 약지도 의미론적 분할 등 최근 많은 주목을 받고 있는 주제에 대해 9편의 논문을 발표하여 학계는 물론 산업계의 주목을 받았다.

특히, 발표된 논문들 중 권혁준 박사과정의 논문은 전체 논문 중 상위 0.78%에 해당하는 구두 발표 논문으로 선정되었으며, 정재우 박사과정과 박대희 박사과정의 논문은전체 논문 중 상위 2.81%에 해당하는 하이라이트 논문 선정되어, 윤국진 교수 연구팀의 연구가 컴퓨터비전 분야에서 매우 높은 학문적 가치를 지닌 것으로 평가받았음을 보여주었다. 또한 윤국진 교수 연구팀의 이번 성과는 단일 연구실에서 다수의 논문이 동일 학회에 채택되는 것이 매우 드문 일임을 고려할 때 더욱 의미있는 성과로 주목 받았다.

윤국진 교수 연구팀의 뛰어난 연구 성과는 인공지능과 컴퓨터비전 분야에서 향후 유사한 연구 분야에서의 새로운 기술 개발과 학문적 발전에 큰 기여를 할 것으로 기대된다. 윤국진 교수 연구팀은 이번 성과를 발판 삼아 앞으로도 컴퓨터 비전의 다양한 연구 주제들을 다뤄가며, 학계에 잔존하는 문제들을 해결하고자 한다.

2024.07.04 조회수 5024

기계공학과 윤국진 교수 연구팀, CVPR 2024에 9편 논문 발표하며 세계적 성과 달성

우리 대학 기계공학과 윤국진 교수 연구팀이 컴퓨터비전 및 패턴인식 국제학술대회인 CVPR 2024(IEEE/CVF Conference on Computer Vision and Pattern Recognition 2024)에서 구두 발표 논문 1편과 하이라이트 논문 1편을 비롯한 9편의 논문을 발표하여, 컴퓨터비전 분야에서 세계적인 연구 성과를 인정받았다.

1983년부터 개최된 CVPR 학술대회는 매년 열리는 컴퓨터비전과 패턴인식 분야의 최고 권위의 학술 대회로, 구글 Scholar에 따르면 CVPR은 H5-색인 422를 기록하여 공학 및 컴퓨터과학 (Engineering & Computer Science) 전분야에서 1위를 차지한 학술대회이다.

CVPR 2024는 지난 2024년 6월 17일부터 21일까지 미국 시애틀 컨벤션 센터에서 개최되었는데, 올해는 11,532편의 논문이 제출되었고, 그 중 총 2,719편의 논문이 채택되어 23.6%의 채택율을 기록하였다. 특히, 324편의 논문은 하이라이트 논문으로 선정되어 2.81%의 채택율을 기록하였고, 90편의 논문은 구두 발표 논문으로 선정되어 0.78%의 채택율을 기록할 정도로 낮은 채택율을 기록하였다.

윤국진 교수 연구팀은 컴퓨터비전 분야 중에서도 특히 3차원 객체인식, 인체 자세 예측, 비디오 품질 개선, 다중 작업 최적화, 에이전트 경로 예측, 약지도 의미론적 분할 등 최근 많은 주목을 받고 있는 주제에 대해 9편의 논문을 발표하여 학계는 물론 산업계의 주목을 받았다.

특히, 발표된 논문들 중 권혁준 박사과정의 논문은 전체 논문 중 상위 0.78%에 해당하는 구두 발표 논문으로 선정되었으며, 정재우 박사과정과 박대희 박사과정의 논문은전체 논문 중 상위 2.81%에 해당하는 하이라이트 논문 선정되어, 윤국진 교수 연구팀의 연구가 컴퓨터비전 분야에서 매우 높은 학문적 가치를 지닌 것으로 평가받았음을 보여주었다. 또한 윤국진 교수 연구팀의 이번 성과는 단일 연구실에서 다수의 논문이 동일 학회에 채택되는 것이 매우 드문 일임을 고려할 때 더욱 의미있는 성과로 주목 받았다.

윤국진 교수 연구팀의 뛰어난 연구 성과는 인공지능과 컴퓨터비전 분야에서 향후 유사한 연구 분야에서의 새로운 기술 개발과 학문적 발전에 큰 기여를 할 것으로 기대된다. 윤국진 교수 연구팀은 이번 성과를 발판 삼아 앞으로도 컴퓨터 비전의 다양한 연구 주제들을 다뤄가며, 학계에 잔존하는 문제들을 해결하고자 한다.

2024.07.04 조회수 5024 세계 최고 수준의 이벤트 카메라 기반 비디오 보간 기술 개발

비디오 보간은 비디오 사이의 새로운 프레임을 생성하여 프레임률을 높이고 비디오 내 부드러운 모션을 구현하는 기술이다. 전 세계적으로 많은 연구진이 RGB 카메라만을 사용하여 비디오 보간을 수행하였다. 하지만, 프레임 사이의 움직임 정보의 부재로 인하여 복잡한 상황에서 비디오 보간 성능의 한계를 지닌다. 특히, 현실적인 상황에서 발생하는 비선형적인 움직임에 대해서는 비디오 보간 성능이 크게 하락하는 문제점이 존재한다.

우리 대학 기계공학과 윤국진 교수팀은 인간의 시신경을 모방한 이벤트 카메라와 RGB 카메라를 동시에 사용할 수 있는 하이브리드 카메라 시스템을 구축하고 세계 최고 수준의 이벤트 카메라 기반 초고속 비디오 보간 기술을 개발했다. 본 연구는 기존의 비디오 보간 방법 대비 35% 이상의 세계 최고 성능을 달성하였고, 복잡하고 극심한 움직임 속에서도 높은 성능으로 30FPS 비디오를 10000FPS 이상의 초고속 비디오로 합성할 수 있다.

이벤트 카메라는 인간의 시신경을 모방한 카메라로서, 영상의 밝기 변화만을 감지한다. 이러한 특성으로 인하여 이벤트 카메라는 micro 초 단위의 시간 해상도와 높은 dynamic range의 정보를 제공하여 기존의 RGB 카메라가 가지지 못하는 장점을 가지고 있다. 따라서, 이벤트 카메라는 RGB video 프레임 사이의 정확한 움직임 정보를 포착할 수 있어 일반 RGB 카메라와 이벤트 카메라를 동시적으로 사용하면 정확도 높은 초고속 비디오를 생성할 수 있다.

기존의 이벤트 카메라 기반 비디오 보간 연구는 이벤트 카메라에서 나오는 이벤트 정보만을 사용하여 프레임 사이의 광학 흐름을 추정하거나 프레임 사이의 움직임을 근사하는 방법을 사용하였다. 하지만, 이벤트 정보는 공간적으로 희박하고 밝기 정보만을 기록하기 때문에 이벤트만을 사용한 광학 흐름 추정 방법의 결과가 좋지 못한 점을 연구팀은 주목했다. 이를 극복하기 위해 연구팀은 기존의 RGB 이미지와 이벤트 정보를 동시적으로 사용하는 이미지-이벤트 비대칭 양방향 움직임 추정 기법을 제안하였다. 이벤트는 풍부한 움직임의 궤적정보를 제공하는 장점과 이미지의 풍부한 시각 정보의 각 장점을 잘 융합하여 서로 다른 정보의 장단점을 보완 및 융합한 광학 흐름 추정 방법을 제안하여 그 우수성을 입증하였다.

또한, 설계 및 제작한 빔 스플리터 기반 이벤트-RGB 하이브리드 카메라 시스템을 사용하여 이벤트 카메라를 이용한 모션-기반 비디오 보간 기술 데이터셋을 구축하였다. 기존의 이벤트 카메라를 이용한 비디오 보간 데이터셋의 경우, 카메라 움직임이 존재하지 않는 문제와 낮은 프레임 레이트/해상도로 인하여 딥러닝 알고리즘의 학습 및 이벤트 카메라 기반 비디오 보간 기술 개발 및 평가에 한계점을 지닌다. 제안된 데이터셋의 경우 이벤트 카메라 기반 비디오 향상 연구 커뮤니티에 큰 기여를 할 수 있을 것으로 예상된다.

이번 연구는 고품질의 높은 프레임률을 가지는 비디오 생성이 가능하여, 기존의 초고속 카메라로 비디오 촬영이 어려운 광량이 부족한 환경 및 아주 빠른 물체의 움직임을 분석이 필요한 여러 상황 등에서 널리 사용될 수 있을 것으로 기대된다.

이번 연구는 윤국진 교수 연구실의 김태우 박사과정(제1 저자), 채유정 박사과정(제2 저자), 장현걸 석사과정(제3 저자)이 참여하였고, 올해 캐나다 밴쿠버에서 6월 18일에 열릴 컴퓨터 비전 및 패턴인식 분야의 국제 저명학술지인 CVPR 2023(IEEE Conference on Computer Vision and Pattern Recognition)에 highlight 논문(2.5% acceptance rate)으로 게재될 예정이다.

이 연구는 중견 연구자개발 과제의 지원을 받아 수행되었다. 윤국진 교수 연구팀은 다년간 이벤트 카메라에 관련된 연구를 수행해오면서 이벤트 카메라를 이용한 여러 가지 컴퓨터 비전 분야에 핵심 연구 들을 수행하여 오고 있으며, 앞으로도 이벤트 카메라 연구 커뮤니티에 이바지하기 위하여 지속적인 연구를 수행할 예정이다.

※ 논문명 : Event-based Video Frame Interpolation with Cross-Modal Asymmetric Bidirectional Motion Fields

※ 저자 정보 : 윤국진 (KAIST, 교신저자), 김태우(KAIST, 제1 저자), 채유정(KAIST, 제2 저자), 장현걸(KAIST, 제3 저자) - 총 4명

2023.04.05 조회수 6757

세계 최고 수준의 이벤트 카메라 기반 비디오 보간 기술 개발

비디오 보간은 비디오 사이의 새로운 프레임을 생성하여 프레임률을 높이고 비디오 내 부드러운 모션을 구현하는 기술이다. 전 세계적으로 많은 연구진이 RGB 카메라만을 사용하여 비디오 보간을 수행하였다. 하지만, 프레임 사이의 움직임 정보의 부재로 인하여 복잡한 상황에서 비디오 보간 성능의 한계를 지닌다. 특히, 현실적인 상황에서 발생하는 비선형적인 움직임에 대해서는 비디오 보간 성능이 크게 하락하는 문제점이 존재한다.

우리 대학 기계공학과 윤국진 교수팀은 인간의 시신경을 모방한 이벤트 카메라와 RGB 카메라를 동시에 사용할 수 있는 하이브리드 카메라 시스템을 구축하고 세계 최고 수준의 이벤트 카메라 기반 초고속 비디오 보간 기술을 개발했다. 본 연구는 기존의 비디오 보간 방법 대비 35% 이상의 세계 최고 성능을 달성하였고, 복잡하고 극심한 움직임 속에서도 높은 성능으로 30FPS 비디오를 10000FPS 이상의 초고속 비디오로 합성할 수 있다.

이벤트 카메라는 인간의 시신경을 모방한 카메라로서, 영상의 밝기 변화만을 감지한다. 이러한 특성으로 인하여 이벤트 카메라는 micro 초 단위의 시간 해상도와 높은 dynamic range의 정보를 제공하여 기존의 RGB 카메라가 가지지 못하는 장점을 가지고 있다. 따라서, 이벤트 카메라는 RGB video 프레임 사이의 정확한 움직임 정보를 포착할 수 있어 일반 RGB 카메라와 이벤트 카메라를 동시적으로 사용하면 정확도 높은 초고속 비디오를 생성할 수 있다.

기존의 이벤트 카메라 기반 비디오 보간 연구는 이벤트 카메라에서 나오는 이벤트 정보만을 사용하여 프레임 사이의 광학 흐름을 추정하거나 프레임 사이의 움직임을 근사하는 방법을 사용하였다. 하지만, 이벤트 정보는 공간적으로 희박하고 밝기 정보만을 기록하기 때문에 이벤트만을 사용한 광학 흐름 추정 방법의 결과가 좋지 못한 점을 연구팀은 주목했다. 이를 극복하기 위해 연구팀은 기존의 RGB 이미지와 이벤트 정보를 동시적으로 사용하는 이미지-이벤트 비대칭 양방향 움직임 추정 기법을 제안하였다. 이벤트는 풍부한 움직임의 궤적정보를 제공하는 장점과 이미지의 풍부한 시각 정보의 각 장점을 잘 융합하여 서로 다른 정보의 장단점을 보완 및 융합한 광학 흐름 추정 방법을 제안하여 그 우수성을 입증하였다.

또한, 설계 및 제작한 빔 스플리터 기반 이벤트-RGB 하이브리드 카메라 시스템을 사용하여 이벤트 카메라를 이용한 모션-기반 비디오 보간 기술 데이터셋을 구축하였다. 기존의 이벤트 카메라를 이용한 비디오 보간 데이터셋의 경우, 카메라 움직임이 존재하지 않는 문제와 낮은 프레임 레이트/해상도로 인하여 딥러닝 알고리즘의 학습 및 이벤트 카메라 기반 비디오 보간 기술 개발 및 평가에 한계점을 지닌다. 제안된 데이터셋의 경우 이벤트 카메라 기반 비디오 향상 연구 커뮤니티에 큰 기여를 할 수 있을 것으로 예상된다.

이번 연구는 고품질의 높은 프레임률을 가지는 비디오 생성이 가능하여, 기존의 초고속 카메라로 비디오 촬영이 어려운 광량이 부족한 환경 및 아주 빠른 물체의 움직임을 분석이 필요한 여러 상황 등에서 널리 사용될 수 있을 것으로 기대된다.

이번 연구는 윤국진 교수 연구실의 김태우 박사과정(제1 저자), 채유정 박사과정(제2 저자), 장현걸 석사과정(제3 저자)이 참여하였고, 올해 캐나다 밴쿠버에서 6월 18일에 열릴 컴퓨터 비전 및 패턴인식 분야의 국제 저명학술지인 CVPR 2023(IEEE Conference on Computer Vision and Pattern Recognition)에 highlight 논문(2.5% acceptance rate)으로 게재될 예정이다.

이 연구는 중견 연구자개발 과제의 지원을 받아 수행되었다. 윤국진 교수 연구팀은 다년간 이벤트 카메라에 관련된 연구를 수행해오면서 이벤트 카메라를 이용한 여러 가지 컴퓨터 비전 분야에 핵심 연구 들을 수행하여 오고 있으며, 앞으로도 이벤트 카메라 연구 커뮤니티에 이바지하기 위하여 지속적인 연구를 수행할 예정이다.

※ 논문명 : Event-based Video Frame Interpolation with Cross-Modal Asymmetric Bidirectional Motion Fields

※ 저자 정보 : 윤국진 (KAIST, 교신저자), 김태우(KAIST, 제1 저자), 채유정(KAIST, 제2 저자), 장현걸(KAIST, 제3 저자) - 총 4명

2023.04.05 조회수 6757 딥러닝 생성모델의 오류 수정 기술 개발

우리 대학 AI대학원 최재식 교수(설명가능 인공지능연구센터장) 연구팀이 심층 학습(이하 딥러닝) 생성모델의 오류 수정 기술을 개발했다고 25일 밝혔다.

최근 딥러닝 생성모델(Deep Generative Models)은 이미지, 음성뿐만 아니라 문장 등 새로운 콘텐츠를 생성하는 데 널리 활용되고 있다. 이런 생성모델의 발전에도 불구하고 최근 개발된 생성모델도 여전히 결함이 있는 결과를 만드는 경우가 많아, 국방, 의료, 제조 등 중요한 작업 및 학습에 생성모델을 활용하기는 어려운 점이 있었다.

최 교수 연구팀은 딥러닝 내부를 해석하는 설명가능 인공지능 기법을 활용해, 생성모델 내부에서 이미지 생성과정에서 문제를 일으키는 유닛(뉴런)을 찾아 제거하는 알고리즘을 고안해 생성모델의 오류를 수리했다. 이러한 생성 오류 수리 기술은 신경망 모델의 재학습을 요구하지 않으며 모델 구조에 대한 의존성이 적어, 다양한 적대적 생성 신경망에 폭넓게 응용 및 적용될 수 있을 것으로 기대된다. 또한, 고안된 기술은 딥러닝 생성모델의 신뢰도를 향상해 생성모델이 중요 작업에도 적용될 수 있을 것으로 기대된다.

AI대학원의 알리 투씨(Ali Tousi), 정해동 연구원이 공동 제1 저자로 참여한 이번 연구는 `국제 컴퓨터 비전 및 패턴인식 학술대회 (IEEE Conference on Computer Vision and Pattern Recognition, CVPR)'에서 6월 23일 발표됐다. (논문명: Automatic Correction of Internal Units in Generative Neural Networks, CVPR 2021).

적대적 생성 신경망은 생성기와 구분기의 적대적 관계를 이용한 모델로서, 생성 이미지의 품질이 높고 다양성이 높아, 이미지 생성뿐만 아니라 다양한 분야(예, 시계열 데이터 생성)에서 주목받고 있다.

딥러닝 생성모델의 성능을 향상하기 위해서 적대적 생성기법 및 생성기의 새로운 구조 설계 혹은 학습 전략의 세분화와 같은 연구가 활발히 진행되고 있다. 그러나 최신 적대적 생성 신경망 모델은 여전히 시각적 결함이 포함된 이미지를 생성하고 있으며, 재학습을 통해서 이를 해결하기에는 오류 수리를 보장할 수 없으며, 많은 학습 시간과 비용을 요구하게 된다. 이렇게 규모가 큰 최신 적대적 생성 신경망 모델의 일부 오류를 해결하기 위해 모델 전체를 재학습하는 것은 적합하지 않다.

연구팀은 문제 해결을 위해 생성 오류를 유도하는 딥러닝 내부의 유닛(뉴런)을 찾아 제거하는 알고리즘을 개발했다. 알고리즘은 딥러닝 모델의 시각적 결함의 위치를 파악하고, 딥러닝 모델 내 여러 계층에 존재하는 오류를 유발한 유닛을 찾아서 활성화하지 못하도록 하여 결함이 발생하지 않도록 했다.

연구팀은 설명가능 인공지능 기술을 활용해 시각적 결함이 생성된 이미지의 어느 부분에 분포하는지, 또 딥러닝 내부의 어떤 유닛이 결함의 생성에 관여하는지 찾을 수 있었다. 개발된 기술은 딥러닝 생성모델의 오류를 수리할 수 있고, 생성모델의 구조에 상관없이 적용할 수 있다.

연구팀은 전통적인 구조를 가지는 `진행형 생성모델(Progressive GAN, PGGAN)'에서 개발 기술이 효과적으로 생성 오류를 수리할 수 있음을 확인했다. 수리 성능은 매사추세츠 공과대학(MIT)이 보유한 수리 기술 대비 FID 점수가 10점 정도 감소했으며, 사용자 평가에서 시험 이미지 그룹의 약 50%가 결함이 제거됐고, 약 90%에서 품질이 개선됐다는 결과를 얻었다. 나아가 특이 구조를 가지는 `StyleGAN2'와 `U-net GAN'에서도 생성 오류 수리가 가능함을 보임으로써 개발 기술의 일반성과 확장 가능성을 보였다.

연구팀이 개발한 생성모델의 오류 제거 기술은 다양한 이미지 외에도 다양한 생성모델에 적용돼 모델의 결과물에 대한 신뢰성을 높일 것으로 기대된다.

공동 제1 저자인 알리 투씨와 정해동 연구원은 "딥러닝 생성모델이 생성한 결과물에 있는 시각적 오류를 찾고, 이에 상응하는 활성화를 보이는 생성모델 내부의 유닛을 순차적으로 제거함으로써 생성 오류를 수리할 수 있음을 보였다ˮ라며 이는 "충분히 학습된 모델 내부에 미학습 혹은 잘못 학습된 내부요소가 있음을 보여주는 결과다ˮ라고 말했다.

한편 이번 연구는 2021년도 과학기술정보통신부의 재원으로 정보통신기획평가원의 지원을 받은 혁신성장동력프로젝트 설명가능인공지능 및 한국과학기술원 인공지능 대학원 프로그램과제를 통해서 수행됐다.

2021.06.25 조회수 22398

딥러닝 생성모델의 오류 수정 기술 개발

우리 대학 AI대학원 최재식 교수(설명가능 인공지능연구센터장) 연구팀이 심층 학습(이하 딥러닝) 생성모델의 오류 수정 기술을 개발했다고 25일 밝혔다.

최근 딥러닝 생성모델(Deep Generative Models)은 이미지, 음성뿐만 아니라 문장 등 새로운 콘텐츠를 생성하는 데 널리 활용되고 있다. 이런 생성모델의 발전에도 불구하고 최근 개발된 생성모델도 여전히 결함이 있는 결과를 만드는 경우가 많아, 국방, 의료, 제조 등 중요한 작업 및 학습에 생성모델을 활용하기는 어려운 점이 있었다.

최 교수 연구팀은 딥러닝 내부를 해석하는 설명가능 인공지능 기법을 활용해, 생성모델 내부에서 이미지 생성과정에서 문제를 일으키는 유닛(뉴런)을 찾아 제거하는 알고리즘을 고안해 생성모델의 오류를 수리했다. 이러한 생성 오류 수리 기술은 신경망 모델의 재학습을 요구하지 않으며 모델 구조에 대한 의존성이 적어, 다양한 적대적 생성 신경망에 폭넓게 응용 및 적용될 수 있을 것으로 기대된다. 또한, 고안된 기술은 딥러닝 생성모델의 신뢰도를 향상해 생성모델이 중요 작업에도 적용될 수 있을 것으로 기대된다.

AI대학원의 알리 투씨(Ali Tousi), 정해동 연구원이 공동 제1 저자로 참여한 이번 연구는 `국제 컴퓨터 비전 및 패턴인식 학술대회 (IEEE Conference on Computer Vision and Pattern Recognition, CVPR)'에서 6월 23일 발표됐다. (논문명: Automatic Correction of Internal Units in Generative Neural Networks, CVPR 2021).

적대적 생성 신경망은 생성기와 구분기의 적대적 관계를 이용한 모델로서, 생성 이미지의 품질이 높고 다양성이 높아, 이미지 생성뿐만 아니라 다양한 분야(예, 시계열 데이터 생성)에서 주목받고 있다.

딥러닝 생성모델의 성능을 향상하기 위해서 적대적 생성기법 및 생성기의 새로운 구조 설계 혹은 학습 전략의 세분화와 같은 연구가 활발히 진행되고 있다. 그러나 최신 적대적 생성 신경망 모델은 여전히 시각적 결함이 포함된 이미지를 생성하고 있으며, 재학습을 통해서 이를 해결하기에는 오류 수리를 보장할 수 없으며, 많은 학습 시간과 비용을 요구하게 된다. 이렇게 규모가 큰 최신 적대적 생성 신경망 모델의 일부 오류를 해결하기 위해 모델 전체를 재학습하는 것은 적합하지 않다.

연구팀은 문제 해결을 위해 생성 오류를 유도하는 딥러닝 내부의 유닛(뉴런)을 찾아 제거하는 알고리즘을 개발했다. 알고리즘은 딥러닝 모델의 시각적 결함의 위치를 파악하고, 딥러닝 모델 내 여러 계층에 존재하는 오류를 유발한 유닛을 찾아서 활성화하지 못하도록 하여 결함이 발생하지 않도록 했다.

연구팀은 설명가능 인공지능 기술을 활용해 시각적 결함이 생성된 이미지의 어느 부분에 분포하는지, 또 딥러닝 내부의 어떤 유닛이 결함의 생성에 관여하는지 찾을 수 있었다. 개발된 기술은 딥러닝 생성모델의 오류를 수리할 수 있고, 생성모델의 구조에 상관없이 적용할 수 있다.

연구팀은 전통적인 구조를 가지는 `진행형 생성모델(Progressive GAN, PGGAN)'에서 개발 기술이 효과적으로 생성 오류를 수리할 수 있음을 확인했다. 수리 성능은 매사추세츠 공과대학(MIT)이 보유한 수리 기술 대비 FID 점수가 10점 정도 감소했으며, 사용자 평가에서 시험 이미지 그룹의 약 50%가 결함이 제거됐고, 약 90%에서 품질이 개선됐다는 결과를 얻었다. 나아가 특이 구조를 가지는 `StyleGAN2'와 `U-net GAN'에서도 생성 오류 수리가 가능함을 보임으로써 개발 기술의 일반성과 확장 가능성을 보였다.

연구팀이 개발한 생성모델의 오류 제거 기술은 다양한 이미지 외에도 다양한 생성모델에 적용돼 모델의 결과물에 대한 신뢰성을 높일 것으로 기대된다.

공동 제1 저자인 알리 투씨와 정해동 연구원은 "딥러닝 생성모델이 생성한 결과물에 있는 시각적 오류를 찾고, 이에 상응하는 활성화를 보이는 생성모델 내부의 유닛을 순차적으로 제거함으로써 생성 오류를 수리할 수 있음을 보였다ˮ라며 이는 "충분히 학습된 모델 내부에 미학습 혹은 잘못 학습된 내부요소가 있음을 보여주는 결과다ˮ라고 말했다.

한편 이번 연구는 2021년도 과학기술정보통신부의 재원으로 정보통신기획평가원의 지원을 받은 혁신성장동력프로젝트 설명가능인공지능 및 한국과학기술원 인공지능 대학원 프로그램과제를 통해서 수행됐다.

2021.06.25 조회수 22398