%EC%BB%B4%ED%93%A8%ED%84%B0%EB%B9%84%EC%A0%84

-

기계공학과 윤국진 교수 연구팀, 세계 최고 권위 컴퓨터비전 국제학술대회 ICCV 2025에 논문 12편 채택

우리 대학 기계공학과 윤국진 교수 연구팀의 논문 12편이 세계 최고 권위 컴퓨터비전 국제 학술 대회 중 하나인 IEEE/CVF International Conference on Computer Vision 2025(ICCV 2025)에 채택되어, 연구팀의 독보적인 연구 역량을 다시 한번 국제적으로 인정받았다.

ICCV는 CVPR, ECCV와 함께 컴퓨터비전 및 인공지능 분야에서 가장 영향력 있는 국제 학술대회 중 하나로, 1987년부터 격년으로 개최되어 왔다. 이번 ICCV 2025에는 총 11,152편의 논문이 제출되었고, 이 중 2,698편이 채택되어 약 24.19%의 낮은 채택률을 기록하였다. 학술대회에 제출할 수 있는 논문 편수에 대한 제한이 있음에도 불구하고 단일 연구실에서 12편의 논문이 동시 채택되는 것은 매우 드문 성과다.

윤국진 교수 연구팀은 학습 기반의 시각 지능 구현을 목표로 연구를 진행하고 있으며, 이번에 발표된 12편의 논문들은 3D 객체 탐지 및 재구성, 동작 예측 및 계획, 악천후나 모션 블러와 같은 극한 환경에서의 영상 인식 및 개선, 테스트 시점 적응 및 멀티태스크 학습, 4D 맵을 활용한 재구성과 같은 컴퓨터비전 분야의 핵심 주제들에 대한 논문들이다.

특히 연구팀은 지난해 CVPR 2024와 ECCV 2024에서도 각각 9편과 12편의 논문을 발표하여 학계의 주목을 받은 바 있는데, 이번 ICCV 2025에서의 성과를 통해 전 세계 컴퓨터 비전 분야의 선두 연구실로서 입지를 더욱 확고히 했다. 연구팀은 앞으로도 도전적인 연구를 이어가며 학문적·기술적 한계를 확장해 나갈 계획이다.

ICCV 2025는 오는 10월 19일부터 23일까지 미국 하와이 호놀룰루에서 개최될 예정이다.

2025.06.30 조회수 286

기계공학과 윤국진 교수 연구팀, 세계 최고 권위 컴퓨터비전 국제학술대회 ICCV 2025에 논문 12편 채택

우리 대학 기계공학과 윤국진 교수 연구팀의 논문 12편이 세계 최고 권위 컴퓨터비전 국제 학술 대회 중 하나인 IEEE/CVF International Conference on Computer Vision 2025(ICCV 2025)에 채택되어, 연구팀의 독보적인 연구 역량을 다시 한번 국제적으로 인정받았다.

ICCV는 CVPR, ECCV와 함께 컴퓨터비전 및 인공지능 분야에서 가장 영향력 있는 국제 학술대회 중 하나로, 1987년부터 격년으로 개최되어 왔다. 이번 ICCV 2025에는 총 11,152편의 논문이 제출되었고, 이 중 2,698편이 채택되어 약 24.19%의 낮은 채택률을 기록하였다. 학술대회에 제출할 수 있는 논문 편수에 대한 제한이 있음에도 불구하고 단일 연구실에서 12편의 논문이 동시 채택되는 것은 매우 드문 성과다.

윤국진 교수 연구팀은 학습 기반의 시각 지능 구현을 목표로 연구를 진행하고 있으며, 이번에 발표된 12편의 논문들은 3D 객체 탐지 및 재구성, 동작 예측 및 계획, 악천후나 모션 블러와 같은 극한 환경에서의 영상 인식 및 개선, 테스트 시점 적응 및 멀티태스크 학습, 4D 맵을 활용한 재구성과 같은 컴퓨터비전 분야의 핵심 주제들에 대한 논문들이다.

특히 연구팀은 지난해 CVPR 2024와 ECCV 2024에서도 각각 9편과 12편의 논문을 발표하여 학계의 주목을 받은 바 있는데, 이번 ICCV 2025에서의 성과를 통해 전 세계 컴퓨터 비전 분야의 선두 연구실로서 입지를 더욱 확고히 했다. 연구팀은 앞으로도 도전적인 연구를 이어가며 학문적·기술적 한계를 확장해 나갈 계획이다.

ICCV 2025는 오는 10월 19일부터 23일까지 미국 하와이 호놀룰루에서 개최될 예정이다.

2025.06.30 조회수 286 -

윤국진 교수 연구팀, ECCV 2024에 논문 12편 채택

우리 대학 기계공학과 윤국진 교수 연구팀의 논문 12편이 세계 최고 권위 컴퓨터비전 국제학술대회 중 하나인 ECCV 2024 (European Conference on Computer Vision)에 채택되어, 컴퓨터 비전 분야 세계 최고의 연구 역량을 다시 한번 인정받았다. CVPR, ICCV와 함께 컴퓨터 비전 분야 뿐 아니라 전체 인공지능 분야에서도 세계 최고 권위 학술대회로 꼽히는 ECCV는 1990년부터 격년으로 개최되는 학술대회로, Google Scholar 기준 H5-색인 206을 기록하고 있으며, 공학 및 컴퓨터과학 (Engineering & Computer Science)전분야에서 최고 수준의 국제 학술대회 중 하나이다. 이번 ECCV 2024에는 총 8,585개의 논문들이 제출되었고 그 중 2,395개의 논문이 채택되어 약 27.9%의 낮은 채택률을 기록하였다. 단일 연구실에서 12편의 논문이 채택된 것은 극히 이례적인 경우다.

윤국진 교수 연구팀의 논문 12편은 학습 기반의 시각 지능 구현을 연구 논문들로, 가상 시점 합성, 약지도 의미론적 분할, 비디오 품질 개선, 3차원 의미론적 분할, 3차원 객체 인식, 점구름 완성, 이벤트 카메라 기반 낮과 밤 상태 전이, 이벤트 카메라 기반 스테레오 정합, 적대적 공격과 같은 컴퓨터비전 분야의 핵심 주제들에 대한 논문들이다. 특히, 양훈민 박사과정과 정종오 박사과정의 논문 “Prompt-Driven Contrastive Learning for Transferable Adversarial Attacks”은 전체 논문 중 상위 2.3%에 해당하는 구두 발표 논문으로 선정됐다.

앞서 윤국진 교수 연구팀은 올해 6월 개최된 CVPR 2024에도 9편의 논문을 발표한 바 있는데, 이번 ECCV 2024에도 12편의 논문을 발표하게 되어, 컴퓨터 비전 분야에서 세계 최고의 연구 역량을 가진 연구실로 인정받고 있다. 연구팀은 지속적으로 컴퓨터 비전 분야에서 좋은 연구 성과를 달성하고 있기에 앞으로도 도전적인 연구를 계속해 나가며 연구를 진행하겠다는 포부를 밝혔다. ECCV 2024는 2024년 9월 29일부터 10월 4일까지 이탈리아 밀라노의 Mico Milano에서 개최될 예정이다.

2024.08.29 조회수 6964

윤국진 교수 연구팀, ECCV 2024에 논문 12편 채택

우리 대학 기계공학과 윤국진 교수 연구팀의 논문 12편이 세계 최고 권위 컴퓨터비전 국제학술대회 중 하나인 ECCV 2024 (European Conference on Computer Vision)에 채택되어, 컴퓨터 비전 분야 세계 최고의 연구 역량을 다시 한번 인정받았다. CVPR, ICCV와 함께 컴퓨터 비전 분야 뿐 아니라 전체 인공지능 분야에서도 세계 최고 권위 학술대회로 꼽히는 ECCV는 1990년부터 격년으로 개최되는 학술대회로, Google Scholar 기준 H5-색인 206을 기록하고 있으며, 공학 및 컴퓨터과학 (Engineering & Computer Science)전분야에서 최고 수준의 국제 학술대회 중 하나이다. 이번 ECCV 2024에는 총 8,585개의 논문들이 제출되었고 그 중 2,395개의 논문이 채택되어 약 27.9%의 낮은 채택률을 기록하였다. 단일 연구실에서 12편의 논문이 채택된 것은 극히 이례적인 경우다.

윤국진 교수 연구팀의 논문 12편은 학습 기반의 시각 지능 구현을 연구 논문들로, 가상 시점 합성, 약지도 의미론적 분할, 비디오 품질 개선, 3차원 의미론적 분할, 3차원 객체 인식, 점구름 완성, 이벤트 카메라 기반 낮과 밤 상태 전이, 이벤트 카메라 기반 스테레오 정합, 적대적 공격과 같은 컴퓨터비전 분야의 핵심 주제들에 대한 논문들이다. 특히, 양훈민 박사과정과 정종오 박사과정의 논문 “Prompt-Driven Contrastive Learning for Transferable Adversarial Attacks”은 전체 논문 중 상위 2.3%에 해당하는 구두 발표 논문으로 선정됐다.

앞서 윤국진 교수 연구팀은 올해 6월 개최된 CVPR 2024에도 9편의 논문을 발표한 바 있는데, 이번 ECCV 2024에도 12편의 논문을 발표하게 되어, 컴퓨터 비전 분야에서 세계 최고의 연구 역량을 가진 연구실로 인정받고 있다. 연구팀은 지속적으로 컴퓨터 비전 분야에서 좋은 연구 성과를 달성하고 있기에 앞으로도 도전적인 연구를 계속해 나가며 연구를 진행하겠다는 포부를 밝혔다. ECCV 2024는 2024년 9월 29일부터 10월 4일까지 이탈리아 밀라노의 Mico Milano에서 개최될 예정이다.

2024.08.29 조회수 6964 -

차세대 새로운 패러다임 동영상 인식기술 개발

챗GPT와 같은 거대 언어 모델의 근간이 되는 트랜스포머로 구축된 기존 비디오 모델보다 8배 낮은 연산량과 4배 낮은 메모리 사용량으로도 높은 정확도를 기록했으며, 추론 속도 또한 기존 트랜스포머 기반 모델 대비 4배의 매우 빠른 속도를 달성한 동영상 인식기술이 우리 연구진에 의해 개발됐다.

우리 대학 전기및전자공학부 김창익 교수 연구팀이 초고효율 동영상 인식 모델 ‘비디오맘바(VideoMamba)’를 개발했다고 23일 밝혔다.

비디오맘바는 기존 트랜스포머 기반 모델들이 가지고 있는 높은 계산 복잡성을 해결하기 위해 설계된 새로운 동영상 인식 모델이다. 기존의 트랜스포머 기반 모델들은 셀프-어텐션(self-attention)이라는 메커니즘에 의존해 계산 복잡도가 제곱으로 증가하는 문제를 가지고 있었다.

김창익 교수 연구팀의 비디오맘바는 선택적 상태 공간 모델(Selective State Space Model, Selective SSM)* 메커니즘을 활용해 선형 복잡도**로 효율적인 처리가 가능하다. 이를 통해 비디오맘바는 동영상의 시공간적 정보를 효과적으로 포착해 긴 종속성을 가진 동영상 데이터도 효율적으로 처리할 수 있다.

*선택적 상태 공간 모델(Selective SSM): 입력에 따라 동적으로 매개변수를 조정하여 시퀀스 데이터의 문맥을 더 잘 이해하는 상태 공간 모델

**선형 복잡도:입력 데이터의 크기에 비례하여 계산량이 증가하는 알고리즘 복잡도

김창익 교수 연구팀은 동영상 인식 모델의 효율성을 극대화하기 위해 비디오맘바에 1차원 데이터 처리에 국한된 기존 선택적 상태 공간 메커니즘을 3차원 시공간 데이터 분석이 가능하도록 고도화한 시공간적 전방 및 후방 선택적 상태 공간 모델(spatio-temporal forward and backward SSM)을 도입했다. 이 모델은 순서가 없는 공간 정보와 순차적인 시간 정보를 효과적으로 통합해 인식 성능을 향상한다. 연구팀은 다양한 동영상 인식 벤치마크에서 비디오맘바의 성능을 검증했다.

연구팀이 개발한 비디오맘바는 영상 분석이 필요한 다양한 응용 분야에서 효율적이고 실용적인 솔루션을 제공할 수 있다. 예를 들어, 자율주행에서는 주행 영상을 분석해 도로 상황을 정확하게 파악하고, 보행자와 장애물을 실시간으로 인식해 사고를 예방할 수 있다. 의료 분야에서는 수술 영상을 분석해 환자의 상태를 실시간으로 모니터링하고 긴급 상황 발생 시 신속히 대처할 수 있다. 스포츠 분야에서는 경기 중 선수들의 움직임과 전술을 분석해 전략을 개선하고, 훈련 중 피로도나 부상 가능성을 실시간으로 감지해 예방할 수 있다.

연구를 주도한 김창익 교수는 “비디오맘바의 빠른 처리 속도와 낮은 메모리 사용량, 그리고 뛰어난 성능은 우리 생활에서의 다양한 동영상 활용 분야에 큰 장점을 제공할 것이다”고 연구의 의의를 설명했다.

이번 연구에는 전기및전자공학부 박진영 석박사통합과정, 김희선 박사과정, 고강욱 박사과정이 공동 제1 저자, 김민범 박사과정이 공동 저자, 그리고 전기및전자공학부 김창익 교수가 교신 저자로 참여했다. 연구 결과는 올해 9월 이탈리아 밀라노에서 열리는 컴퓨터 비전 분야 최우수 국제 학회 중 하나인 ‘European Conference on Computer Vision(ECCV) 2024’에서 발표될 예정이다. (논문명: VideoMamba: Spatio-Temporal Selective State Space Model)

한편, 이번 연구는 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행됐다. (No. 2020-0-00153, 기계학습 모델 보안 역기능 취약점 자동 탐지 및 방어 기술 개발)

2024.07.23 조회수 5226

차세대 새로운 패러다임 동영상 인식기술 개발

챗GPT와 같은 거대 언어 모델의 근간이 되는 트랜스포머로 구축된 기존 비디오 모델보다 8배 낮은 연산량과 4배 낮은 메모리 사용량으로도 높은 정확도를 기록했으며, 추론 속도 또한 기존 트랜스포머 기반 모델 대비 4배의 매우 빠른 속도를 달성한 동영상 인식기술이 우리 연구진에 의해 개발됐다.

우리 대학 전기및전자공학부 김창익 교수 연구팀이 초고효율 동영상 인식 모델 ‘비디오맘바(VideoMamba)’를 개발했다고 23일 밝혔다.

비디오맘바는 기존 트랜스포머 기반 모델들이 가지고 있는 높은 계산 복잡성을 해결하기 위해 설계된 새로운 동영상 인식 모델이다. 기존의 트랜스포머 기반 모델들은 셀프-어텐션(self-attention)이라는 메커니즘에 의존해 계산 복잡도가 제곱으로 증가하는 문제를 가지고 있었다.

김창익 교수 연구팀의 비디오맘바는 선택적 상태 공간 모델(Selective State Space Model, Selective SSM)* 메커니즘을 활용해 선형 복잡도**로 효율적인 처리가 가능하다. 이를 통해 비디오맘바는 동영상의 시공간적 정보를 효과적으로 포착해 긴 종속성을 가진 동영상 데이터도 효율적으로 처리할 수 있다.

*선택적 상태 공간 모델(Selective SSM): 입력에 따라 동적으로 매개변수를 조정하여 시퀀스 데이터의 문맥을 더 잘 이해하는 상태 공간 모델

**선형 복잡도:입력 데이터의 크기에 비례하여 계산량이 증가하는 알고리즘 복잡도

김창익 교수 연구팀은 동영상 인식 모델의 효율성을 극대화하기 위해 비디오맘바에 1차원 데이터 처리에 국한된 기존 선택적 상태 공간 메커니즘을 3차원 시공간 데이터 분석이 가능하도록 고도화한 시공간적 전방 및 후방 선택적 상태 공간 모델(spatio-temporal forward and backward SSM)을 도입했다. 이 모델은 순서가 없는 공간 정보와 순차적인 시간 정보를 효과적으로 통합해 인식 성능을 향상한다. 연구팀은 다양한 동영상 인식 벤치마크에서 비디오맘바의 성능을 검증했다.

연구팀이 개발한 비디오맘바는 영상 분석이 필요한 다양한 응용 분야에서 효율적이고 실용적인 솔루션을 제공할 수 있다. 예를 들어, 자율주행에서는 주행 영상을 분석해 도로 상황을 정확하게 파악하고, 보행자와 장애물을 실시간으로 인식해 사고를 예방할 수 있다. 의료 분야에서는 수술 영상을 분석해 환자의 상태를 실시간으로 모니터링하고 긴급 상황 발생 시 신속히 대처할 수 있다. 스포츠 분야에서는 경기 중 선수들의 움직임과 전술을 분석해 전략을 개선하고, 훈련 중 피로도나 부상 가능성을 실시간으로 감지해 예방할 수 있다.

연구를 주도한 김창익 교수는 “비디오맘바의 빠른 처리 속도와 낮은 메모리 사용량, 그리고 뛰어난 성능은 우리 생활에서의 다양한 동영상 활용 분야에 큰 장점을 제공할 것이다”고 연구의 의의를 설명했다.

이번 연구에는 전기및전자공학부 박진영 석박사통합과정, 김희선 박사과정, 고강욱 박사과정이 공동 제1 저자, 김민범 박사과정이 공동 저자, 그리고 전기및전자공학부 김창익 교수가 교신 저자로 참여했다. 연구 결과는 올해 9월 이탈리아 밀라노에서 열리는 컴퓨터 비전 분야 최우수 국제 학회 중 하나인 ‘European Conference on Computer Vision(ECCV) 2024’에서 발표될 예정이다. (논문명: VideoMamba: Spatio-Temporal Selective State Space Model)

한편, 이번 연구는 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행됐다. (No. 2020-0-00153, 기계학습 모델 보안 역기능 취약점 자동 탐지 및 방어 기술 개발)

2024.07.23 조회수 5226 -

기계공학과 윤국진 교수 연구팀, CVPR 2024에 9편 논문 발표하며 세계적 성과 달성

우리 대학 기계공학과 윤국진 교수 연구팀이 컴퓨터비전 및 패턴인식 국제학술대회인 CVPR 2024(IEEE/CVF Conference on Computer Vision and Pattern Recognition 2024)에서 구두 발표 논문 1편과 하이라이트 논문 1편을 비롯한 9편의 논문을 발표하여, 컴퓨터비전 분야에서 세계적인 연구 성과를 인정받았다.

1983년부터 개최된 CVPR 학술대회는 매년 열리는 컴퓨터비전과 패턴인식 분야의 최고 권위의 학술 대회로, 구글 Scholar에 따르면 CVPR은 H5-색인 422를 기록하여 공학 및 컴퓨터과학 (Engineering & Computer Science) 전분야에서 1위를 차지한 학술대회이다.

CVPR 2024는 지난 2024년 6월 17일부터 21일까지 미국 시애틀 컨벤션 센터에서 개최되었는데, 올해는 11,532편의 논문이 제출되었고, 그 중 총 2,719편의 논문이 채택되어 23.6%의 채택율을 기록하였다. 특히, 324편의 논문은 하이라이트 논문으로 선정되어 2.81%의 채택율을 기록하였고, 90편의 논문은 구두 발표 논문으로 선정되어 0.78%의 채택율을 기록할 정도로 낮은 채택율을 기록하였다.

윤국진 교수 연구팀은 컴퓨터비전 분야 중에서도 특히 3차원 객체인식, 인체 자세 예측, 비디오 품질 개선, 다중 작업 최적화, 에이전트 경로 예측, 약지도 의미론적 분할 등 최근 많은 주목을 받고 있는 주제에 대해 9편의 논문을 발표하여 학계는 물론 산업계의 주목을 받았다.

특히, 발표된 논문들 중 권혁준 박사과정의 논문은 전체 논문 중 상위 0.78%에 해당하는 구두 발표 논문으로 선정되었으며, 정재우 박사과정과 박대희 박사과정의 논문은전체 논문 중 상위 2.81%에 해당하는 하이라이트 논문 선정되어, 윤국진 교수 연구팀의 연구가 컴퓨터비전 분야에서 매우 높은 학문적 가치를 지닌 것으로 평가받았음을 보여주었다. 또한 윤국진 교수 연구팀의 이번 성과는 단일 연구실에서 다수의 논문이 동일 학회에 채택되는 것이 매우 드문 일임을 고려할 때 더욱 의미있는 성과로 주목 받았다.

윤국진 교수 연구팀의 뛰어난 연구 성과는 인공지능과 컴퓨터비전 분야에서 향후 유사한 연구 분야에서의 새로운 기술 개발과 학문적 발전에 큰 기여를 할 것으로 기대된다. 윤국진 교수 연구팀은 이번 성과를 발판 삼아 앞으로도 컴퓨터 비전의 다양한 연구 주제들을 다뤄가며, 학계에 잔존하는 문제들을 해결하고자 한다.

2024.07.04 조회수 5018

기계공학과 윤국진 교수 연구팀, CVPR 2024에 9편 논문 발표하며 세계적 성과 달성

우리 대학 기계공학과 윤국진 교수 연구팀이 컴퓨터비전 및 패턴인식 국제학술대회인 CVPR 2024(IEEE/CVF Conference on Computer Vision and Pattern Recognition 2024)에서 구두 발표 논문 1편과 하이라이트 논문 1편을 비롯한 9편의 논문을 발표하여, 컴퓨터비전 분야에서 세계적인 연구 성과를 인정받았다.

1983년부터 개최된 CVPR 학술대회는 매년 열리는 컴퓨터비전과 패턴인식 분야의 최고 권위의 학술 대회로, 구글 Scholar에 따르면 CVPR은 H5-색인 422를 기록하여 공학 및 컴퓨터과학 (Engineering & Computer Science) 전분야에서 1위를 차지한 학술대회이다.

CVPR 2024는 지난 2024년 6월 17일부터 21일까지 미국 시애틀 컨벤션 센터에서 개최되었는데, 올해는 11,532편의 논문이 제출되었고, 그 중 총 2,719편의 논문이 채택되어 23.6%의 채택율을 기록하였다. 특히, 324편의 논문은 하이라이트 논문으로 선정되어 2.81%의 채택율을 기록하였고, 90편의 논문은 구두 발표 논문으로 선정되어 0.78%의 채택율을 기록할 정도로 낮은 채택율을 기록하였다.

윤국진 교수 연구팀은 컴퓨터비전 분야 중에서도 특히 3차원 객체인식, 인체 자세 예측, 비디오 품질 개선, 다중 작업 최적화, 에이전트 경로 예측, 약지도 의미론적 분할 등 최근 많은 주목을 받고 있는 주제에 대해 9편의 논문을 발표하여 학계는 물론 산업계의 주목을 받았다.

특히, 발표된 논문들 중 권혁준 박사과정의 논문은 전체 논문 중 상위 0.78%에 해당하는 구두 발표 논문으로 선정되었으며, 정재우 박사과정과 박대희 박사과정의 논문은전체 논문 중 상위 2.81%에 해당하는 하이라이트 논문 선정되어, 윤국진 교수 연구팀의 연구가 컴퓨터비전 분야에서 매우 높은 학문적 가치를 지닌 것으로 평가받았음을 보여주었다. 또한 윤국진 교수 연구팀의 이번 성과는 단일 연구실에서 다수의 논문이 동일 학회에 채택되는 것이 매우 드문 일임을 고려할 때 더욱 의미있는 성과로 주목 받았다.

윤국진 교수 연구팀의 뛰어난 연구 성과는 인공지능과 컴퓨터비전 분야에서 향후 유사한 연구 분야에서의 새로운 기술 개발과 학문적 발전에 큰 기여를 할 것으로 기대된다. 윤국진 교수 연구팀은 이번 성과를 발판 삼아 앞으로도 컴퓨터 비전의 다양한 연구 주제들을 다뤄가며, 학계에 잔존하는 문제들을 해결하고자 한다.

2024.07.04 조회수 5018 -

인공지능 엔진으로 영상 위변조 탐지 기술 개발

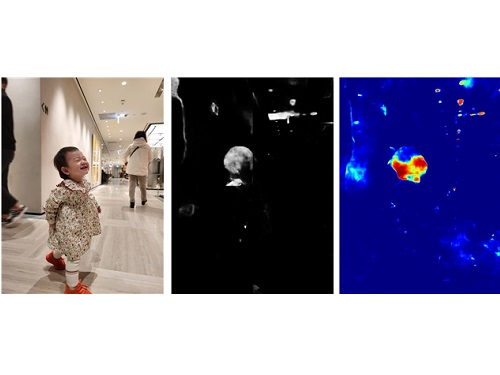

우리 연구진이 영상 내 변형 영역을 더욱 정밀하게 탐지하기 위해 영상내 색상 정보와 주파수 정보를 함께 활용하는 인공지능 엔진 기술을 학계 처음으로 개발했다. 이번 개발 기술은 기존 기술보다 정밀도와 정확도를 크게 높여 위변조 탐지 기술의 기술 유용성을 일정 수준 확보할 수 있는 기반을 제공한다는 점에서 그 의미가 크다. KAIST에서 각종 위변조 영상들을 잡아낸다는 의미를 지닌 `카이캐치(KaiCatch)' 소프트웨어는 이미지, 영상뿐만 아니라 CCTV 비디오 변형 여부도 분석할 수 있다.

우리 대학 전산학부 이흥규 교수 연구팀이 새로운 인공지능 구조와학습 방법론, 그리고 실험실 환경에서는 구하기 힘든 고급 변형 이미지 영상들을 사용해 영상 이미지 위변조 탐지 소프트웨어인 `카이캐치(KaiCatch)'의 영상 이미지 정밀도와 정확도를 크게 높일 뿐만 아니라 비디오 편집 변형도 탐지할 수 있는 카이캐치 2.1 버전을 개발했다고 13일 밝혔다.

카이캐치 소프트웨어는 `이상(異常) 유형 분석 엔진'과 `이상(異常) 영역 추정 엔진' 두 개의 인공지능 엔진으로 구성된다. `이상 유형 분석 엔진'은 블러링, 노이즈, 크기 변화, 명암 대비 변화, 모핑, 리샘플링 등을 필수 변이로 정의해 이를 탐지하며 `이상 영역 추정 엔진'은 이미지 짜깁기, 잘라 붙이기, 복사 붙이기, 복사 이동 등을 탐지한다. 이번에 새로 개발한 기술은 `이상 영역 추정 엔진'으로 기존 기술에서는 이상 영역 탐지 시 그레이 스케일(회색조)로 이상 유무를 탐지하였으나 분석 신호의 표현력이 낮고 탐지 오류가 많아 위변조 여부 판정에 어려움이 많았다. 이번에 개발된 기술은 색상 정보와 주파수 정보를 함께 활용해 정밀도(precision)와 재현율(recall)이 크게 향상되고 변형 영역을 컬러 스케일로 표현함으로써 해당 영역의 이상 유무뿐만 아니라 위변조 여부도 더욱 명확하게 판별이 가능해졌다.

연구팀은 이번 연구에서 영상 생성 시 발생하는 흔적과 압축 시 발생하는 흔적 신호들을 함께 분석하기 위해 색상 정보와 주파수 정보를 모두 활용하는 접근 방법을 학계 처음으로 제시했다. 또 이러한 방법론을 설계 구현하기 위해 주파수 정보를 하나의 분할 네트워크에서 직접 입력으로 받아들이는 방식의 ‘압축 왜곡신호 탐지 네트워크(Compression Artifact Tracing Network, 이하 CAT-Net)’을 학계 최초로 개발하고 기존 기법들과 비교해 탐지 성능이 크게 뛰어남을 입증했다. 개발한 기술은 기존에 제시된 기법들과 비교할 때 특히 원본과 변형본을 판별하는 평가 척도인 F1 점수, 평균 정밀도(average precision)에서 대단히 뛰어나 실환경 위변조 탐지 능력이 크게 강화됐다.

비디오 편집 변형의 경우도, 프레임 삭제, 추가 등에 의한 편집 변형이 흔히 CCTV 비디오 등에서 발생한다는데 착안해 이러한 비디오 편집 변형을 탐지하는 기능 역시 이번 카이캐치 2.1 버전에 탑재됐다.

이번에 카이캐치 2.1 소프트웨어를 연구 개발한 이흥규 교수는 "영상 이미지 위변조 소프트웨어인 카이캐치를 휴대폰에 탑재되는 안드로이드 앱 형태로 일반에 소개한 2021년 3월 이후 현재까지 카이캐치 앱을 통한 900여 건의 위변조 분석 의뢰와 개별적으로 60건이 넘는 정밀 위변조 분석 의뢰를 받았다. KAIST 발표 논문 수준이나 실험 결과 등을 감안할 때 위변조 분야 최고 기술로 만든 소프트웨어인데, 오탐지율이 높아 실제 탐지 정밀도가 이론치보다 매우 낮았다. 많은 경우 위변조나 변형 여부에 대한 명확한 기술 판정이 불가능했으나 이번에 개발한 카이캐치 2.1 은 CAT-Net이라는 새로운 네트워크 구조와 학습 방법론, 그리고 ‘색상 및 주파수 영역 왜곡 흔적 동시 분석’이라는 첨단 기술을 사용해 정밀도를 높여, 보다 명확한 판별이 가능하도록 개발됐다. 앞으로 영상 위변조 판단 여부가 어려운 경우가 많이 줄어들기를 기대한다”고 말했다.

이 교수는 이어 "비디오는 MP4 파일 포맷이, 그리고 영상 이미지는 JPEG 이미지들이 일반인들이 널리 사용한다는 점에서 해당 포맷을 주 개발 대상으로 삼았다. 영상 이미지의 경우 영상 편집 변형 시 영상에 남겨지는 인위적으로 발생하는 JPEG 압축 미세 신호 탐지에 주안점을 두어, 위변조 여부와 위변조 영역을 잡아내는 것에 집중했다. 비디오의 경우 특정 프레임들을 삭제하거나 삽입하는 경우, 프레임 부분 편집 후 재압축 하는 경우 등을 탐지한다. 최근 CCTV 비디오 편집 여부에 대한 분쟁이 많아 크게 도움을 줄 수 있을 것으로 기대하며 향후에도 지속적으로 연구 개발해 취약점들을 보완해 나갈 계획이다ˮ 고 덧붙였다.

현재 카이캐치 소프트웨어는 안드로이드 기반 휴대폰의 구글 플레이스토어에서 ‘카이캐치’를 검색하여 앱을 다운로드 받아 설치한 후, 영상 이미지들을 카이캐치에 업로드하면 위변조 여부를 간단하게 테스트해 볼 수 있다.

한편 이번 연구는 제1 저자로 참여한 우리 대학 전기및전자공학부 권명준 박사, 그리고 김창익 교수, 남승훈 박사, 유인재 박사 등과 공동으로 수행됐으며, `스프링거 네이처(Springer Nature)'에서 발간하는 컴퓨터 비전 분야 톱 국제저널인 `국제 컴퓨터 비전 저널(International Journal of Computer Vision, IF 7.410)'에 2022년 5월 25일 字 온라인판에 게재됐다. (논문명 : Learning JPEG Compression Artifacts for Image Manipulation Detection and Localization)

이번 연구는 한국연구재단 창의도전연구기반지원사업지원과 KAIST 창업기업인 ㈜디지탈이노텍(http://www.kaicatch.com/) 과의 산학협력 연구로 수행됐다.

2022.06.13 조회수 12110

인공지능 엔진으로 영상 위변조 탐지 기술 개발

우리 연구진이 영상 내 변형 영역을 더욱 정밀하게 탐지하기 위해 영상내 색상 정보와 주파수 정보를 함께 활용하는 인공지능 엔진 기술을 학계 처음으로 개발했다. 이번 개발 기술은 기존 기술보다 정밀도와 정확도를 크게 높여 위변조 탐지 기술의 기술 유용성을 일정 수준 확보할 수 있는 기반을 제공한다는 점에서 그 의미가 크다. KAIST에서 각종 위변조 영상들을 잡아낸다는 의미를 지닌 `카이캐치(KaiCatch)' 소프트웨어는 이미지, 영상뿐만 아니라 CCTV 비디오 변형 여부도 분석할 수 있다.

우리 대학 전산학부 이흥규 교수 연구팀이 새로운 인공지능 구조와학습 방법론, 그리고 실험실 환경에서는 구하기 힘든 고급 변형 이미지 영상들을 사용해 영상 이미지 위변조 탐지 소프트웨어인 `카이캐치(KaiCatch)'의 영상 이미지 정밀도와 정확도를 크게 높일 뿐만 아니라 비디오 편집 변형도 탐지할 수 있는 카이캐치 2.1 버전을 개발했다고 13일 밝혔다.

카이캐치 소프트웨어는 `이상(異常) 유형 분석 엔진'과 `이상(異常) 영역 추정 엔진' 두 개의 인공지능 엔진으로 구성된다. `이상 유형 분석 엔진'은 블러링, 노이즈, 크기 변화, 명암 대비 변화, 모핑, 리샘플링 등을 필수 변이로 정의해 이를 탐지하며 `이상 영역 추정 엔진'은 이미지 짜깁기, 잘라 붙이기, 복사 붙이기, 복사 이동 등을 탐지한다. 이번에 새로 개발한 기술은 `이상 영역 추정 엔진'으로 기존 기술에서는 이상 영역 탐지 시 그레이 스케일(회색조)로 이상 유무를 탐지하였으나 분석 신호의 표현력이 낮고 탐지 오류가 많아 위변조 여부 판정에 어려움이 많았다. 이번에 개발된 기술은 색상 정보와 주파수 정보를 함께 활용해 정밀도(precision)와 재현율(recall)이 크게 향상되고 변형 영역을 컬러 스케일로 표현함으로써 해당 영역의 이상 유무뿐만 아니라 위변조 여부도 더욱 명확하게 판별이 가능해졌다.

연구팀은 이번 연구에서 영상 생성 시 발생하는 흔적과 압축 시 발생하는 흔적 신호들을 함께 분석하기 위해 색상 정보와 주파수 정보를 모두 활용하는 접근 방법을 학계 처음으로 제시했다. 또 이러한 방법론을 설계 구현하기 위해 주파수 정보를 하나의 분할 네트워크에서 직접 입력으로 받아들이는 방식의 ‘압축 왜곡신호 탐지 네트워크(Compression Artifact Tracing Network, 이하 CAT-Net)’을 학계 최초로 개발하고 기존 기법들과 비교해 탐지 성능이 크게 뛰어남을 입증했다. 개발한 기술은 기존에 제시된 기법들과 비교할 때 특히 원본과 변형본을 판별하는 평가 척도인 F1 점수, 평균 정밀도(average precision)에서 대단히 뛰어나 실환경 위변조 탐지 능력이 크게 강화됐다.

비디오 편집 변형의 경우도, 프레임 삭제, 추가 등에 의한 편집 변형이 흔히 CCTV 비디오 등에서 발생한다는데 착안해 이러한 비디오 편집 변형을 탐지하는 기능 역시 이번 카이캐치 2.1 버전에 탑재됐다.

이번에 카이캐치 2.1 소프트웨어를 연구 개발한 이흥규 교수는 "영상 이미지 위변조 소프트웨어인 카이캐치를 휴대폰에 탑재되는 안드로이드 앱 형태로 일반에 소개한 2021년 3월 이후 현재까지 카이캐치 앱을 통한 900여 건의 위변조 분석 의뢰와 개별적으로 60건이 넘는 정밀 위변조 분석 의뢰를 받았다. KAIST 발표 논문 수준이나 실험 결과 등을 감안할 때 위변조 분야 최고 기술로 만든 소프트웨어인데, 오탐지율이 높아 실제 탐지 정밀도가 이론치보다 매우 낮았다. 많은 경우 위변조나 변형 여부에 대한 명확한 기술 판정이 불가능했으나 이번에 개발한 카이캐치 2.1 은 CAT-Net이라는 새로운 네트워크 구조와 학습 방법론, 그리고 ‘색상 및 주파수 영역 왜곡 흔적 동시 분석’이라는 첨단 기술을 사용해 정밀도를 높여, 보다 명확한 판별이 가능하도록 개발됐다. 앞으로 영상 위변조 판단 여부가 어려운 경우가 많이 줄어들기를 기대한다”고 말했다.

이 교수는 이어 "비디오는 MP4 파일 포맷이, 그리고 영상 이미지는 JPEG 이미지들이 일반인들이 널리 사용한다는 점에서 해당 포맷을 주 개발 대상으로 삼았다. 영상 이미지의 경우 영상 편집 변형 시 영상에 남겨지는 인위적으로 발생하는 JPEG 압축 미세 신호 탐지에 주안점을 두어, 위변조 여부와 위변조 영역을 잡아내는 것에 집중했다. 비디오의 경우 특정 프레임들을 삭제하거나 삽입하는 경우, 프레임 부분 편집 후 재압축 하는 경우 등을 탐지한다. 최근 CCTV 비디오 편집 여부에 대한 분쟁이 많아 크게 도움을 줄 수 있을 것으로 기대하며 향후에도 지속적으로 연구 개발해 취약점들을 보완해 나갈 계획이다ˮ 고 덧붙였다.

현재 카이캐치 소프트웨어는 안드로이드 기반 휴대폰의 구글 플레이스토어에서 ‘카이캐치’를 검색하여 앱을 다운로드 받아 설치한 후, 영상 이미지들을 카이캐치에 업로드하면 위변조 여부를 간단하게 테스트해 볼 수 있다.

한편 이번 연구는 제1 저자로 참여한 우리 대학 전기및전자공학부 권명준 박사, 그리고 김창익 교수, 남승훈 박사, 유인재 박사 등과 공동으로 수행됐으며, `스프링거 네이처(Springer Nature)'에서 발간하는 컴퓨터 비전 분야 톱 국제저널인 `국제 컴퓨터 비전 저널(International Journal of Computer Vision, IF 7.410)'에 2022년 5월 25일 字 온라인판에 게재됐다. (논문명 : Learning JPEG Compression Artifacts for Image Manipulation Detection and Localization)

이번 연구는 한국연구재단 창의도전연구기반지원사업지원과 KAIST 창업기업인 ㈜디지탈이노텍(http://www.kaicatch.com/) 과의 산학협력 연구로 수행됐다.

2022.06.13 조회수 12110