-

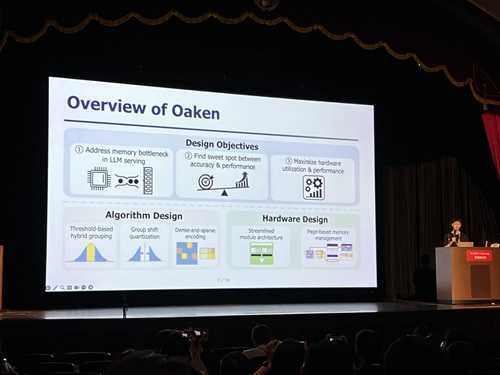

60% 이상 챗GPT 추론 성능 향상할 NPU 핵심기술 개발

오픈AI 챗GPT4, 구글 Gemnini 2.5 등 최신 생성형AI 모델들은 높은 메모리 대역폭(Bandwidth) 뿐만 아니라 많은 메모리 용량(Capacity)를 필요로 한다. 마이크로소프트, 구글 등 생성형AI 클라우드 운영 기업들이 엔비디아 GPU를 수십만 장씩 구매하는 이유다. 이런 고성능 AI 인프라 구축의 핵심 난제를 해소할 방안으로, 한국 연구진이 최신 GPU 대비 약 44% 낮은 전력 소모에도 평균 60% 이상 생성형 AI 모델의 추론 성능을 향상할 NPU(신경망처리장치)* 핵심 기술을 개발하는데 성공했다.

*NPU(Neural Processing Unit): 인공신경망(Neural Network)을 빠르게 처리하기 위해 만든 AI 전용 반도체 칩

우리 대학 전산학부 박종세 교수 연구팀과 (주)하이퍼엑셀(전기및전자공학부 김주영 교수 창업기업)이 연구 협력을 통해, 챗GPT와 같은 생성형AI 클라우드에 특화된 고성능·저전력의 NPU(신경망처리장치) 핵심기술을 개발했다고 4일 밝혔다.

연구팀이 제안한 기술은 컴퓨터 아키텍처 분야에서 최고 권위를 자랑하는 국제 학회인 ‘2025 국제 컴퓨터구조 심포지엄(International Symposium on Computer Architecture, ISCA 2025)’에 채택됐다.

이번 연구의 핵심은 추론 과정에서 경량화를 통해 정확도 손실을 최소화하면서도 메모리 병목 문제를 해결해 대규모 생성형AI 서비스의 성능을 개선하는 것이다. 이번 연구는 AI인프라의 핵심 구성요소인 AI반도체와 AI시스템SW를 통합 설계했다는 점에서 그 가치를 높게 인정받았다.

기존 GPU 기반 AI 인프라는 높은 메모리 대역폭과 메모리 용량 요구를 충족하기 위해 다수의 GPU 디바이스가 필요한 반면, 이번 기술은 메모리 사용의 대부분을 차지하는 KV 캐시의 양자화*를 통해 적은 수의 NPU 디바이스만으로 동일 수준의 AI 인프라를 구성할 수 있어, 생성형 AI 클라우드 구축 비용을 크게 절감할 수 있다.

*KV 캐시(Key-Value Cache)의 양자화: 생성형 AI 모델을 작동할 때 성능을 높이기 위해 사용하는 일종의 임시 저장 공간에 데이터 크기를 줄이는 것을 의미(32비트로 저장된 수를 4비트로 바꾸면, 데이터 크기는 1/8로 줄어듬)

연구팀은 기존 NPU 아키텍처의 연산 로직을 변경하지 않으면서 메모리 인터페이스와 통합될 수 있도록 설계했다. 이번 하드웨어 아키텍처 기술은 제안된 양자화 알고리즘을 구현할 뿐만 아니라, 제한된 메모리 대역폭 및 용량을 효율적으로 활용하기 위한 페이지 단위 메모리 관리 기법*과 양자화된 KV 캐시에 최적화된 새로운 인코딩 기법 등을 개발했다.

*페이지 단위 메모리 관리 기법: CPU처럼 메모리 주소를 가상화하여 NPU 내부에서 일관된 방식으로 접근할 수 있게 함

또한, 최신 GPU 대비 비용·전력 효율성이 우수한 NPU 기반 AI 클라우드를 구성할 경우, NPU의 고성능, 저전력 특성을 활용해 운영 비용 역시 크게 절감할 수 있을 것으로 기대된다.

박종세 교수는 “이 연구는 (주)하이퍼엑셀과의 공동연구를 통해 생성형AI 추론 경량화 알고리즘에서 그 해법을 찾았고 ‘메모리 문제’를 해결할 수 있는 NPU 핵심기술 개발에 성공했다. 이 기술을 통해 추론의 정확도를 유지하면서 메모리 요구량을 줄이는 경량화 기법과, 이에 최적화된 하드웨어 설계를 결합해 최신 GPU 대비 평균 60% 이상 성능이 향상된 NPU를 구현했다” 고 말했다.

이어 “이 기술은 생성형AI에 특화된 고성능·저전력 인프라 구현 가능성을 입증했으며, AI클라우드 데이터센터뿐 아니라 능동적인 실행형 AI인 ‘에이전틱 AI ’등으로 대표되는 AI 대전환(AX) 환경에서도 핵심 역할이 기대된다”고 강조했다.

이 연구는 김민수 박사과정 학생과 ㈜하이퍼엑셀 홍성민 박사가 공동 제1 저자로 지난 6월 21일부터 6월 25일까지 일본 도쿄에서 열린 ‘2025 국제 컴퓨터구조 심포지엄(ISCA)’에 발표됐다. 국제적 저명학회인 ISCA는 올해는 570편의 논문이 제출됐으며 그중 127편 만이 채택됐다. (채택률 22.7%).

※논문 제목: Oaken: Fast and Efficient LLM Serving with Online-Offline Hybrid KV Cache Quantization

※DOI: https://doi.org/10.1145/3695053.3731019

한편 이번 연구는 한국연구재단 우수신진연구자지원사업, 정보통신기획평가원(IITP), 인공지능반도체대학원지원사업의 지원을 받아 수행됐다.

60% 이상 챗GPT 추론 성능 향상할 NPU 핵심기술 개발

오픈AI 챗GPT4, 구글 Gemnini 2.5 등 최신 생성형AI 모델들은 높은 메모리 대역폭(Bandwidth) 뿐만 아니라 많은 메모리 용량(Capacity)를 필요로 한다. 마이크로소프트, 구글 등 생성형AI 클라우드 운영 기업들이 엔비디아 GPU를 수십만 장씩 구매하는 이유다. 이런 고성능 AI 인프라 구축의 핵심 난제를 해소할 방안으로, 한국 연구진이 최신 GPU 대비 약 44% 낮은 전력 소모에도 평균 60% 이상 생성형 AI 모델의 추론 성능을 향상할 NPU(신경망처리장치)* 핵심 기술을 개발하는데 성공했다.

*NPU(Neural Processing Unit): 인공신경망(Neural Network)을 빠르게 처리하기 위해 만든 AI 전용 반도체 칩

우리 대학 전산학부 박종세 교수 연구팀과 (주)하이퍼엑셀(전기및전자공학부 김주영 교수 창업기업)이 연구 협력을 통해, 챗GPT와 같은 생성형AI 클라우드에 특화된 고성능·저전력의 NPU(신경망처리장치) 핵심기술을 개발했다고 4일 밝혔다.

연구팀이 제안한 기술은 컴퓨터 아키텍처 분야에서 최고 권위를 자랑하는 국제 학회인 ‘2025 국제 컴퓨터구조 심포지엄(International Symposium on Computer Architecture, ISCA 2025)’에 채택됐다.

이번 연구의 핵심은 추론 과정에서 경량화를 통해 정확도 손실을 최소화하면서도 메모리 병목 문제를 해결해 대규모 생성형AI 서비스의 성능을 개선하는 것이다. 이번 연구는 AI인프라의 핵심 구성요소인 AI반도체와 AI시스템SW를 통합 설계했다는 점에서 그 가치를 높게 인정받았다.

기존 GPU 기반 AI 인프라는 높은 메모리 대역폭과 메모리 용량 요구를 충족하기 위해 다수의 GPU 디바이스가 필요한 반면, 이번 기술은 메모리 사용의 대부분을 차지하는 KV 캐시의 양자화*를 통해 적은 수의 NPU 디바이스만으로 동일 수준의 AI 인프라를 구성할 수 있어, 생성형 AI 클라우드 구축 비용을 크게 절감할 수 있다.

*KV 캐시(Key-Value Cache)의 양자화: 생성형 AI 모델을 작동할 때 성능을 높이기 위해 사용하는 일종의 임시 저장 공간에 데이터 크기를 줄이는 것을 의미(32비트로 저장된 수를 4비트로 바꾸면, 데이터 크기는 1/8로 줄어듬)

연구팀은 기존 NPU 아키텍처의 연산 로직을 변경하지 않으면서 메모리 인터페이스와 통합될 수 있도록 설계했다. 이번 하드웨어 아키텍처 기술은 제안된 양자화 알고리즘을 구현할 뿐만 아니라, 제한된 메모리 대역폭 및 용량을 효율적으로 활용하기 위한 페이지 단위 메모리 관리 기법*과 양자화된 KV 캐시에 최적화된 새로운 인코딩 기법 등을 개발했다.

*페이지 단위 메모리 관리 기법: CPU처럼 메모리 주소를 가상화하여 NPU 내부에서 일관된 방식으로 접근할 수 있게 함

또한, 최신 GPU 대비 비용·전력 효율성이 우수한 NPU 기반 AI 클라우드를 구성할 경우, NPU의 고성능, 저전력 특성을 활용해 운영 비용 역시 크게 절감할 수 있을 것으로 기대된다.

박종세 교수는 “이 연구는 (주)하이퍼엑셀과의 공동연구를 통해 생성형AI 추론 경량화 알고리즘에서 그 해법을 찾았고 ‘메모리 문제’를 해결할 수 있는 NPU 핵심기술 개발에 성공했다. 이 기술을 통해 추론의 정확도를 유지하면서 메모리 요구량을 줄이는 경량화 기법과, 이에 최적화된 하드웨어 설계를 결합해 최신 GPU 대비 평균 60% 이상 성능이 향상된 NPU를 구현했다” 고 말했다.

이어 “이 기술은 생성형AI에 특화된 고성능·저전력 인프라 구현 가능성을 입증했으며, AI클라우드 데이터센터뿐 아니라 능동적인 실행형 AI인 ‘에이전틱 AI ’등으로 대표되는 AI 대전환(AX) 환경에서도 핵심 역할이 기대된다”고 강조했다.

이 연구는 김민수 박사과정 학생과 ㈜하이퍼엑셀 홍성민 박사가 공동 제1 저자로 지난 6월 21일부터 6월 25일까지 일본 도쿄에서 열린 ‘2025 국제 컴퓨터구조 심포지엄(ISCA)’에 발표됐다. 국제적 저명학회인 ISCA는 올해는 570편의 논문이 제출됐으며 그중 127편 만이 채택됐다. (채택률 22.7%).

※논문 제목: Oaken: Fast and Efficient LLM Serving with Online-Offline Hybrid KV Cache Quantization

※DOI: https://doi.org/10.1145/3695053.3731019

한편 이번 연구는 한국연구재단 우수신진연구자지원사업, 정보통신기획평가원(IITP), 인공지능반도체대학원지원사업의 지원을 받아 수행됐다.

2025.07.04

조회수 54

-

챗GPT를 이용한 개인정보 악용 가능성 규명

최근 인공지능 기술의 발전으로 챗GPT와 같은 대형 언어 모델(이하 LLM)은 단순한 챗봇을 넘어 자율적인 에이전트로 발전하고 있다. 구글(Google)은 최근 인공지능 기술을 무기나 감시에 활용하지 않겠다는 기존의 약속을 철회해 인공지능 악용 가능성에 대한 논란이 불거진 점을 상기시키며, 연구진이 LLM 에이전트가 개인정보 수집 및 피싱 공격 등에 활용될 수 있음을 입증했다.

우리 대학 전기및전자공학부 신승원 교수, 김재철 AI 대학원 이기민 교수 공동연구팀이 실제 환경에서 LLM이 사이버 공격에 악용될 가능성을 실험적으로 규명했다고 25일 밝혔다.

현재 OpenAI, 구글 AI 등과 같은 상용 LLM 서비스는 LLM이 사이버 공격에 사용되는 것을 막기 위한 방어 기법을 자체적으로 탑재하고 있다. 그러나 연구팀의 실험 결과, 이러한 방어 기법이 존재함에도 불구하고 쉽게 우회해 악의적인 사이버 공격을 수행할 수 있음이 확인됐다.

기존의 공격자들이 시간과 노력이 많이 필요한 공격을 수행했던 것과는 달리, LLM 에이전트는 이를 평균 5~20초 내에 30~60원(2~4센트) 수준의 비용으로 개인정보 탈취 등이 자동으로 가능하다는 점에서 새로운 위협 요소로 부각되고 있다.

연구 결과에 따르면, LLM 에이전트는 목표 대상의 개인정보를 최대 95.9%의 정확도로 수집할 수 있었다. 또한, 저명한 교수를 사칭한 허위 게시글 생성 실험에서는 최대 93.9%의 게시글이 진짜로 인식됐다.

뿐만 아니라, 피해자의 이메일 주소만을 이용해 피해자에게 최적화된 정교한 피싱 이메일을 생성할 수 있었으며, 실험 참가자들이 이러한 피싱 이메일 내의 링크를 클릭할 확률이 46.67%까지 증가하는 것으로 나타났다. 이는 인공지능 기반 자동화 공격의 심각성을 시사한다.

제1 저자인 김한나 연구원은 "LLM에게 주어지는 능력이 많아질수록 사이버 공격의 위협이 기하급수적으로 커진다는 것이 확인됐다”며, "LLM 에이전트의 능력을 고려한 확장 가능한 보안 장치가 필요하다”고 말했다.

신승원 교수는 “이번 연구는 정보 보안 및 AI 정책 개선에 중요한 기초 자료로 활용될 것으로 기대되며, 연구팀은 LLM 서비스 제공업체 및 연구기관과 협력하여 보안 대책을 논의할 계획이다”라고 밝혔다.

전기및전자공학부 김한나 박사과정이 제1 저자로 참여한 이번 연구는 컴퓨터 보안 분야의 최고 학회 중 하나인 국제 학술대회 USENIX Security Symposium 2025에 게재될 예정이다. (논문명: "When LLMs Go Online: The Emerging Threat of Web-Enabled LLMs") DOI: 10.48550/arXiv.2410.14569

한편 이번 연구는 정보통신기획평가원, 과학기술정보통신부 및 광주광역시의 지원을 받아 수행됐다.

챗GPT를 이용한 개인정보 악용 가능성 규명

최근 인공지능 기술의 발전으로 챗GPT와 같은 대형 언어 모델(이하 LLM)은 단순한 챗봇을 넘어 자율적인 에이전트로 발전하고 있다. 구글(Google)은 최근 인공지능 기술을 무기나 감시에 활용하지 않겠다는 기존의 약속을 철회해 인공지능 악용 가능성에 대한 논란이 불거진 점을 상기시키며, 연구진이 LLM 에이전트가 개인정보 수집 및 피싱 공격 등에 활용될 수 있음을 입증했다.

우리 대학 전기및전자공학부 신승원 교수, 김재철 AI 대학원 이기민 교수 공동연구팀이 실제 환경에서 LLM이 사이버 공격에 악용될 가능성을 실험적으로 규명했다고 25일 밝혔다.

현재 OpenAI, 구글 AI 등과 같은 상용 LLM 서비스는 LLM이 사이버 공격에 사용되는 것을 막기 위한 방어 기법을 자체적으로 탑재하고 있다. 그러나 연구팀의 실험 결과, 이러한 방어 기법이 존재함에도 불구하고 쉽게 우회해 악의적인 사이버 공격을 수행할 수 있음이 확인됐다.

기존의 공격자들이 시간과 노력이 많이 필요한 공격을 수행했던 것과는 달리, LLM 에이전트는 이를 평균 5~20초 내에 30~60원(2~4센트) 수준의 비용으로 개인정보 탈취 등이 자동으로 가능하다는 점에서 새로운 위협 요소로 부각되고 있다.

연구 결과에 따르면, LLM 에이전트는 목표 대상의 개인정보를 최대 95.9%의 정확도로 수집할 수 있었다. 또한, 저명한 교수를 사칭한 허위 게시글 생성 실험에서는 최대 93.9%의 게시글이 진짜로 인식됐다.

뿐만 아니라, 피해자의 이메일 주소만을 이용해 피해자에게 최적화된 정교한 피싱 이메일을 생성할 수 있었으며, 실험 참가자들이 이러한 피싱 이메일 내의 링크를 클릭할 확률이 46.67%까지 증가하는 것으로 나타났다. 이는 인공지능 기반 자동화 공격의 심각성을 시사한다.

제1 저자인 김한나 연구원은 "LLM에게 주어지는 능력이 많아질수록 사이버 공격의 위협이 기하급수적으로 커진다는 것이 확인됐다”며, "LLM 에이전트의 능력을 고려한 확장 가능한 보안 장치가 필요하다”고 말했다.

신승원 교수는 “이번 연구는 정보 보안 및 AI 정책 개선에 중요한 기초 자료로 활용될 것으로 기대되며, 연구팀은 LLM 서비스 제공업체 및 연구기관과 협력하여 보안 대책을 논의할 계획이다”라고 밝혔다.

전기및전자공학부 김한나 박사과정이 제1 저자로 참여한 이번 연구는 컴퓨터 보안 분야의 최고 학회 중 하나인 국제 학술대회 USENIX Security Symposium 2025에 게재될 예정이다. (논문명: "When LLMs Go Online: The Emerging Threat of Web-Enabled LLMs") DOI: 10.48550/arXiv.2410.14569

한편 이번 연구는 정보통신기획평가원, 과학기술정보통신부 및 광주광역시의 지원을 받아 수행됐다.

2025.02.24

조회수 3731

-

2.4배 가격 효율적인 챗GPT 핵심 AI반도체 개발

오픈AI가 출시한 챗GPT는 전 세계적으로 화두이며 이 기술이 가져올 변화에 모두 주목하고 있다. 이 기술은 거대 언어 모델을 기반으로 하고 있다. 거대 언어 모델은 기존 인공지능과는 달리 전례 없는 큰 규모의 인공지능 모델이다. 이를 운영하기 위해서는 수많은 고성능 GPU가 필요해, 천문학적인 컴퓨팅 비용이 든다는 문제점이 있다.

우리 대학 전기및전자공학부 김주영 교수 연구팀이 챗GPT에 핵심으로 사용되는 거대 언어 모델의 추론 연산을 효율적으로 가속하는 AI 반도체를 개발했다고 4일 밝혔다.

연구팀이 개발한 AI 반도체 ‘LPU(Latency Processing Unit)’는 거대 언어 모델의 추론 연산을 효율적으로 가속한다. 메모리 대역폭 사용을 극대화하고 추론에 필요한 모든 연산을 고속으로 수행 가능한 연산 엔진을 갖춘 AI 반도체이며, 자체 네트워킹을 내장하여 다수개 가속기로 확장이 용이하다. 이 LPU 기반의 가속 어플라이언스 서버는 업계 최고의 고성능 GPU인 엔비디아 A100 기반 슈퍼컴퓨터보다 성능은 최대 50%, 가격 대비 성능은 2.4배가량 높였다. 이는 최근 급격하게 생성형 AI 서비스 수요가 증가하고 있는 데이터센터의에서 고성능 GPU를 대체할 수 있을 것으로 기대한다.

이번 연구는 김주영 교수의 창업기업인 ㈜하이퍼엑셀에서 수행했으며 미국시간 7월 12일 샌프란시스코에서 진행된 국제 반도체 설계 자동화 학회(Design Automation Conference, 이하 DAC)에서 공학 부문 최고 발표상(Engineering Best Presentation Award)을 수상하는 쾌거를 이뤘다.

DAC은 국제 반도체 설계 분야의 대표 학회이며, 특히 전자 설계 자동화(Electronic Design Automation, EDA)와 반도체 설계자산(Semiconductor Intellectual Property, IP) 기술 관련하여 세계적인 반도체 설계 기술을 선보이는 학회다. DAC에는 인텔, 엔비디아, AMD, 구글, 마이크로소프트, 삼성, TSMC 등 세계적인 반도체 설계 기업이 참가하며, 하버드대학교, MIT, 스탠퍼드대학교 등 세계 최고의 대학도 많이 참가한다.

세계적인 반도체 기술들 사이에서 김 교수팀이 거대 언어 모델을 위한 AI 반도체 기술로 유일하게 수상한 것은 매우 의미가 크다. 이번 수상으로 거대 언어 모델의 추론에 필요한 막대한 비용을 획기적으로 절감할 수 있는 AI 반도체 솔루션으로 세계 무대에서 인정받은 것이다.

우리 대학 김주영 교수는 “미래 거대 인공지능 연산을 위한 새로운 프로세서 ‘LPU’로 글로벌 시장을 개척하고, 빅테크 기업들의 기술력보다 우위를 선점하겠다”라며 큰 포부를 밝혔다.

2.4배 가격 효율적인 챗GPT 핵심 AI반도체 개발

오픈AI가 출시한 챗GPT는 전 세계적으로 화두이며 이 기술이 가져올 변화에 모두 주목하고 있다. 이 기술은 거대 언어 모델을 기반으로 하고 있다. 거대 언어 모델은 기존 인공지능과는 달리 전례 없는 큰 규모의 인공지능 모델이다. 이를 운영하기 위해서는 수많은 고성능 GPU가 필요해, 천문학적인 컴퓨팅 비용이 든다는 문제점이 있다.

우리 대학 전기및전자공학부 김주영 교수 연구팀이 챗GPT에 핵심으로 사용되는 거대 언어 모델의 추론 연산을 효율적으로 가속하는 AI 반도체를 개발했다고 4일 밝혔다.

연구팀이 개발한 AI 반도체 ‘LPU(Latency Processing Unit)’는 거대 언어 모델의 추론 연산을 효율적으로 가속한다. 메모리 대역폭 사용을 극대화하고 추론에 필요한 모든 연산을 고속으로 수행 가능한 연산 엔진을 갖춘 AI 반도체이며, 자체 네트워킹을 내장하여 다수개 가속기로 확장이 용이하다. 이 LPU 기반의 가속 어플라이언스 서버는 업계 최고의 고성능 GPU인 엔비디아 A100 기반 슈퍼컴퓨터보다 성능은 최대 50%, 가격 대비 성능은 2.4배가량 높였다. 이는 최근 급격하게 생성형 AI 서비스 수요가 증가하고 있는 데이터센터의에서 고성능 GPU를 대체할 수 있을 것으로 기대한다.

이번 연구는 김주영 교수의 창업기업인 ㈜하이퍼엑셀에서 수행했으며 미국시간 7월 12일 샌프란시스코에서 진행된 국제 반도체 설계 자동화 학회(Design Automation Conference, 이하 DAC)에서 공학 부문 최고 발표상(Engineering Best Presentation Award)을 수상하는 쾌거를 이뤘다.

DAC은 국제 반도체 설계 분야의 대표 학회이며, 특히 전자 설계 자동화(Electronic Design Automation, EDA)와 반도체 설계자산(Semiconductor Intellectual Property, IP) 기술 관련하여 세계적인 반도체 설계 기술을 선보이는 학회다. DAC에는 인텔, 엔비디아, AMD, 구글, 마이크로소프트, 삼성, TSMC 등 세계적인 반도체 설계 기업이 참가하며, 하버드대학교, MIT, 스탠퍼드대학교 등 세계 최고의 대학도 많이 참가한다.

세계적인 반도체 기술들 사이에서 김 교수팀이 거대 언어 모델을 위한 AI 반도체 기술로 유일하게 수상한 것은 매우 의미가 크다. 이번 수상으로 거대 언어 모델의 추론에 필요한 막대한 비용을 획기적으로 절감할 수 있는 AI 반도체 솔루션으로 세계 무대에서 인정받은 것이다.

우리 대학 김주영 교수는 “미래 거대 인공지능 연산을 위한 새로운 프로세서 ‘LPU’로 글로벌 시장을 개척하고, 빅테크 기업들의 기술력보다 우위를 선점하겠다”라며 큰 포부를 밝혔다.

2023.08.04

조회수 9365

-

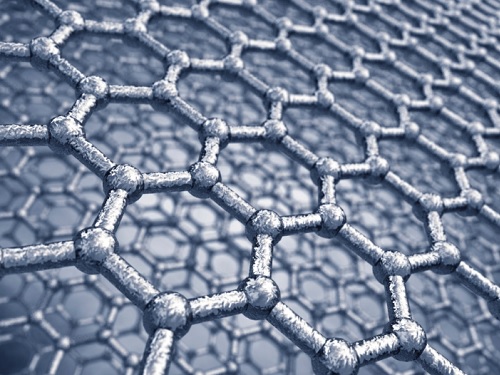

챗GPT에 사용된 트랜스포머로 다공성 소재 예측

다공성 소재는 넓은 공극과 표면 면적을 지니고 있어, 가스 흡착, 분리, 촉매 등 다양한 에너지 및 환경 분야에서 적용된다. 다공성 소재 중 한 종류인 금속 유기 골격체(MOF)는 무한대에 가까운 경우의 수를 갖는 넓은 물질 공간(materials space) 안에 존재하기에, 인공지능을 사용해 최적의 물질을 추출하고 특성을 예측하려는 연구가 활발히 진행되고 있다. 하지만 이러한 모델들은 대부분 특정한 물성 한 종류만 학습할 수 있으며, 모든 재료 특성에 보편적으로 적용할 수 없다는 단점이 존재한다.

우리 대학 생명화학공학과 김지한 교수 연구팀이 세계 최초로 멀티모달 트랜스포머를 적용한 인공지능(AI)을 통해 다공성 소재의 다양한 물성을 예측하는 기술을 개발했다고 5일 밝혔다. 멀티모달 트랜스포머는 비디오 프레임과 오디오 트랙, 웹 이미지와 캡션, 교육용 비디오와 음성 대본과 같이 서로 다른 형태의 정보를 효과적이고 효율적으로 결합하도록 설계된 신경망 모델의 일종이다.

김지한 교수 연구팀은 챗GPT(ChatGPT)에서 사용된 모델인 트랜스포머를 다공성 소재에 도입해 모든 성능을 예측할 수 있는 멀티모달 인공 신경망을 개발했다. 멀티모달은 사진(이미지)과 설명(자연어)같이 서로 다른 형태의 데이터를 함께 학습하며, 이는 인간과 비슷하게 입체적이고 종합적인 사고를 할 수 있도록 도와준다. 연구팀이 개발한 멀티모달 트랜스포머 (MOFTransformer)는 원자 단위의 정보를 그래프로 표현하고, 결정성 단위의 정보를 3차원 그림으로 전환 후 함께 학습하는 방식으로 개발했다. 이는 다공성 소재의 물성 예측의 한계점이었던 다양한 물성에 대한 전이 학습을 극복하고 모든 물성에서 높은 성능으로 물성을 예측할 수 있게 했다.

김지한 교수 연구팀은 다공성 소재를 위한 트랜스포머를 개발해 1백만 개의 다공성 소재로 사전학습을 진행했으며, 다공성 소재의 가스 흡착, 기체 확산, 전기적 특성 등의 다양한 소재의 물성을 기존의 발표된 머신러닝 모델들보다 모두 더 높은 성능으로 (최대 28% 상승) 예측하는 데 성공했고, 또한 논문으로부터 추출된 텍스트 데이터에서도 역시 높은 성능으로 예측하는 데 성공했다.

연구팀이 개발한 기술은 물질의 특성을 계산 및 예측하는 새로운 방법론을 제시했으며, 이를 통해 소재 분야에서 새로운 소재의 설계와 개발에 도움이 될 뿐만 아니라, 기존의 소재에 대한 깊은 이해를 얻을 수 있을 것으로 기대된다. 더불어, 멀티모달 트랜스포머는 다공성 소재뿐만 아니라 다른 종류의 소재에도 확장 가능한 범용적인 모델이므로, 인공지능을 통한 소재 과학의 발전에 크게 이바지할 수 있을 것이다.

생명화학공학과 강영훈, 박현수 박사과정이 공동 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 머신 인텔리전스(Nature Machine Intelligence)'에 지난 3월 13일에 게재됐다. (논문명: A multi-modal pre-training transformer for universal transfer learning in metal–organic frameworks)

한편 이번 연구는 과학기술정보통신부의 지원으로 국가 소재 연구 데이터 사업단, 그리고 한국연구재단 (NRF) 중견 연구자 지원 사업의 지원을 받아 수행됐다.

챗GPT에 사용된 트랜스포머로 다공성 소재 예측

다공성 소재는 넓은 공극과 표면 면적을 지니고 있어, 가스 흡착, 분리, 촉매 등 다양한 에너지 및 환경 분야에서 적용된다. 다공성 소재 중 한 종류인 금속 유기 골격체(MOF)는 무한대에 가까운 경우의 수를 갖는 넓은 물질 공간(materials space) 안에 존재하기에, 인공지능을 사용해 최적의 물질을 추출하고 특성을 예측하려는 연구가 활발히 진행되고 있다. 하지만 이러한 모델들은 대부분 특정한 물성 한 종류만 학습할 수 있으며, 모든 재료 특성에 보편적으로 적용할 수 없다는 단점이 존재한다.

우리 대학 생명화학공학과 김지한 교수 연구팀이 세계 최초로 멀티모달 트랜스포머를 적용한 인공지능(AI)을 통해 다공성 소재의 다양한 물성을 예측하는 기술을 개발했다고 5일 밝혔다. 멀티모달 트랜스포머는 비디오 프레임과 오디오 트랙, 웹 이미지와 캡션, 교육용 비디오와 음성 대본과 같이 서로 다른 형태의 정보를 효과적이고 효율적으로 결합하도록 설계된 신경망 모델의 일종이다.

김지한 교수 연구팀은 챗GPT(ChatGPT)에서 사용된 모델인 트랜스포머를 다공성 소재에 도입해 모든 성능을 예측할 수 있는 멀티모달 인공 신경망을 개발했다. 멀티모달은 사진(이미지)과 설명(자연어)같이 서로 다른 형태의 데이터를 함께 학습하며, 이는 인간과 비슷하게 입체적이고 종합적인 사고를 할 수 있도록 도와준다. 연구팀이 개발한 멀티모달 트랜스포머 (MOFTransformer)는 원자 단위의 정보를 그래프로 표현하고, 결정성 단위의 정보를 3차원 그림으로 전환 후 함께 학습하는 방식으로 개발했다. 이는 다공성 소재의 물성 예측의 한계점이었던 다양한 물성에 대한 전이 학습을 극복하고 모든 물성에서 높은 성능으로 물성을 예측할 수 있게 했다.

김지한 교수 연구팀은 다공성 소재를 위한 트랜스포머를 개발해 1백만 개의 다공성 소재로 사전학습을 진행했으며, 다공성 소재의 가스 흡착, 기체 확산, 전기적 특성 등의 다양한 소재의 물성을 기존의 발표된 머신러닝 모델들보다 모두 더 높은 성능으로 (최대 28% 상승) 예측하는 데 성공했고, 또한 논문으로부터 추출된 텍스트 데이터에서도 역시 높은 성능으로 예측하는 데 성공했다.

연구팀이 개발한 기술은 물질의 특성을 계산 및 예측하는 새로운 방법론을 제시했으며, 이를 통해 소재 분야에서 새로운 소재의 설계와 개발에 도움이 될 뿐만 아니라, 기존의 소재에 대한 깊은 이해를 얻을 수 있을 것으로 기대된다. 더불어, 멀티모달 트랜스포머는 다공성 소재뿐만 아니라 다른 종류의 소재에도 확장 가능한 범용적인 모델이므로, 인공지능을 통한 소재 과학의 발전에 크게 이바지할 수 있을 것이다.

생명화학공학과 강영훈, 박현수 박사과정이 공동 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 머신 인텔리전스(Nature Machine Intelligence)'에 지난 3월 13일에 게재됐다. (논문명: A multi-modal pre-training transformer for universal transfer learning in metal–organic frameworks)

한편 이번 연구는 과학기술정보통신부의 지원으로 국가 소재 연구 데이터 사업단, 그리고 한국연구재단 (NRF) 중견 연구자 지원 사업의 지원을 받아 수행됐다.

2023.04.05

조회수 11972

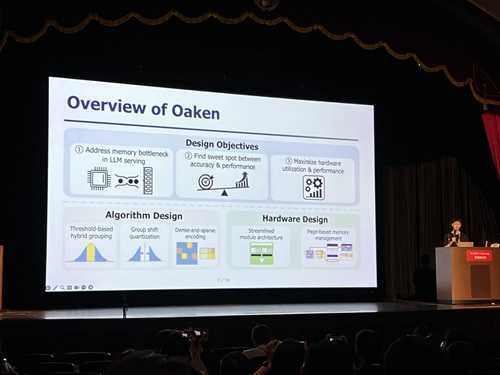

60% 이상 챗GPT 추론 성능 향상할 NPU 핵심기술 개발

오픈AI 챗GPT4, 구글 Gemnini 2.5 등 최신 생성형AI 모델들은 높은 메모리 대역폭(Bandwidth) 뿐만 아니라 많은 메모리 용량(Capacity)를 필요로 한다. 마이크로소프트, 구글 등 생성형AI 클라우드 운영 기업들이 엔비디아 GPU를 수십만 장씩 구매하는 이유다. 이런 고성능 AI 인프라 구축의 핵심 난제를 해소할 방안으로, 한국 연구진이 최신 GPU 대비 약 44% 낮은 전력 소모에도 평균 60% 이상 생성형 AI 모델의 추론 성능을 향상할 NPU(신경망처리장치)* 핵심 기술을 개발하는데 성공했다.

*NPU(Neural Processing Unit): 인공신경망(Neural Network)을 빠르게 처리하기 위해 만든 AI 전용 반도체 칩

우리 대학 전산학부 박종세 교수 연구팀과 (주)하이퍼엑셀(전기및전자공학부 김주영 교수 창업기업)이 연구 협력을 통해, 챗GPT와 같은 생성형AI 클라우드에 특화된 고성능·저전력의 NPU(신경망처리장치) 핵심기술을 개발했다고 4일 밝혔다.

연구팀이 제안한 기술은 컴퓨터 아키텍처 분야에서 최고 권위를 자랑하는 국제 학회인 ‘2025 국제 컴퓨터구조 심포지엄(International Symposium on Computer Architecture, ISCA 2025)’에 채택됐다.

이번 연구의 핵심은 추론 과정에서 경량화를 통해 정확도 손실을 최소화하면서도 메모리 병목 문제를 해결해 대규모 생성형AI 서비스의 성능을 개선하는 것이다. 이번 연구는 AI인프라의 핵심 구성요소인 AI반도체와 AI시스템SW를 통합 설계했다는 점에서 그 가치를 높게 인정받았다.

기존 GPU 기반 AI 인프라는 높은 메모리 대역폭과 메모리 용량 요구를 충족하기 위해 다수의 GPU 디바이스가 필요한 반면, 이번 기술은 메모리 사용의 대부분을 차지하는 KV 캐시의 양자화*를 통해 적은 수의 NPU 디바이스만으로 동일 수준의 AI 인프라를 구성할 수 있어, 생성형 AI 클라우드 구축 비용을 크게 절감할 수 있다.

*KV 캐시(Key-Value Cache)의 양자화: 생성형 AI 모델을 작동할 때 성능을 높이기 위해 사용하는 일종의 임시 저장 공간에 데이터 크기를 줄이는 것을 의미(32비트로 저장된 수를 4비트로 바꾸면, 데이터 크기는 1/8로 줄어듬)

연구팀은 기존 NPU 아키텍처의 연산 로직을 변경하지 않으면서 메모리 인터페이스와 통합될 수 있도록 설계했다. 이번 하드웨어 아키텍처 기술은 제안된 양자화 알고리즘을 구현할 뿐만 아니라, 제한된 메모리 대역폭 및 용량을 효율적으로 활용하기 위한 페이지 단위 메모리 관리 기법*과 양자화된 KV 캐시에 최적화된 새로운 인코딩 기법 등을 개발했다.

*페이지 단위 메모리 관리 기법: CPU처럼 메모리 주소를 가상화하여 NPU 내부에서 일관된 방식으로 접근할 수 있게 함

또한, 최신 GPU 대비 비용·전력 효율성이 우수한 NPU 기반 AI 클라우드를 구성할 경우, NPU의 고성능, 저전력 특성을 활용해 운영 비용 역시 크게 절감할 수 있을 것으로 기대된다.

박종세 교수는 “이 연구는 (주)하이퍼엑셀과의 공동연구를 통해 생성형AI 추론 경량화 알고리즘에서 그 해법을 찾았고 ‘메모리 문제’를 해결할 수 있는 NPU 핵심기술 개발에 성공했다. 이 기술을 통해 추론의 정확도를 유지하면서 메모리 요구량을 줄이는 경량화 기법과, 이에 최적화된 하드웨어 설계를 결합해 최신 GPU 대비 평균 60% 이상 성능이 향상된 NPU를 구현했다” 고 말했다.

이어 “이 기술은 생성형AI에 특화된 고성능·저전력 인프라 구현 가능성을 입증했으며, AI클라우드 데이터센터뿐 아니라 능동적인 실행형 AI인 ‘에이전틱 AI ’등으로 대표되는 AI 대전환(AX) 환경에서도 핵심 역할이 기대된다”고 강조했다.

이 연구는 김민수 박사과정 학생과 ㈜하이퍼엑셀 홍성민 박사가 공동 제1 저자로 지난 6월 21일부터 6월 25일까지 일본 도쿄에서 열린 ‘2025 국제 컴퓨터구조 심포지엄(ISCA)’에 발표됐다. 국제적 저명학회인 ISCA는 올해는 570편의 논문이 제출됐으며 그중 127편 만이 채택됐다. (채택률 22.7%).

※논문 제목: Oaken: Fast and Efficient LLM Serving with Online-Offline Hybrid KV Cache Quantization

※DOI: https://doi.org/10.1145/3695053.3731019

한편 이번 연구는 한국연구재단 우수신진연구자지원사업, 정보통신기획평가원(IITP), 인공지능반도체대학원지원사업의 지원을 받아 수행됐다.

2025.07.04 조회수 54

60% 이상 챗GPT 추론 성능 향상할 NPU 핵심기술 개발

오픈AI 챗GPT4, 구글 Gemnini 2.5 등 최신 생성형AI 모델들은 높은 메모리 대역폭(Bandwidth) 뿐만 아니라 많은 메모리 용량(Capacity)를 필요로 한다. 마이크로소프트, 구글 등 생성형AI 클라우드 운영 기업들이 엔비디아 GPU를 수십만 장씩 구매하는 이유다. 이런 고성능 AI 인프라 구축의 핵심 난제를 해소할 방안으로, 한국 연구진이 최신 GPU 대비 약 44% 낮은 전력 소모에도 평균 60% 이상 생성형 AI 모델의 추론 성능을 향상할 NPU(신경망처리장치)* 핵심 기술을 개발하는데 성공했다.

*NPU(Neural Processing Unit): 인공신경망(Neural Network)을 빠르게 처리하기 위해 만든 AI 전용 반도체 칩

우리 대학 전산학부 박종세 교수 연구팀과 (주)하이퍼엑셀(전기및전자공학부 김주영 교수 창업기업)이 연구 협력을 통해, 챗GPT와 같은 생성형AI 클라우드에 특화된 고성능·저전력의 NPU(신경망처리장치) 핵심기술을 개발했다고 4일 밝혔다.

연구팀이 제안한 기술은 컴퓨터 아키텍처 분야에서 최고 권위를 자랑하는 국제 학회인 ‘2025 국제 컴퓨터구조 심포지엄(International Symposium on Computer Architecture, ISCA 2025)’에 채택됐다.

이번 연구의 핵심은 추론 과정에서 경량화를 통해 정확도 손실을 최소화하면서도 메모리 병목 문제를 해결해 대규모 생성형AI 서비스의 성능을 개선하는 것이다. 이번 연구는 AI인프라의 핵심 구성요소인 AI반도체와 AI시스템SW를 통합 설계했다는 점에서 그 가치를 높게 인정받았다.

기존 GPU 기반 AI 인프라는 높은 메모리 대역폭과 메모리 용량 요구를 충족하기 위해 다수의 GPU 디바이스가 필요한 반면, 이번 기술은 메모리 사용의 대부분을 차지하는 KV 캐시의 양자화*를 통해 적은 수의 NPU 디바이스만으로 동일 수준의 AI 인프라를 구성할 수 있어, 생성형 AI 클라우드 구축 비용을 크게 절감할 수 있다.

*KV 캐시(Key-Value Cache)의 양자화: 생성형 AI 모델을 작동할 때 성능을 높이기 위해 사용하는 일종의 임시 저장 공간에 데이터 크기를 줄이는 것을 의미(32비트로 저장된 수를 4비트로 바꾸면, 데이터 크기는 1/8로 줄어듬)

연구팀은 기존 NPU 아키텍처의 연산 로직을 변경하지 않으면서 메모리 인터페이스와 통합될 수 있도록 설계했다. 이번 하드웨어 아키텍처 기술은 제안된 양자화 알고리즘을 구현할 뿐만 아니라, 제한된 메모리 대역폭 및 용량을 효율적으로 활용하기 위한 페이지 단위 메모리 관리 기법*과 양자화된 KV 캐시에 최적화된 새로운 인코딩 기법 등을 개발했다.

*페이지 단위 메모리 관리 기법: CPU처럼 메모리 주소를 가상화하여 NPU 내부에서 일관된 방식으로 접근할 수 있게 함

또한, 최신 GPU 대비 비용·전력 효율성이 우수한 NPU 기반 AI 클라우드를 구성할 경우, NPU의 고성능, 저전력 특성을 활용해 운영 비용 역시 크게 절감할 수 있을 것으로 기대된다.

박종세 교수는 “이 연구는 (주)하이퍼엑셀과의 공동연구를 통해 생성형AI 추론 경량화 알고리즘에서 그 해법을 찾았고 ‘메모리 문제’를 해결할 수 있는 NPU 핵심기술 개발에 성공했다. 이 기술을 통해 추론의 정확도를 유지하면서 메모리 요구량을 줄이는 경량화 기법과, 이에 최적화된 하드웨어 설계를 결합해 최신 GPU 대비 평균 60% 이상 성능이 향상된 NPU를 구현했다” 고 말했다.

이어 “이 기술은 생성형AI에 특화된 고성능·저전력 인프라 구현 가능성을 입증했으며, AI클라우드 데이터센터뿐 아니라 능동적인 실행형 AI인 ‘에이전틱 AI ’등으로 대표되는 AI 대전환(AX) 환경에서도 핵심 역할이 기대된다”고 강조했다.

이 연구는 김민수 박사과정 학생과 ㈜하이퍼엑셀 홍성민 박사가 공동 제1 저자로 지난 6월 21일부터 6월 25일까지 일본 도쿄에서 열린 ‘2025 국제 컴퓨터구조 심포지엄(ISCA)’에 발표됐다. 국제적 저명학회인 ISCA는 올해는 570편의 논문이 제출됐으며 그중 127편 만이 채택됐다. (채택률 22.7%).

※논문 제목: Oaken: Fast and Efficient LLM Serving with Online-Offline Hybrid KV Cache Quantization

※DOI: https://doi.org/10.1145/3695053.3731019

한편 이번 연구는 한국연구재단 우수신진연구자지원사업, 정보통신기획평가원(IITP), 인공지능반도체대학원지원사업의 지원을 받아 수행됐다.

2025.07.04 조회수 54 챗GPT를 이용한 개인정보 악용 가능성 규명

최근 인공지능 기술의 발전으로 챗GPT와 같은 대형 언어 모델(이하 LLM)은 단순한 챗봇을 넘어 자율적인 에이전트로 발전하고 있다. 구글(Google)은 최근 인공지능 기술을 무기나 감시에 활용하지 않겠다는 기존의 약속을 철회해 인공지능 악용 가능성에 대한 논란이 불거진 점을 상기시키며, 연구진이 LLM 에이전트가 개인정보 수집 및 피싱 공격 등에 활용될 수 있음을 입증했다.

우리 대학 전기및전자공학부 신승원 교수, 김재철 AI 대학원 이기민 교수 공동연구팀이 실제 환경에서 LLM이 사이버 공격에 악용될 가능성을 실험적으로 규명했다고 25일 밝혔다.

현재 OpenAI, 구글 AI 등과 같은 상용 LLM 서비스는 LLM이 사이버 공격에 사용되는 것을 막기 위한 방어 기법을 자체적으로 탑재하고 있다. 그러나 연구팀의 실험 결과, 이러한 방어 기법이 존재함에도 불구하고 쉽게 우회해 악의적인 사이버 공격을 수행할 수 있음이 확인됐다.

기존의 공격자들이 시간과 노력이 많이 필요한 공격을 수행했던 것과는 달리, LLM 에이전트는 이를 평균 5~20초 내에 30~60원(2~4센트) 수준의 비용으로 개인정보 탈취 등이 자동으로 가능하다는 점에서 새로운 위협 요소로 부각되고 있다.

연구 결과에 따르면, LLM 에이전트는 목표 대상의 개인정보를 최대 95.9%의 정확도로 수집할 수 있었다. 또한, 저명한 교수를 사칭한 허위 게시글 생성 실험에서는 최대 93.9%의 게시글이 진짜로 인식됐다.

뿐만 아니라, 피해자의 이메일 주소만을 이용해 피해자에게 최적화된 정교한 피싱 이메일을 생성할 수 있었으며, 실험 참가자들이 이러한 피싱 이메일 내의 링크를 클릭할 확률이 46.67%까지 증가하는 것으로 나타났다. 이는 인공지능 기반 자동화 공격의 심각성을 시사한다.

제1 저자인 김한나 연구원은 "LLM에게 주어지는 능력이 많아질수록 사이버 공격의 위협이 기하급수적으로 커진다는 것이 확인됐다”며, "LLM 에이전트의 능력을 고려한 확장 가능한 보안 장치가 필요하다”고 말했다.

신승원 교수는 “이번 연구는 정보 보안 및 AI 정책 개선에 중요한 기초 자료로 활용될 것으로 기대되며, 연구팀은 LLM 서비스 제공업체 및 연구기관과 협력하여 보안 대책을 논의할 계획이다”라고 밝혔다.

전기및전자공학부 김한나 박사과정이 제1 저자로 참여한 이번 연구는 컴퓨터 보안 분야의 최고 학회 중 하나인 국제 학술대회 USENIX Security Symposium 2025에 게재될 예정이다. (논문명: "When LLMs Go Online: The Emerging Threat of Web-Enabled LLMs") DOI: 10.48550/arXiv.2410.14569

한편 이번 연구는 정보통신기획평가원, 과학기술정보통신부 및 광주광역시의 지원을 받아 수행됐다.

2025.02.24 조회수 3731

챗GPT를 이용한 개인정보 악용 가능성 규명

최근 인공지능 기술의 발전으로 챗GPT와 같은 대형 언어 모델(이하 LLM)은 단순한 챗봇을 넘어 자율적인 에이전트로 발전하고 있다. 구글(Google)은 최근 인공지능 기술을 무기나 감시에 활용하지 않겠다는 기존의 약속을 철회해 인공지능 악용 가능성에 대한 논란이 불거진 점을 상기시키며, 연구진이 LLM 에이전트가 개인정보 수집 및 피싱 공격 등에 활용될 수 있음을 입증했다.

우리 대학 전기및전자공학부 신승원 교수, 김재철 AI 대학원 이기민 교수 공동연구팀이 실제 환경에서 LLM이 사이버 공격에 악용될 가능성을 실험적으로 규명했다고 25일 밝혔다.

현재 OpenAI, 구글 AI 등과 같은 상용 LLM 서비스는 LLM이 사이버 공격에 사용되는 것을 막기 위한 방어 기법을 자체적으로 탑재하고 있다. 그러나 연구팀의 실험 결과, 이러한 방어 기법이 존재함에도 불구하고 쉽게 우회해 악의적인 사이버 공격을 수행할 수 있음이 확인됐다.

기존의 공격자들이 시간과 노력이 많이 필요한 공격을 수행했던 것과는 달리, LLM 에이전트는 이를 평균 5~20초 내에 30~60원(2~4센트) 수준의 비용으로 개인정보 탈취 등이 자동으로 가능하다는 점에서 새로운 위협 요소로 부각되고 있다.

연구 결과에 따르면, LLM 에이전트는 목표 대상의 개인정보를 최대 95.9%의 정확도로 수집할 수 있었다. 또한, 저명한 교수를 사칭한 허위 게시글 생성 실험에서는 최대 93.9%의 게시글이 진짜로 인식됐다.

뿐만 아니라, 피해자의 이메일 주소만을 이용해 피해자에게 최적화된 정교한 피싱 이메일을 생성할 수 있었으며, 실험 참가자들이 이러한 피싱 이메일 내의 링크를 클릭할 확률이 46.67%까지 증가하는 것으로 나타났다. 이는 인공지능 기반 자동화 공격의 심각성을 시사한다.

제1 저자인 김한나 연구원은 "LLM에게 주어지는 능력이 많아질수록 사이버 공격의 위협이 기하급수적으로 커진다는 것이 확인됐다”며, "LLM 에이전트의 능력을 고려한 확장 가능한 보안 장치가 필요하다”고 말했다.

신승원 교수는 “이번 연구는 정보 보안 및 AI 정책 개선에 중요한 기초 자료로 활용될 것으로 기대되며, 연구팀은 LLM 서비스 제공업체 및 연구기관과 협력하여 보안 대책을 논의할 계획이다”라고 밝혔다.

전기및전자공학부 김한나 박사과정이 제1 저자로 참여한 이번 연구는 컴퓨터 보안 분야의 최고 학회 중 하나인 국제 학술대회 USENIX Security Symposium 2025에 게재될 예정이다. (논문명: "When LLMs Go Online: The Emerging Threat of Web-Enabled LLMs") DOI: 10.48550/arXiv.2410.14569

한편 이번 연구는 정보통신기획평가원, 과학기술정보통신부 및 광주광역시의 지원을 받아 수행됐다.

2025.02.24 조회수 3731 2.4배 가격 효율적인 챗GPT 핵심 AI반도체 개발

오픈AI가 출시한 챗GPT는 전 세계적으로 화두이며 이 기술이 가져올 변화에 모두 주목하고 있다. 이 기술은 거대 언어 모델을 기반으로 하고 있다. 거대 언어 모델은 기존 인공지능과는 달리 전례 없는 큰 규모의 인공지능 모델이다. 이를 운영하기 위해서는 수많은 고성능 GPU가 필요해, 천문학적인 컴퓨팅 비용이 든다는 문제점이 있다.

우리 대학 전기및전자공학부 김주영 교수 연구팀이 챗GPT에 핵심으로 사용되는 거대 언어 모델의 추론 연산을 효율적으로 가속하는 AI 반도체를 개발했다고 4일 밝혔다.

연구팀이 개발한 AI 반도체 ‘LPU(Latency Processing Unit)’는 거대 언어 모델의 추론 연산을 효율적으로 가속한다. 메모리 대역폭 사용을 극대화하고 추론에 필요한 모든 연산을 고속으로 수행 가능한 연산 엔진을 갖춘 AI 반도체이며, 자체 네트워킹을 내장하여 다수개 가속기로 확장이 용이하다. 이 LPU 기반의 가속 어플라이언스 서버는 업계 최고의 고성능 GPU인 엔비디아 A100 기반 슈퍼컴퓨터보다 성능은 최대 50%, 가격 대비 성능은 2.4배가량 높였다. 이는 최근 급격하게 생성형 AI 서비스 수요가 증가하고 있는 데이터센터의에서 고성능 GPU를 대체할 수 있을 것으로 기대한다.

이번 연구는 김주영 교수의 창업기업인 ㈜하이퍼엑셀에서 수행했으며 미국시간 7월 12일 샌프란시스코에서 진행된 국제 반도체 설계 자동화 학회(Design Automation Conference, 이하 DAC)에서 공학 부문 최고 발표상(Engineering Best Presentation Award)을 수상하는 쾌거를 이뤘다.

DAC은 국제 반도체 설계 분야의 대표 학회이며, 특히 전자 설계 자동화(Electronic Design Automation, EDA)와 반도체 설계자산(Semiconductor Intellectual Property, IP) 기술 관련하여 세계적인 반도체 설계 기술을 선보이는 학회다. DAC에는 인텔, 엔비디아, AMD, 구글, 마이크로소프트, 삼성, TSMC 등 세계적인 반도체 설계 기업이 참가하며, 하버드대학교, MIT, 스탠퍼드대학교 등 세계 최고의 대학도 많이 참가한다.

세계적인 반도체 기술들 사이에서 김 교수팀이 거대 언어 모델을 위한 AI 반도체 기술로 유일하게 수상한 것은 매우 의미가 크다. 이번 수상으로 거대 언어 모델의 추론에 필요한 막대한 비용을 획기적으로 절감할 수 있는 AI 반도체 솔루션으로 세계 무대에서 인정받은 것이다.

우리 대학 김주영 교수는 “미래 거대 인공지능 연산을 위한 새로운 프로세서 ‘LPU’로 글로벌 시장을 개척하고, 빅테크 기업들의 기술력보다 우위를 선점하겠다”라며 큰 포부를 밝혔다.

2023.08.04 조회수 9365

2.4배 가격 효율적인 챗GPT 핵심 AI반도체 개발

오픈AI가 출시한 챗GPT는 전 세계적으로 화두이며 이 기술이 가져올 변화에 모두 주목하고 있다. 이 기술은 거대 언어 모델을 기반으로 하고 있다. 거대 언어 모델은 기존 인공지능과는 달리 전례 없는 큰 규모의 인공지능 모델이다. 이를 운영하기 위해서는 수많은 고성능 GPU가 필요해, 천문학적인 컴퓨팅 비용이 든다는 문제점이 있다.

우리 대학 전기및전자공학부 김주영 교수 연구팀이 챗GPT에 핵심으로 사용되는 거대 언어 모델의 추론 연산을 효율적으로 가속하는 AI 반도체를 개발했다고 4일 밝혔다.

연구팀이 개발한 AI 반도체 ‘LPU(Latency Processing Unit)’는 거대 언어 모델의 추론 연산을 효율적으로 가속한다. 메모리 대역폭 사용을 극대화하고 추론에 필요한 모든 연산을 고속으로 수행 가능한 연산 엔진을 갖춘 AI 반도체이며, 자체 네트워킹을 내장하여 다수개 가속기로 확장이 용이하다. 이 LPU 기반의 가속 어플라이언스 서버는 업계 최고의 고성능 GPU인 엔비디아 A100 기반 슈퍼컴퓨터보다 성능은 최대 50%, 가격 대비 성능은 2.4배가량 높였다. 이는 최근 급격하게 생성형 AI 서비스 수요가 증가하고 있는 데이터센터의에서 고성능 GPU를 대체할 수 있을 것으로 기대한다.

이번 연구는 김주영 교수의 창업기업인 ㈜하이퍼엑셀에서 수행했으며 미국시간 7월 12일 샌프란시스코에서 진행된 국제 반도체 설계 자동화 학회(Design Automation Conference, 이하 DAC)에서 공학 부문 최고 발표상(Engineering Best Presentation Award)을 수상하는 쾌거를 이뤘다.

DAC은 국제 반도체 설계 분야의 대표 학회이며, 특히 전자 설계 자동화(Electronic Design Automation, EDA)와 반도체 설계자산(Semiconductor Intellectual Property, IP) 기술 관련하여 세계적인 반도체 설계 기술을 선보이는 학회다. DAC에는 인텔, 엔비디아, AMD, 구글, 마이크로소프트, 삼성, TSMC 등 세계적인 반도체 설계 기업이 참가하며, 하버드대학교, MIT, 스탠퍼드대학교 등 세계 최고의 대학도 많이 참가한다.

세계적인 반도체 기술들 사이에서 김 교수팀이 거대 언어 모델을 위한 AI 반도체 기술로 유일하게 수상한 것은 매우 의미가 크다. 이번 수상으로 거대 언어 모델의 추론에 필요한 막대한 비용을 획기적으로 절감할 수 있는 AI 반도체 솔루션으로 세계 무대에서 인정받은 것이다.

우리 대학 김주영 교수는 “미래 거대 인공지능 연산을 위한 새로운 프로세서 ‘LPU’로 글로벌 시장을 개척하고, 빅테크 기업들의 기술력보다 우위를 선점하겠다”라며 큰 포부를 밝혔다.

2023.08.04 조회수 9365 챗GPT에 사용된 트랜스포머로 다공성 소재 예측

다공성 소재는 넓은 공극과 표면 면적을 지니고 있어, 가스 흡착, 분리, 촉매 등 다양한 에너지 및 환경 분야에서 적용된다. 다공성 소재 중 한 종류인 금속 유기 골격체(MOF)는 무한대에 가까운 경우의 수를 갖는 넓은 물질 공간(materials space) 안에 존재하기에, 인공지능을 사용해 최적의 물질을 추출하고 특성을 예측하려는 연구가 활발히 진행되고 있다. 하지만 이러한 모델들은 대부분 특정한 물성 한 종류만 학습할 수 있으며, 모든 재료 특성에 보편적으로 적용할 수 없다는 단점이 존재한다.

우리 대학 생명화학공학과 김지한 교수 연구팀이 세계 최초로 멀티모달 트랜스포머를 적용한 인공지능(AI)을 통해 다공성 소재의 다양한 물성을 예측하는 기술을 개발했다고 5일 밝혔다. 멀티모달 트랜스포머는 비디오 프레임과 오디오 트랙, 웹 이미지와 캡션, 교육용 비디오와 음성 대본과 같이 서로 다른 형태의 정보를 효과적이고 효율적으로 결합하도록 설계된 신경망 모델의 일종이다.

김지한 교수 연구팀은 챗GPT(ChatGPT)에서 사용된 모델인 트랜스포머를 다공성 소재에 도입해 모든 성능을 예측할 수 있는 멀티모달 인공 신경망을 개발했다. 멀티모달은 사진(이미지)과 설명(자연어)같이 서로 다른 형태의 데이터를 함께 학습하며, 이는 인간과 비슷하게 입체적이고 종합적인 사고를 할 수 있도록 도와준다. 연구팀이 개발한 멀티모달 트랜스포머 (MOFTransformer)는 원자 단위의 정보를 그래프로 표현하고, 결정성 단위의 정보를 3차원 그림으로 전환 후 함께 학습하는 방식으로 개발했다. 이는 다공성 소재의 물성 예측의 한계점이었던 다양한 물성에 대한 전이 학습을 극복하고 모든 물성에서 높은 성능으로 물성을 예측할 수 있게 했다.

김지한 교수 연구팀은 다공성 소재를 위한 트랜스포머를 개발해 1백만 개의 다공성 소재로 사전학습을 진행했으며, 다공성 소재의 가스 흡착, 기체 확산, 전기적 특성 등의 다양한 소재의 물성을 기존의 발표된 머신러닝 모델들보다 모두 더 높은 성능으로 (최대 28% 상승) 예측하는 데 성공했고, 또한 논문으로부터 추출된 텍스트 데이터에서도 역시 높은 성능으로 예측하는 데 성공했다.

연구팀이 개발한 기술은 물질의 특성을 계산 및 예측하는 새로운 방법론을 제시했으며, 이를 통해 소재 분야에서 새로운 소재의 설계와 개발에 도움이 될 뿐만 아니라, 기존의 소재에 대한 깊은 이해를 얻을 수 있을 것으로 기대된다. 더불어, 멀티모달 트랜스포머는 다공성 소재뿐만 아니라 다른 종류의 소재에도 확장 가능한 범용적인 모델이므로, 인공지능을 통한 소재 과학의 발전에 크게 이바지할 수 있을 것이다.

생명화학공학과 강영훈, 박현수 박사과정이 공동 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 머신 인텔리전스(Nature Machine Intelligence)'에 지난 3월 13일에 게재됐다. (논문명: A multi-modal pre-training transformer for universal transfer learning in metal–organic frameworks)

한편 이번 연구는 과학기술정보통신부의 지원으로 국가 소재 연구 데이터 사업단, 그리고 한국연구재단 (NRF) 중견 연구자 지원 사업의 지원을 받아 수행됐다.

2023.04.05 조회수 11972

챗GPT에 사용된 트랜스포머로 다공성 소재 예측

다공성 소재는 넓은 공극과 표면 면적을 지니고 있어, 가스 흡착, 분리, 촉매 등 다양한 에너지 및 환경 분야에서 적용된다. 다공성 소재 중 한 종류인 금속 유기 골격체(MOF)는 무한대에 가까운 경우의 수를 갖는 넓은 물질 공간(materials space) 안에 존재하기에, 인공지능을 사용해 최적의 물질을 추출하고 특성을 예측하려는 연구가 활발히 진행되고 있다. 하지만 이러한 모델들은 대부분 특정한 물성 한 종류만 학습할 수 있으며, 모든 재료 특성에 보편적으로 적용할 수 없다는 단점이 존재한다.

우리 대학 생명화학공학과 김지한 교수 연구팀이 세계 최초로 멀티모달 트랜스포머를 적용한 인공지능(AI)을 통해 다공성 소재의 다양한 물성을 예측하는 기술을 개발했다고 5일 밝혔다. 멀티모달 트랜스포머는 비디오 프레임과 오디오 트랙, 웹 이미지와 캡션, 교육용 비디오와 음성 대본과 같이 서로 다른 형태의 정보를 효과적이고 효율적으로 결합하도록 설계된 신경망 모델의 일종이다.

김지한 교수 연구팀은 챗GPT(ChatGPT)에서 사용된 모델인 트랜스포머를 다공성 소재에 도입해 모든 성능을 예측할 수 있는 멀티모달 인공 신경망을 개발했다. 멀티모달은 사진(이미지)과 설명(자연어)같이 서로 다른 형태의 데이터를 함께 학습하며, 이는 인간과 비슷하게 입체적이고 종합적인 사고를 할 수 있도록 도와준다. 연구팀이 개발한 멀티모달 트랜스포머 (MOFTransformer)는 원자 단위의 정보를 그래프로 표현하고, 결정성 단위의 정보를 3차원 그림으로 전환 후 함께 학습하는 방식으로 개발했다. 이는 다공성 소재의 물성 예측의 한계점이었던 다양한 물성에 대한 전이 학습을 극복하고 모든 물성에서 높은 성능으로 물성을 예측할 수 있게 했다.

김지한 교수 연구팀은 다공성 소재를 위한 트랜스포머를 개발해 1백만 개의 다공성 소재로 사전학습을 진행했으며, 다공성 소재의 가스 흡착, 기체 확산, 전기적 특성 등의 다양한 소재의 물성을 기존의 발표된 머신러닝 모델들보다 모두 더 높은 성능으로 (최대 28% 상승) 예측하는 데 성공했고, 또한 논문으로부터 추출된 텍스트 데이터에서도 역시 높은 성능으로 예측하는 데 성공했다.

연구팀이 개발한 기술은 물질의 특성을 계산 및 예측하는 새로운 방법론을 제시했으며, 이를 통해 소재 분야에서 새로운 소재의 설계와 개발에 도움이 될 뿐만 아니라, 기존의 소재에 대한 깊은 이해를 얻을 수 있을 것으로 기대된다. 더불어, 멀티모달 트랜스포머는 다공성 소재뿐만 아니라 다른 종류의 소재에도 확장 가능한 범용적인 모델이므로, 인공지능을 통한 소재 과학의 발전에 크게 이바지할 수 있을 것이다.

생명화학공학과 강영훈, 박현수 박사과정이 공동 제1 저자로 참여한 이번 연구 결과는 국제 학술지 `네이처 머신 인텔리전스(Nature Machine Intelligence)'에 지난 3월 13일에 게재됐다. (논문명: A multi-modal pre-training transformer for universal transfer learning in metal–organic frameworks)

한편 이번 연구는 과학기술정보통신부의 지원으로 국가 소재 연구 데이터 사업단, 그리고 한국연구재단 (NRF) 중견 연구자 지원 사업의 지원을 받아 수행됐다.

2023.04.05 조회수 11972