%EC%8B%A0%EA%B2%BD%EC%A0%95%EB%B3%B4%EC%B2%98%EB%A6%AC%ED%95%99%ED%9A%8C

-

구글딥마인드와 공동연구를 통해 인공지능으로 시각을 상상하다

‘노란 포도'나 `보라색 바나나'와 같이 본 적 없는 시각 개념을 이해하고 상상하는 인공지능 능력 구현이 가능해졌다.

우리 대학 전산학부 안성진 교수 연구팀이 구글 딥마인드 및 미국 럿거스 대학교와의 국제 공동 연구를 통해 시각적 지식을 체계적으로 조합해 새로운 개념을 이해하는 인공지능 새로운 모델과 프로그램을 수행하는 벤치마크를 개발했다고 30일 밝혔다.

인간은 `보라색 포도'와 `노란 바나나' 같은 개념을 학습하고, 이를 분리한 뒤 재조합해 `노란 포도'나 `보라색 바나나'와 같이 본 적 없는 개념을 상상하는 능력이 있다. 이런 능력은 체계적 일반화 혹은 조합적 일반화라고 불리며, 범용 인공지능을 구현하는 데 있어 핵심적인 요소로 여겨진다.

체계적 일반화 문제는 1988년 미국의 저명한 인지과학자 제리 포더(Jerry Fodor)와 제논 필리쉰(Zenon Pylyshyn)이 인공신경망이 이 문제를 해결할 수 없다고 주장한 이후, 35년 동안 인공지능 딥러닝 분야에서 큰 도전 과제로 남아 있다. 이 문제는 언어뿐만 아니라 시각 정보에서도 발생하지만, 지금까지는 주로 언어의 체계적 일반화에만 초점이 맞춰져 있었고, 시각 정보에 관한 연구는 상대적으로 부족했다.

안성진 교수가 이끄는 국제 공동 연구팀은 이러한 공백을 메우고자 시각 정보에 대한 체계적 일반화를 연구할 수 있는 벤치마크를 개발했다. 시각 정보는 언어와는 달리 명확한 `단어'나 `토큰'의 구조가 없어, 이 구조를 학습하고 체계적 일반화를 달성하는 것이 큰 도전이다.

연구를 주도한 안성진 교수는 “시각 정보의 체계적 일반화가 범용 인공지능을 달성하기 위해 필수적인 능력이며 이 연구를 통해 인공지능의 추론능력과 상상능력 관련 분야의 발전을 가속할 것으로 기대한다”고 말했다.

또한, 딥마인드의 책임 연구원으로 연구에 참여한 연구원이자 현재 스위스 로잔연방공과대학교(EPFL)의 찰라 걸셔(Caglar Gulcehre) 교수는 “체계적 일반화가 가능해지면 현재보다 훨씬 적은 데이터로 더 높은 성능을 낼 수 있게 될 것이다”라고 전했다.

이번 연구는 12월 10일부터 16일까지 미국 뉴올리언스에서 열리는 제37회 신경정보처리학회(NeurIPS)에서 발표될 예정이다.

관련논문: “Imagine the Unseen World: A Benchmark for Systematic Generalization in Visual World Models”, Yeongbin Kim, Gautam Singh, Junyeong Park, Caglar Gulcehre, Sungjin Ahn, NeurIPS 23

2023.11.30 조회수 7911

구글딥마인드와 공동연구를 통해 인공지능으로 시각을 상상하다

‘노란 포도'나 `보라색 바나나'와 같이 본 적 없는 시각 개념을 이해하고 상상하는 인공지능 능력 구현이 가능해졌다.

우리 대학 전산학부 안성진 교수 연구팀이 구글 딥마인드 및 미국 럿거스 대학교와의 국제 공동 연구를 통해 시각적 지식을 체계적으로 조합해 새로운 개념을 이해하는 인공지능 새로운 모델과 프로그램을 수행하는 벤치마크를 개발했다고 30일 밝혔다.

인간은 `보라색 포도'와 `노란 바나나' 같은 개념을 학습하고, 이를 분리한 뒤 재조합해 `노란 포도'나 `보라색 바나나'와 같이 본 적 없는 개념을 상상하는 능력이 있다. 이런 능력은 체계적 일반화 혹은 조합적 일반화라고 불리며, 범용 인공지능을 구현하는 데 있어 핵심적인 요소로 여겨진다.

체계적 일반화 문제는 1988년 미국의 저명한 인지과학자 제리 포더(Jerry Fodor)와 제논 필리쉰(Zenon Pylyshyn)이 인공신경망이 이 문제를 해결할 수 없다고 주장한 이후, 35년 동안 인공지능 딥러닝 분야에서 큰 도전 과제로 남아 있다. 이 문제는 언어뿐만 아니라 시각 정보에서도 발생하지만, 지금까지는 주로 언어의 체계적 일반화에만 초점이 맞춰져 있었고, 시각 정보에 관한 연구는 상대적으로 부족했다.

안성진 교수가 이끄는 국제 공동 연구팀은 이러한 공백을 메우고자 시각 정보에 대한 체계적 일반화를 연구할 수 있는 벤치마크를 개발했다. 시각 정보는 언어와는 달리 명확한 `단어'나 `토큰'의 구조가 없어, 이 구조를 학습하고 체계적 일반화를 달성하는 것이 큰 도전이다.

연구를 주도한 안성진 교수는 “시각 정보의 체계적 일반화가 범용 인공지능을 달성하기 위해 필수적인 능력이며 이 연구를 통해 인공지능의 추론능력과 상상능력 관련 분야의 발전을 가속할 것으로 기대한다”고 말했다.

또한, 딥마인드의 책임 연구원으로 연구에 참여한 연구원이자 현재 스위스 로잔연방공과대학교(EPFL)의 찰라 걸셔(Caglar Gulcehre) 교수는 “체계적 일반화가 가능해지면 현재보다 훨씬 적은 데이터로 더 높은 성능을 낼 수 있게 될 것이다”라고 전했다.

이번 연구는 12월 10일부터 16일까지 미국 뉴올리언스에서 열리는 제37회 신경정보처리학회(NeurIPS)에서 발표될 예정이다.

관련논문: “Imagine the Unseen World: A Benchmark for Systematic Generalization in Visual World Models”, Yeongbin Kim, Gautam Singh, Junyeong Park, Caglar Gulcehre, Sungjin Ahn, NeurIPS 23

2023.11.30 조회수 7911 -

세계 최초로 사람처럼 사물의 개념을 스스로 학습하는 장면 인식 기술 개발

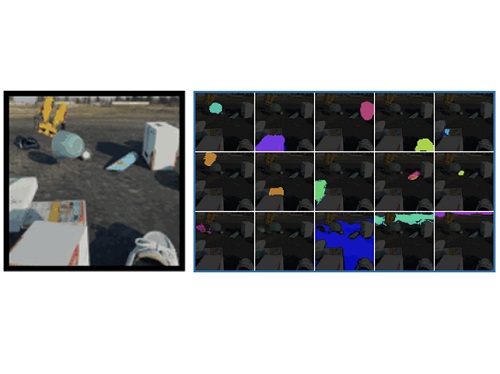

우리 대학 전산학부 안성진 교수 연구팀이 미국 럿거스(Rutgers) 대학교와 공동연구를 통해 사람의 라벨링 없이 스스로 영상 속 객체를 식별할 수 있는 인공지능 기술을 개발했다고 1일 밝혔다. 이 모델은 복잡한 영상에서 각 장면의 객체들에 대한 명시적인 라벨링 없이도 객체를 식별하는 최초의 인공지능 모델이다.

기계가 주변 환경을 지능적으로 인지하고 추론하기 위해서는 시각적 장면을 구성하는 객체들과 그들의 관계를 파악하는 능력이 필수적이다. 하지만 이 분야의 연구는 대부분 영상의 각 픽셀에 대응하는 객체의 라벨을 사람이 일일이 표시해야 하는 지도적 학습 방식을 사용했다. 이 같은 수작업은 오류가 발생하기 쉽고 많은 시간과 비용을 요구한다는 단점이 있다.

이에 반해 이번에 연구팀이 개발한 기술은 인간과 유사하게 환경에 대한 관측만으로 객체의 개념을 스스로 자가 학습하는 방식을 취한다. 이렇게 인간의 지도 없이 스스로 객체의 개념을 학습할 수 있는 인공지능은 차세대 인지 기술의 핵심으로 기대돼왔다.

비지도 학습을 이용한 이전 연구들은 단순한 객체 형태와 배경이 명확히 구분될 수 있는 단순한 장면에서만 객체를 식별하는 단점이 있었다. 이와 달리 이번에 안성진 교수 연구팀이 개발한 기술은 복잡한 형태의 많은 객체가 존재하는 사실적인 장면에도 적용될 수 있는 최초의 모델이다.

이 연구는 그림 인공지능 소프트웨어인 DALL-E와 같이 텍스트 입력을 통해 사실적인 이미지를 생성할 수 있는 이미지 생성 연구에서 영감을 얻었다. 연구팀은 텍스트를 입력하는 대신, 모델이 장면에서 객체를 감지하고 그 객체의 표상(representation)으로부터 이미지를 생성하는 방식으로 모델을 학습시켰다. 또한, 모델에 DALL-E와 유사한 트랜스포머 디코더를 사용하는 것이 사실적이고 복잡한 영상을 처리할 수 있게 한 주요 요인이라고 밝혔다.

연구팀은 복잡하고 정제되지 않은 영상뿐만 아니라, 많은 물고기가 있는 수족관과 교통이 혼잡한 도로의 상황을 담은 유튜브 영상과 같이 복잡한 실제 영상에서도 모델의 성능을 측정했다. 그 결과, 제시된 모델이 기존 모델보다 객체를 훨씬 더 정확하게 분할하고 일반화하는 것을 확인할 수 있었다.

연구팀을 이끈 안성진 교수는 "인간과 유사한 자가 학습 방식으로 상황을 인지하고 해석하는 혁신적인 기술ˮ이라며 "시각적 상황인지 능력을 획기적으로 개선해 지능형 로봇 분야, 자율 주행 분야뿐만 아니라 시각적 인공지능 기술 전반에 비용 절감과 성능향상을 가져올 수 있다ˮ고 말했다.

이번 연구는 미국 뉴올리언스에서 지난 11월 28일부터 개최되어 12월 9일까지 진행 예정인 세계 최고 수준의 기계학습(머신러닝) 학회인 제36회 신경정보처리학회(NeurIPS)에서 발표됐다.

2022.12.02 조회수 8720

세계 최초로 사람처럼 사물의 개념을 스스로 학습하는 장면 인식 기술 개발

우리 대학 전산학부 안성진 교수 연구팀이 미국 럿거스(Rutgers) 대학교와 공동연구를 통해 사람의 라벨링 없이 스스로 영상 속 객체를 식별할 수 있는 인공지능 기술을 개발했다고 1일 밝혔다. 이 모델은 복잡한 영상에서 각 장면의 객체들에 대한 명시적인 라벨링 없이도 객체를 식별하는 최초의 인공지능 모델이다.

기계가 주변 환경을 지능적으로 인지하고 추론하기 위해서는 시각적 장면을 구성하는 객체들과 그들의 관계를 파악하는 능력이 필수적이다. 하지만 이 분야의 연구는 대부분 영상의 각 픽셀에 대응하는 객체의 라벨을 사람이 일일이 표시해야 하는 지도적 학습 방식을 사용했다. 이 같은 수작업은 오류가 발생하기 쉽고 많은 시간과 비용을 요구한다는 단점이 있다.

이에 반해 이번에 연구팀이 개발한 기술은 인간과 유사하게 환경에 대한 관측만으로 객체의 개념을 스스로 자가 학습하는 방식을 취한다. 이렇게 인간의 지도 없이 스스로 객체의 개념을 학습할 수 있는 인공지능은 차세대 인지 기술의 핵심으로 기대돼왔다.

비지도 학습을 이용한 이전 연구들은 단순한 객체 형태와 배경이 명확히 구분될 수 있는 단순한 장면에서만 객체를 식별하는 단점이 있었다. 이와 달리 이번에 안성진 교수 연구팀이 개발한 기술은 복잡한 형태의 많은 객체가 존재하는 사실적인 장면에도 적용될 수 있는 최초의 모델이다.

이 연구는 그림 인공지능 소프트웨어인 DALL-E와 같이 텍스트 입력을 통해 사실적인 이미지를 생성할 수 있는 이미지 생성 연구에서 영감을 얻었다. 연구팀은 텍스트를 입력하는 대신, 모델이 장면에서 객체를 감지하고 그 객체의 표상(representation)으로부터 이미지를 생성하는 방식으로 모델을 학습시켰다. 또한, 모델에 DALL-E와 유사한 트랜스포머 디코더를 사용하는 것이 사실적이고 복잡한 영상을 처리할 수 있게 한 주요 요인이라고 밝혔다.

연구팀은 복잡하고 정제되지 않은 영상뿐만 아니라, 많은 물고기가 있는 수족관과 교통이 혼잡한 도로의 상황을 담은 유튜브 영상과 같이 복잡한 실제 영상에서도 모델의 성능을 측정했다. 그 결과, 제시된 모델이 기존 모델보다 객체를 훨씬 더 정확하게 분할하고 일반화하는 것을 확인할 수 있었다.

연구팀을 이끈 안성진 교수는 "인간과 유사한 자가 학습 방식으로 상황을 인지하고 해석하는 혁신적인 기술ˮ이라며 "시각적 상황인지 능력을 획기적으로 개선해 지능형 로봇 분야, 자율 주행 분야뿐만 아니라 시각적 인공지능 기술 전반에 비용 절감과 성능향상을 가져올 수 있다ˮ고 말했다.

이번 연구는 미국 뉴올리언스에서 지난 11월 28일부터 개최되어 12월 9일까지 진행 예정인 세계 최고 수준의 기계학습(머신러닝) 학회인 제36회 신경정보처리학회(NeurIPS)에서 발표됐다.

2022.12.02 조회수 8720