-

예종철 교수, 국제 응용 역문제 학회 기조강연

〈 예종철 교수 〉

우리 대학 바이오및뇌공학과 예종철 교수가 응용 수학분야 대표 학회 중 하나인 국제 응용 역문제 학회(Applied Inverse Problems Conference)에서 기조연설자로 선정돼 강연을 진행했다.

예 교수는 7월 11일 프랑스 그랑노블에서 열린 제10회 AIP 학회에서 세계 각국의 응용수학자 8백여 명을 대상으로 ‘역문제를 위한 인공지능 네트워크의 기하학적인 구조의 이해(Understanding Geometry of Encoder-Decoder CNN for Inverse Problems)’라는 주제로 영상처리 및 역문제에 사용되는 인공지능기술의 현황을 소개하고, 예 교수가 개척해 온 인공지능망의 기하학적인 구조에 대한 최신 이론을 발표했다.

예 교수는 의료 영상 복원 등 다양한 역문제에 적용되는 인공지능 기술을 개척하고, 이것이 동작하는 원리에 대한 기하학적인 구조를 밝히는 등 역문제 분야 인공지능 기술을 주도하는 점을 인정받아 이번 기조연설자로 선정됐다.

예 교수는 기조연설을 통해 “인공지능기술은 블랙박스가 아니라 조합적인 표현되는 최적화된 기저함수로서 이해할 수 있으며, 인공지능은 기존의 조화분석론(harmonic analysis)의 지평을 확대할 수 있는 새로운 수학 분야로 떠오르고 있다”라고 말했다.

또한 “인공지능은 기존의 질병 진단을 뛰어넘어 의사들의 진료를 더 정확하게 도우며 환자의 편의를 극대화할 수 있는 고화질, 저선량, 고속 촬영 기술을 가능하게 한 핵심기술로 떠오르고 있으므로 많은 연구가 필요하다”라고 인공지능 기술이 나아가야 할 미래방향을 제시했다.

예종철 교수, 국제 응용 역문제 학회 기조강연

〈 예종철 교수 〉

우리 대학 바이오및뇌공학과 예종철 교수가 응용 수학분야 대표 학회 중 하나인 국제 응용 역문제 학회(Applied Inverse Problems Conference)에서 기조연설자로 선정돼 강연을 진행했다.

예 교수는 7월 11일 프랑스 그랑노블에서 열린 제10회 AIP 학회에서 세계 각국의 응용수학자 8백여 명을 대상으로 ‘역문제를 위한 인공지능 네트워크의 기하학적인 구조의 이해(Understanding Geometry of Encoder-Decoder CNN for Inverse Problems)’라는 주제로 영상처리 및 역문제에 사용되는 인공지능기술의 현황을 소개하고, 예 교수가 개척해 온 인공지능망의 기하학적인 구조에 대한 최신 이론을 발표했다.

예 교수는 의료 영상 복원 등 다양한 역문제에 적용되는 인공지능 기술을 개척하고, 이것이 동작하는 원리에 대한 기하학적인 구조를 밝히는 등 역문제 분야 인공지능 기술을 주도하는 점을 인정받아 이번 기조연설자로 선정됐다.

예 교수는 기조연설을 통해 “인공지능기술은 블랙박스가 아니라 조합적인 표현되는 최적화된 기저함수로서 이해할 수 있으며, 인공지능은 기존의 조화분석론(harmonic analysis)의 지평을 확대할 수 있는 새로운 수학 분야로 떠오르고 있다”라고 말했다.

또한 “인공지능은 기존의 질병 진단을 뛰어넘어 의사들의 진료를 더 정확하게 도우며 환자의 편의를 극대화할 수 있는 고화질, 저선량, 고속 촬영 기술을 가능하게 한 핵심기술로 떠오르고 있으므로 많은 연구가 필요하다”라고 인공지능 기술이 나아가야 할 미래방향을 제시했다.

2019.07.25

조회수 8261

-

한동수, 신진우 교수, 느린 인터넷 환경에서도 고화질 영상 감상 기술 개발

〈 (왼쪽부터) 김재홍, 정영목 석사과정, 여현호 박사과정, 한동수, 신진우 교수 〉

우리 대학 전기및전자공학부 신진우, 한동수 교수 연구팀이 딥러닝 기술을 이용한 인터넷 비디오 전송 기술을 개발했다.

여현호, 정영목, 김재홍 학생이 주도한 이번 연구 결과는 격년으로 개최되는 컴퓨터 시스템 분야의 유명 학술회의인 ‘유즈닉스 OSDI(USENIX OSDI)’에서 10월 10일 발표됐고 현재 국제 특허 출원을 완료했다.

이 기술은 유튜브, 넷플릭스 등에서 비디오를 사용자에게 전송할 때 사용하는 적응형 스트리밍(HTTP adaptive streaming) 비디오 전송기술과 딥러닝 기술인 심층 콘볼루션 신경망(CNN) 기반의 초해상화를 접목한 새로운 방식이다.

이는 열악한 인터넷 환경에서도 고품질, 고화질(HD)의 비디오 시청이 가능할 뿐 아니라 4K, AV/VR 등을 시청할 수 있는 새로운 기반 기술이 될 것으로 기대된다.

기존의 적응형 스트리밍은 시시각각 변화하는 인터넷 대역폭에 맞춰 스트리밍 중인 비디오 화질을 실시간으로 조절한다. 이를 위해 다양한 알고리즘이 연구되고 있으나 네트워크 환경이 좋지 않을 때는 어느 알고리즘이라도 고화질의 비디오를 감상할 수 없다는 한계가 있다.

연구팀은 적응형 스트리밍에 초해상화를 접목해 인터넷 대역폭에 의존하는 기존 적응형 스트리밍의 한계를 극복했다. 기존 기술은 비디오를 시청 시 긴 영상을 짧은 시간의 여러 비디오 조각으로 나눠 다운받는다. 이를 위해 비디오를 제공하는 서버에서는 비디오를 미리 일정 시간 길이로 나눠 준비해놓는 방식이다.

연구팀이 새롭게 개발한 시스템은 추가로 신경망 조각을 비디오 조각과 같이 다운받게 했다. 이를 위해 비디오 서버에서는 각 비디오에 대해 학습이 된 신경망을 제공하며 또 사용자 컴퓨터의 사양을 고려해 다양한 크기의 신경망을 제공한다.

제일 큰 신경망의 크기는 총 2메가바이트(MB)이며 비디오에 비해 상당히 작은 크기이다. 신경망을 사용자 비디오 플레이어에서 다운받을 때는 여러 개의 조각으로 나눠 다운받으며 신경망의 일부만 다운받아도 조금 떨어지는 성능의 초해상화 기술을 이용할 수 있도록 설계했다.

사용자의 컴퓨터에서는 동영상 시청과 함께 병렬적으로 심층 콘볼루션 신경망(CNN) 기반의 초해상화 기술을 사용해 비디오 플레이어 버퍼에 저장된 저화질 비디오를 고화질로 바꾸게 된다. 모든 과정은 실시간으로 이뤄지며 이를 통해 사용자들이 고화질의 비디오를 시청할 수 있다.

연구팀이 개발한 시스템을 이용하면 최대 26.9%의 적은 인터넷 대역폭으로도 최신 적응형 스트리밍과 같은 체감 품질(QoE, Quality of Experience)을 제공할 수 있다. 또한 같은 인터넷 대역폭이 주어진 경우에는 최신 적응형 스트리밍보다 평균 40% 높은 체감 품질을 제공할 수 있다.

이 시스템은 딥러닝 방식을 이용해 기존의 비디오 압축 방식보다 더 많은 압축을 이뤄낸 것으로 볼 수 있다. 연구팀의 기술은 콘볼루션 신경망 기반의 초해상화를 인터넷 비디오에 적용한 차세대 인터넷 비디오 시스템으로 권위 잇는 학회로부터 효용성을 인정받았다.

한 교수는 “지금은 데스크톱에서만 구현했지만 향후 모바일 기기에서도 작동하도록 발전시킬 예정이다”며 “이 기술은 현재 유튜브, 넷플릭스 등 스트리밍 기업에서 사용하는 비디오 전송 시스템에 적용한 것으로 실용성에 큰 의의가 있다”고 말했다.

이번 연구는 과학기술정보통신부 정보통신기술진흥센터(IITP) 방송통신연구개발 사업의 지원을 받아 수행됐다.

비디오 자료 링크 주소 1.

https://www.dropbox.com/sh/z2hvw1iv1459698/AADk3NB5EBgDhv3J4aiZo9nta?dl=0&lst =

□ 그림 설명

그림1. 기술이 적용되기 전 화질(좌)과 적용된 후 화질 비교(우)

그림2. 기술 개념도

그림3. 비디오 서버로부터 비디오가 전송된 후 저화질의 비디오가 고화질의 비디오로 변환되는 과정

한동수, 신진우 교수, 느린 인터넷 환경에서도 고화질 영상 감상 기술 개발

〈 (왼쪽부터) 김재홍, 정영목 석사과정, 여현호 박사과정, 한동수, 신진우 교수 〉

우리 대학 전기및전자공학부 신진우, 한동수 교수 연구팀이 딥러닝 기술을 이용한 인터넷 비디오 전송 기술을 개발했다.

여현호, 정영목, 김재홍 학생이 주도한 이번 연구 결과는 격년으로 개최되는 컴퓨터 시스템 분야의 유명 학술회의인 ‘유즈닉스 OSDI(USENIX OSDI)’에서 10월 10일 발표됐고 현재 국제 특허 출원을 완료했다.

이 기술은 유튜브, 넷플릭스 등에서 비디오를 사용자에게 전송할 때 사용하는 적응형 스트리밍(HTTP adaptive streaming) 비디오 전송기술과 딥러닝 기술인 심층 콘볼루션 신경망(CNN) 기반의 초해상화를 접목한 새로운 방식이다.

이는 열악한 인터넷 환경에서도 고품질, 고화질(HD)의 비디오 시청이 가능할 뿐 아니라 4K, AV/VR 등을 시청할 수 있는 새로운 기반 기술이 될 것으로 기대된다.

기존의 적응형 스트리밍은 시시각각 변화하는 인터넷 대역폭에 맞춰 스트리밍 중인 비디오 화질을 실시간으로 조절한다. 이를 위해 다양한 알고리즘이 연구되고 있으나 네트워크 환경이 좋지 않을 때는 어느 알고리즘이라도 고화질의 비디오를 감상할 수 없다는 한계가 있다.

연구팀은 적응형 스트리밍에 초해상화를 접목해 인터넷 대역폭에 의존하는 기존 적응형 스트리밍의 한계를 극복했다. 기존 기술은 비디오를 시청 시 긴 영상을 짧은 시간의 여러 비디오 조각으로 나눠 다운받는다. 이를 위해 비디오를 제공하는 서버에서는 비디오를 미리 일정 시간 길이로 나눠 준비해놓는 방식이다.

연구팀이 새롭게 개발한 시스템은 추가로 신경망 조각을 비디오 조각과 같이 다운받게 했다. 이를 위해 비디오 서버에서는 각 비디오에 대해 학습이 된 신경망을 제공하며 또 사용자 컴퓨터의 사양을 고려해 다양한 크기의 신경망을 제공한다.

제일 큰 신경망의 크기는 총 2메가바이트(MB)이며 비디오에 비해 상당히 작은 크기이다. 신경망을 사용자 비디오 플레이어에서 다운받을 때는 여러 개의 조각으로 나눠 다운받으며 신경망의 일부만 다운받아도 조금 떨어지는 성능의 초해상화 기술을 이용할 수 있도록 설계했다.

사용자의 컴퓨터에서는 동영상 시청과 함께 병렬적으로 심층 콘볼루션 신경망(CNN) 기반의 초해상화 기술을 사용해 비디오 플레이어 버퍼에 저장된 저화질 비디오를 고화질로 바꾸게 된다. 모든 과정은 실시간으로 이뤄지며 이를 통해 사용자들이 고화질의 비디오를 시청할 수 있다.

연구팀이 개발한 시스템을 이용하면 최대 26.9%의 적은 인터넷 대역폭으로도 최신 적응형 스트리밍과 같은 체감 품질(QoE, Quality of Experience)을 제공할 수 있다. 또한 같은 인터넷 대역폭이 주어진 경우에는 최신 적응형 스트리밍보다 평균 40% 높은 체감 품질을 제공할 수 있다.

이 시스템은 딥러닝 방식을 이용해 기존의 비디오 압축 방식보다 더 많은 압축을 이뤄낸 것으로 볼 수 있다. 연구팀의 기술은 콘볼루션 신경망 기반의 초해상화를 인터넷 비디오에 적용한 차세대 인터넷 비디오 시스템으로 권위 잇는 학회로부터 효용성을 인정받았다.

한 교수는 “지금은 데스크톱에서만 구현했지만 향후 모바일 기기에서도 작동하도록 발전시킬 예정이다”며 “이 기술은 현재 유튜브, 넷플릭스 등 스트리밍 기업에서 사용하는 비디오 전송 시스템에 적용한 것으로 실용성에 큰 의의가 있다”고 말했다.

이번 연구는 과학기술정보통신부 정보통신기술진흥센터(IITP) 방송통신연구개발 사업의 지원을 받아 수행됐다.

비디오 자료 링크 주소 1.

https://www.dropbox.com/sh/z2hvw1iv1459698/AADk3NB5EBgDhv3J4aiZo9nta?dl=0&lst =

□ 그림 설명

그림1. 기술이 적용되기 전 화질(좌)과 적용된 후 화질 비교(우)

그림2. 기술 개념도

그림3. 비디오 서버로부터 비디오가 전송된 후 저화질의 비디오가 고화질의 비디오로 변환되는 과정

2018.10.30

조회수 9093

-

유회준 교수, 딥러닝용 AI 반도체 개발

우리대학 전기및전자공학부 유회준 교수 연구팀이 스타트업 '유엑스 팩토리'와 함께 가변 인공신경망 기술을 적용해 딥러닝을 효율적으로 처리하는 AI 반도체를 개발했다. 딥러닝이란 컴퓨터가 마치 사람처럼 스스로 학습할 수 있도록 인공신경망을 기반으로 구축한 '기계 학습' 기술이다.

유 교수 연구팀이 개발한 새로운 칩은 반도체 안에서 인공신경망의 무게 정밀도를 조절함으로써 에너지 효율과 정확도를 조절한다. 1비트부터 16비트까지 소프트웨어로 간편하게 조절하면서 상황에 맞춰 최적화된 동작을 얻어낸다. 하나의 칩이지만 '콘볼루션 신경망'(CNN)과 '재귀 신경망'(RNN)을 동시에 처리할 수 있다. CNN은 이미지를 분류나 탐지하는 데 쓰이며, RNN은 주로 시간의 흐름에 따라 변화하는 영상과 음성 등 데이터 학습에 적합하다. 또 통합 신경망 프로세서(UNPU)를 통해 인식 대상에 따라 에너지효율과 정확도를 다르게 설정하는 것도 가능하다.

모바일에서 AI 기술을 구현하려면 고속 연산을 '저전력'으로 처리해야 한다. 그렇지 않으면 한꺼번에 많은 정보를 처리하면서 발생하는 발열로 인해 배터리 폭발 등의 사고가 일어날 수 있기 때문이다. 연구팀에 따르면 이번 칩은 세계 최고 수준 모바일용 AI 칩 대비 CNN과 RNN 연산 성능이 각각 1.15배, 13.8배이 달한다. 에너지효율도 40% 높은 것으로 나타났다.

스마트폰 카메라를 통해 사람의 얼굴 표정을 인식해 행복, 슬픔, 놀람, 공포, 무표정 등 7가지의 감정을 자동으로 인식하는 감정인식 시스템도 개발됐다. 이 시스템은 감정 상태를 스마트폰 상에 실시간으로 표시한다. 유 교수 연구팀의 이번 연구는 지난 13일 미국 샌프란시스코에서 열린 국제고체회로설계학회(ISSCC)에서 발표됐다.

유회준 교수는 "기술 상용화에는 1년 정도 더 걸릴 전망"이라며 " 모바일에서 AI를 구현하기 위해 저전력으로 가속하는 반도체를 개발했으며, 향후 물체인식, 감정인식, 동작인식, 자동 번역 등 다양하게 응용될 것으로 기대된다"고 설명했다.

유회준 교수, 딥러닝용 AI 반도체 개발

우리대학 전기및전자공학부 유회준 교수 연구팀이 스타트업 '유엑스 팩토리'와 함께 가변 인공신경망 기술을 적용해 딥러닝을 효율적으로 처리하는 AI 반도체를 개발했다. 딥러닝이란 컴퓨터가 마치 사람처럼 스스로 학습할 수 있도록 인공신경망을 기반으로 구축한 '기계 학습' 기술이다.

유 교수 연구팀이 개발한 새로운 칩은 반도체 안에서 인공신경망의 무게 정밀도를 조절함으로써 에너지 효율과 정확도를 조절한다. 1비트부터 16비트까지 소프트웨어로 간편하게 조절하면서 상황에 맞춰 최적화된 동작을 얻어낸다. 하나의 칩이지만 '콘볼루션 신경망'(CNN)과 '재귀 신경망'(RNN)을 동시에 처리할 수 있다. CNN은 이미지를 분류나 탐지하는 데 쓰이며, RNN은 주로 시간의 흐름에 따라 변화하는 영상과 음성 등 데이터 학습에 적합하다. 또 통합 신경망 프로세서(UNPU)를 통해 인식 대상에 따라 에너지효율과 정확도를 다르게 설정하는 것도 가능하다.

모바일에서 AI 기술을 구현하려면 고속 연산을 '저전력'으로 처리해야 한다. 그렇지 않으면 한꺼번에 많은 정보를 처리하면서 발생하는 발열로 인해 배터리 폭발 등의 사고가 일어날 수 있기 때문이다. 연구팀에 따르면 이번 칩은 세계 최고 수준 모바일용 AI 칩 대비 CNN과 RNN 연산 성능이 각각 1.15배, 13.8배이 달한다. 에너지효율도 40% 높은 것으로 나타났다.

스마트폰 카메라를 통해 사람의 얼굴 표정을 인식해 행복, 슬픔, 놀람, 공포, 무표정 등 7가지의 감정을 자동으로 인식하는 감정인식 시스템도 개발됐다. 이 시스템은 감정 상태를 스마트폰 상에 실시간으로 표시한다. 유 교수 연구팀의 이번 연구는 지난 13일 미국 샌프란시스코에서 열린 국제고체회로설계학회(ISSCC)에서 발표됐다.

유회준 교수는 "기술 상용화에는 1년 정도 더 걸릴 전망"이라며 " 모바일에서 AI를 구현하기 위해 저전력으로 가속하는 반도체를 개발했으며, 향후 물체인식, 감정인식, 동작인식, 자동 번역 등 다양하게 응용될 것으로 기대된다"고 설명했다.

2018.02.26

조회수 12335

-

김문철 교수, 인공지능 통해 풀HD영상 4K UHD로 실시간 변환

〈 김 문 철 교수 〉

우리 대학 전기및전자공학부 김문철 교수 연구팀이 딥러닝 기술을 이용해 풀 HD 비디오 영상을 4K UHD 초고화질 영상으로 초해상화 변환할 수 있는 기술을 개발했다.

이 기술은 인공지능의 핵심 기술인 심층 콘볼루션 신경망(Deep Convolutional Neural Network, DCNN)을 하드웨어로 구현했다. 초당 60프레임의 초고해상도 4K UHD 화면을 실시간으로 생성할 수 있는 알고리즘 및 하드웨어 개발을 통해 향후 프리미엄 UHD TV, 360 VR, 4K IPTV 등에 기여할 것으로 기대된다.

이번 연구는 KAIST 전기및전자공학부 김용우, 최재석 박사과정 등이 주도했고 현재 특허 출원을 준비 중이다.

최근 영상 화질 개선 연구에 인공지능의 핵심 기술인 심층 콘볼루션 신경망을 적용시키려는 노력이 활발히 이뤄지고 있다. 그러나 이러한 심층 콘볼루션 신경망 기술은 연산 복잡도와 매우 높고 사용되는 메모리가 커 작은 규모의 하드웨어를 통해 초고해상도 영상으로 실시간 변환하는 데 한계가 있다.

기존의 프레임 단위로 영상을 처리하던 방식은 DRAM과 같은 외부 메모리 사용이 필수적인데 이로 인해 영상 데이터를 처리할 때 지나친 외부 메모리 접근으로 인한 메모리 병목현상과 전력 소모 현상이 발생했다.

김 교수 연구팀은 프레임 단위 대신 라인 단위로 데이터를 처리할 수 있는 효율적인 심층 콘볼루션 신경망 구조를 개발해 외부 메모리를 사용하지 않고도 작은 규모의 하드웨어에서 초당 60 프레임의 4K UHD 초해상화를 구현했다.

연구팀은 기존 소프트웨어 방식의 심층 콘볼루션 신경망 기반의 고속 알고리즘과 비교해 필터 파라미터를 65% 정도만 적용하고도 유사한 화질을 유지했다.

이는 딥러닝 기술을 이용한 고해상도 영상 변환 기술이 활발히 진행되는 가운데 초당 60프레임의 4K UHD 초해상화를 하드웨어로 실현한 첫 사례로 꼽힌다.

김 교수는 “이번 연구는 심층 콘볼루션 신경망이 작은 규모의 하드웨어에서 초고품질 영상 처리에 실질적으로 응요 가능한 기술임을 보인 매우 중요한 사례다”며 “현재 프리미엄 UHD TV 및 UHD 방송 콘텐츠 생성, 360도 VR 콘텐츠, 4K IPTV 서비스에 매우 효과적으로 적용할 수 있다”고 말했다.

이번 연구는 과학기술정보통신부 정보통신기술진흥센터(IITP) ICT 기초연구실지원사업의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 실시간 AI(딥러닝) 기반 고속 초고해상도 업스케일링 기술

그림2.심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 (FPGA)

그림3. 심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 시연

김문철 교수, 인공지능 통해 풀HD영상 4K UHD로 실시간 변환

〈 김 문 철 교수 〉

우리 대학 전기및전자공학부 김문철 교수 연구팀이 딥러닝 기술을 이용해 풀 HD 비디오 영상을 4K UHD 초고화질 영상으로 초해상화 변환할 수 있는 기술을 개발했다.

이 기술은 인공지능의 핵심 기술인 심층 콘볼루션 신경망(Deep Convolutional Neural Network, DCNN)을 하드웨어로 구현했다. 초당 60프레임의 초고해상도 4K UHD 화면을 실시간으로 생성할 수 있는 알고리즘 및 하드웨어 개발을 통해 향후 프리미엄 UHD TV, 360 VR, 4K IPTV 등에 기여할 것으로 기대된다.

이번 연구는 KAIST 전기및전자공학부 김용우, 최재석 박사과정 등이 주도했고 현재 특허 출원을 준비 중이다.

최근 영상 화질 개선 연구에 인공지능의 핵심 기술인 심층 콘볼루션 신경망을 적용시키려는 노력이 활발히 이뤄지고 있다. 그러나 이러한 심층 콘볼루션 신경망 기술은 연산 복잡도와 매우 높고 사용되는 메모리가 커 작은 규모의 하드웨어를 통해 초고해상도 영상으로 실시간 변환하는 데 한계가 있다.

기존의 프레임 단위로 영상을 처리하던 방식은 DRAM과 같은 외부 메모리 사용이 필수적인데 이로 인해 영상 데이터를 처리할 때 지나친 외부 메모리 접근으로 인한 메모리 병목현상과 전력 소모 현상이 발생했다.

김 교수 연구팀은 프레임 단위 대신 라인 단위로 데이터를 처리할 수 있는 효율적인 심층 콘볼루션 신경망 구조를 개발해 외부 메모리를 사용하지 않고도 작은 규모의 하드웨어에서 초당 60 프레임의 4K UHD 초해상화를 구현했다.

연구팀은 기존 소프트웨어 방식의 심층 콘볼루션 신경망 기반의 고속 알고리즘과 비교해 필터 파라미터를 65% 정도만 적용하고도 유사한 화질을 유지했다.

이는 딥러닝 기술을 이용한 고해상도 영상 변환 기술이 활발히 진행되는 가운데 초당 60프레임의 4K UHD 초해상화를 하드웨어로 실현한 첫 사례로 꼽힌다.

김 교수는 “이번 연구는 심층 콘볼루션 신경망이 작은 규모의 하드웨어에서 초고품질 영상 처리에 실질적으로 응요 가능한 기술임을 보인 매우 중요한 사례다”며 “현재 프리미엄 UHD TV 및 UHD 방송 콘텐츠 생성, 360도 VR 콘텐츠, 4K IPTV 서비스에 매우 효과적으로 적용할 수 있다”고 말했다.

이번 연구는 과학기술정보통신부 정보통신기술진흥센터(IITP) ICT 기초연구실지원사업의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 실시간 AI(딥러닝) 기반 고속 초고해상도 업스케일링 기술

그림2.심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 (FPGA)

그림3. 심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 시연

2018.01.16

조회수 14382

-

유회준 교수, 인공지능 얼굴인식 시스템 K-EYE 개발

우리 대학 전기및전자공학과 유회준 교수 연구팀이 딥러닝 알고리즘을 세계 최소 전력으로 구현하는 인공지능 반도체 칩 CNNP를 개발했다. 그리고 이를 내장한 얼굴인식 시스템 K-Eye 시리즈를 개발했다.

연구팀이 개발한 K-Eye 시리즈는 웨어러블 디바이스와 동글 타입 2가지로 구성된다. 웨어러블 타입인 K-Eye는 블루투스로 스마트폰과 연동 가능하다.

봉경렬 박사과정이 주도하고 ㈜유엑스팩토리(대표 박준영)과 공동으로 개발한 이번 연구는 지난 2월 미국에서 열린 국제고체회로설계학회(ISSCC)에서 세계 최저전력 CNN칩으로 발표돼 주목을 받았다.

최근 글로벌 IT 기업들이 알파고를 비롯한 인공지능 관련 기술들을 경쟁적으로 발표하고 있다. 그러나 대부분은 소프트웨어 기술이라 속도가 느리고 모바일 환경에서는 구현이 어렵다는 한계가 있다.

따라서 이를 고속 및 저전력으로 구동하기 위해 인공지능 반도체 칩 개발이 필수적이다.

연구팀의 K-Eye 시리즈는 1mW 내외의 적은 전력만으로도 항상 얼굴 인식을 수행하는 상태를 유지하면서 사람의 얼굴을 먼저 알아보고 반응할 수 있다는 특징을 갖는다.

K-Eye의 핵심 기술인 얼웨이즈 온(Always-On) 이미지 센서와 CNNP라는 얼굴 인식 처리 칩이 있었기 때문에 위와 같은 세계 최저전력 기술이 가능했다.

첫 번째 칩인 얼웨이즈 온(Always-On) 이미지 센서는 얼굴이 있는지 없는지 스스로 판단할 수 있어 얼굴 인식이 될 때에만 작동하게 해 대기 전력을 대폭 낮출 수 있다.

얼굴 검출 이미지 센서는 아날로그 프로세싱으로 디지털 프로세싱을 제어해 센서 자체의 출력 소모를 줄였다. 픽셀과 결합된 아날로그 프로세서는 배경 부분과 얼굴 부분을 구분하는 역할을 하고 디지털 프로세서는 선택된 일부 영역에서만 얼굴 검출을 수행하면 돼 효율적인 작업이 가능하다.

두 번째 칩인 CNNP는 딥러닝을 회로, 구조, 알고리즘 전반에 도입하고 재해석을 진행해 최저 수준의 전력을 구현하는 역할을 했다.

특히 CNNP칩은 3가지의 핵심 기술을 사용했는데 ▲알파고 인공지능 알고리즘에서 사용하는 2차원 계산을 1차원 계산으로 바꿔 고속 저전력화 ▲분산형으로 배치된 칩 내 메모리가 가로방향 뿐 아니라 세로방향도 읽어낼 수 있는 특수 저전력 분산 메모리로의 설계 ▲1024개의 곱셈기와 덧셈기가 동시에 구동돼 막강한 계산력을 가지면서 외부 통신망을 거치지 않고 직접 계산 결과를 주고받을 수 있게 한 점이다.

CNNP는 97%의 인식률을 가지면서도 알파고에 사용된 GPU에 비해 5천분의 1정도의 낮은 전력인 0.6mW만을 소모한다.

K-Eye를 목에 건 사용자는 앞에서 다가오는 상대방의 얼굴이 화면에 떠오르면 미리 저장된 정보와 실시간으로 찍힌 사진을 비교해 상대방의 이름 등 정보를 자연스럽게 확인할 수 있다.

동글 타입인 K-EyeQ는 스마트폰에 장착해 이용할 수 있는데 사용자를 알아보고 반응하는 기능을 한다. 미리 기억시킨 사용자의 얼굴이 화면을 향하기만 하면 스마트폰 화면이 저절로 켜지면서 그와 관련된 정보를 제공한다.

또한 입력된 얼굴이 사진인지 실제 사람인지도 구분할 수 있어 사용자의 얼굴 대신 사진을 보여주면 스마트폰은 반응하지 않는다.

유 교수는 “인공지능 반도체 프로세서가 4차 산업혁명시대를 주도할 것으로 기대된다”며 “이번 인공지능 칩과 인식기의 개발로 인해 세계시장에서 한국이 인공지능 산업의 주도권을 갖길 기대한다”고 말했다.

□ 사진 설명.

사진1. K-EYE 사진

사진2. K-EYEQ 사진

사진3. CNNP 칩 사진

유회준 교수, 인공지능 얼굴인식 시스템 K-EYE 개발

우리 대학 전기및전자공학과 유회준 교수 연구팀이 딥러닝 알고리즘을 세계 최소 전력으로 구현하는 인공지능 반도체 칩 CNNP를 개발했다. 그리고 이를 내장한 얼굴인식 시스템 K-Eye 시리즈를 개발했다.

연구팀이 개발한 K-Eye 시리즈는 웨어러블 디바이스와 동글 타입 2가지로 구성된다. 웨어러블 타입인 K-Eye는 블루투스로 스마트폰과 연동 가능하다.

봉경렬 박사과정이 주도하고 ㈜유엑스팩토리(대표 박준영)과 공동으로 개발한 이번 연구는 지난 2월 미국에서 열린 국제고체회로설계학회(ISSCC)에서 세계 최저전력 CNN칩으로 발표돼 주목을 받았다.

최근 글로벌 IT 기업들이 알파고를 비롯한 인공지능 관련 기술들을 경쟁적으로 발표하고 있다. 그러나 대부분은 소프트웨어 기술이라 속도가 느리고 모바일 환경에서는 구현이 어렵다는 한계가 있다.

따라서 이를 고속 및 저전력으로 구동하기 위해 인공지능 반도체 칩 개발이 필수적이다.

연구팀의 K-Eye 시리즈는 1mW 내외의 적은 전력만으로도 항상 얼굴 인식을 수행하는 상태를 유지하면서 사람의 얼굴을 먼저 알아보고 반응할 수 있다는 특징을 갖는다.

K-Eye의 핵심 기술인 얼웨이즈 온(Always-On) 이미지 센서와 CNNP라는 얼굴 인식 처리 칩이 있었기 때문에 위와 같은 세계 최저전력 기술이 가능했다.

첫 번째 칩인 얼웨이즈 온(Always-On) 이미지 센서는 얼굴이 있는지 없는지 스스로 판단할 수 있어 얼굴 인식이 될 때에만 작동하게 해 대기 전력을 대폭 낮출 수 있다.

얼굴 검출 이미지 센서는 아날로그 프로세싱으로 디지털 프로세싱을 제어해 센서 자체의 출력 소모를 줄였다. 픽셀과 결합된 아날로그 프로세서는 배경 부분과 얼굴 부분을 구분하는 역할을 하고 디지털 프로세서는 선택된 일부 영역에서만 얼굴 검출을 수행하면 돼 효율적인 작업이 가능하다.

두 번째 칩인 CNNP는 딥러닝을 회로, 구조, 알고리즘 전반에 도입하고 재해석을 진행해 최저 수준의 전력을 구현하는 역할을 했다.

특히 CNNP칩은 3가지의 핵심 기술을 사용했는데 ▲알파고 인공지능 알고리즘에서 사용하는 2차원 계산을 1차원 계산으로 바꿔 고속 저전력화 ▲분산형으로 배치된 칩 내 메모리가 가로방향 뿐 아니라 세로방향도 읽어낼 수 있는 특수 저전력 분산 메모리로의 설계 ▲1024개의 곱셈기와 덧셈기가 동시에 구동돼 막강한 계산력을 가지면서 외부 통신망을 거치지 않고 직접 계산 결과를 주고받을 수 있게 한 점이다.

CNNP는 97%의 인식률을 가지면서도 알파고에 사용된 GPU에 비해 5천분의 1정도의 낮은 전력인 0.6mW만을 소모한다.

K-Eye를 목에 건 사용자는 앞에서 다가오는 상대방의 얼굴이 화면에 떠오르면 미리 저장된 정보와 실시간으로 찍힌 사진을 비교해 상대방의 이름 등 정보를 자연스럽게 확인할 수 있다.

동글 타입인 K-EyeQ는 스마트폰에 장착해 이용할 수 있는데 사용자를 알아보고 반응하는 기능을 한다. 미리 기억시킨 사용자의 얼굴이 화면을 향하기만 하면 스마트폰 화면이 저절로 켜지면서 그와 관련된 정보를 제공한다.

또한 입력된 얼굴이 사진인지 실제 사람인지도 구분할 수 있어 사용자의 얼굴 대신 사진을 보여주면 스마트폰은 반응하지 않는다.

유 교수는 “인공지능 반도체 프로세서가 4차 산업혁명시대를 주도할 것으로 기대된다”며 “이번 인공지능 칩과 인식기의 개발로 인해 세계시장에서 한국이 인공지능 산업의 주도권을 갖길 기대한다”고 말했다.

□ 사진 설명.

사진1. K-EYE 사진

사진2. K-EYEQ 사진

사진3. CNNP 칩 사진

2017.06.14

조회수 13033

-

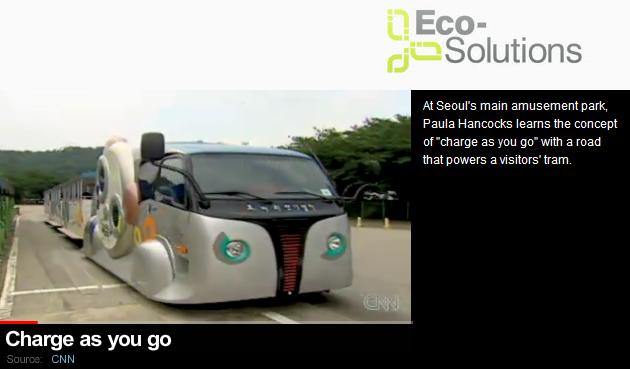

KAIST 무선충전전기자동차, CNN 방영

우리 학교에서 개발한 무선충전전기자동차가 지난 8월 29일 미국 CNN방송의 "Eco Solutions"라는 프로그램에 방영됐다.

CNN은 올 7월 19일 서울대공원에서 상용서비스를 시작한 KAIST 무선충전전기자동차가 기존 디젤 "코끼리열차"에 비해 매연과 소음이 없는 친환경 전기자동차로 방문객들로부터 커다란 호응을 받고 있다고 소개했다.

CNN 링크 : http://edition.cnn.com/CNNI/Programs/eco.solutions/index.html

YouTube 링크 : http://www.youtube.com/watch?v=QLzmFFqPJfo

KAIST 무선충전전기자동차, CNN 방영

우리 학교에서 개발한 무선충전전기자동차가 지난 8월 29일 미국 CNN방송의 "Eco Solutions"라는 프로그램에 방영됐다.

CNN은 올 7월 19일 서울대공원에서 상용서비스를 시작한 KAIST 무선충전전기자동차가 기존 디젤 "코끼리열차"에 비해 매연과 소음이 없는 친환경 전기자동차로 방문객들로부터 커다란 호응을 받고 있다고 소개했다.

CNN 링크 : http://edition.cnn.com/CNNI/Programs/eco.solutions/index.html

YouTube 링크 : http://www.youtube.com/watch?v=QLzmFFqPJfo

2011.09.04

조회수 9958

-

대사공학적으로 개량된 박테리아로 범용 플라스틱 생산기술 개발

- 이상엽 교수팀과 LG 화학 연구팀 공동개발

- 바이오테크놀로지 바이오엔지니어링(Biotechnology and Bioengineering)지 게재예정

생명화학공학과 이상엽(李相燁, 45세, LG화학 석좌교수, 생명과학기술대학 학장) 특훈교수팀과 LG화학 기술연구원(원장 유진녕) 박시재, 양택호박사팀이 4년여 간의 공동연구를 통해 박테리아를 이용하여 재생 가능한 바이오매스로부터 플라스틱을 생산하는 기술을 최근 개발했다.

교육과학기술부 시스템생물학 연구개발 사업과 LG화학 석좌교수 연구비로 지원된 이번 연구에서는 시스템 대사공학과 효소공학 기법을 접목, 자연적으로는 생성되지 않는 플라스틱(unnatural polymer)의 일종으로 최근 각광을 받고 있는 폴리유산(Polylactic acid, PLA)을 효율적으로 생산할 수 있는 대장균을 개발한 것이다.

이번 연구 결과는 바이오공학 분야 최고 전통의 바이오테크놀로지 바이오엔지니어링(Biotechnology and Bioengineering)지에 게재 승인됐으며 스포트라이트 논문(Spotlight paper)으로 선정돼 2010년 1월호에 두 편의 연속 논문으로 게재될 예정이다.

두 논문의 제목은 ‘개량된 프로피오네이트 코엔자임 에이 트랜스퍼레이즈와 폴리하이드록시알카노에이트 중합효소를 이용한 폴리유산과 그의 공중합체의 생합성(Biosynthesis of Polylactic acid and its Copolymers Using Evolved Propionate CoA Transferase and PHA Synthase)’과 ‘폴리유산과 그의 공중합체의 생산을 위한 대장균의 대사공학(Metabolic Engineering of Escherichia coli for the Production of Polylactic Acid and its Copolymers)’이다. 19건의 특허가 전 세계 출원 중이다.

기존의 복잡한 2단계 공정을 통해 생산되던 폴리유산을 재생가능한 원료로부터 미생물의 직접 발효에 의해 생산이 가능하도록 한 혁신적인 본 연구 전략은 앞으로 석유 유래 플라스틱을 대체할 수 있는 다양한 비자연 고분자(unnatural polymer)들의 생산에 활용될 획기적인 기술로 평가되고 있다.

폴리유산 (Polylactic acid, PLA)은 많은 바이오매스 유래 고분자들 중에서도 생분해성, 생체적합성, 구조적 안정성, 그리고 낮은 독성과 같은 뛰어난 물성으로 인해 석유 유래 플라스틱의 대체물로서 대두되고 있다.

그러나, 폴리유산은 현재 두 단계 공정으로 합성된다. 우선, 미생물 발효를 통해 유산(락트산, Lactic acid)을 생산, 정제한 후 여러 가지 시약, 용매 및 촉매가 첨가되는 복잡한 공정의 화학적 중합반응에 의해 폴리유산이 합성된다.

또한, 폴리유산의 물성을 다양하게 개선하기 위해 폴리하이드록시알카노에이트 (Polyhydroxyalkanoate, PHA)와 같은 다른 고분자들과의 공중합이나 혼합반응 등의 연구가 이루어지고 있다.

이러한 노력에도 불구하고, 공중합 반응에 사용되는 락톤계 모노머들의 가용성과 비용을 고려했을 때, 기존의 화학적 합성 방법은 효과적이지 않다. 이에, 미생물 유래 고분자인 폴리하이드록시알카노에이트의 생합성 시스템을 기반으로, 폴리유산과 그의 공중합체들의 생합성이 가능할 수 있는 대사경로를 효소공학을 통해 구축했다.

그러나, 외래 대사경로의 도입 및 조작만으로는 폴리유산 단일 중합체와 유산의 함량이 높은 공중합체의 생산이 효율적이지 않아, 시스템 수준으로 세포 내 대사흐름을 증가시킬 필요성을 인지했다. 이에, 대장균 균주의 인실리코 게놈 수준의 시뮬레이션을 이용한 대사흐름분석 기법을 활용하여 고분자 생산을 위한 주요 전구체의 대사 흐름을 논리적으로 강화시킴으로써, 세포성장과 함께 목적 고분자의 효율적 생산이 가능하도록 했다.

따라서, 효소공학을 통한 고분자 합성 경로의 직접적 조작 및 강화 뿐 아니라, 시스템 대사공학을 통한 논리적 접근으로 조작된 대사흐름을 바탕으로 다양한 폴리유산 플라스틱을 보다 효율적으로 생산할 수 있었다.

이는 시스템 대사공학과 효소공학을 접목시킨 고기술 전략으로 비자연 고분자를 효율적으로 생산한 최초의 성공적인 예로서, 재생가능한 자원으로부터 폴리유산뿐 아니라 석유유래 플라스틱을 대체할 수 있는 다른 비자연 고분자들의 일단계 생산을 위한 기반 기술을 마련해줌으로써, 플라스틱 생산 공정에 있어 새로운 전략을 제시했다.

李 교수는 “자연계에 없는 고분자를 미생물로 생산하는 것이 과연 될까? 라는 의문을 갖고 시작했다. 우리 KAIST 연구실의 정유경박사와 LG화학 기술연구원 연구팀원 10여명이 4년간의 끈질긴 노력 끝에 성공했다”며, “이번 연구는 대장균의 가상세포 시뮬레이션을 통해 세포 내 대사흐름을 목적한 고분자 생산에 유리하도록 논리적으로 조작하고, 고분자 생합성 경로를 구성하는 외래 효소들을 새롭게 만들어 도입함으로써, 강화된 대사흐름을 이용해 보다 효율적으로 목적 고분자를 생산할 수 있는 균주를 개발하는데 성공한 세계 첫 번째 케이스다. 특히, 유산이 단량체로 함유된 공중합체의 경우에는 세계최초로 만든 것이 되어 물질특허들로 출원중이다”라고 밝혔다.

한편, 이 혁신적인 연구 성과는 22일 미국 CNN 홈페이지의 Top기사 등 해외언론의 주요기사로 소개됐다. 주요내용은 한국의 KAIST 이상엽 교수팀과 LG화학 연구팀이 전 세계적으로 석유고갈, 지구온난화 및 환경오염 문제로 재생가능한 자원을 이용한 바이오매스 기반 기술의 개발이 시급한 현 시대의 흐름에 부응하면서, 재생가능한 자원으로부터 효율적으로 바이오공학을 통한 플라스틱 (Bioengineered plastics) 폴리유산의 생산이 가능한 대장균 균주를 개발했다는 내용이다.

대사공학적으로 개량된 박테리아로 범용 플라스틱 생산기술 개발

- 이상엽 교수팀과 LG 화학 연구팀 공동개발

- 바이오테크놀로지 바이오엔지니어링(Biotechnology and Bioengineering)지 게재예정

생명화학공학과 이상엽(李相燁, 45세, LG화학 석좌교수, 생명과학기술대학 학장) 특훈교수팀과 LG화학 기술연구원(원장 유진녕) 박시재, 양택호박사팀이 4년여 간의 공동연구를 통해 박테리아를 이용하여 재생 가능한 바이오매스로부터 플라스틱을 생산하는 기술을 최근 개발했다.

교육과학기술부 시스템생물학 연구개발 사업과 LG화학 석좌교수 연구비로 지원된 이번 연구에서는 시스템 대사공학과 효소공학 기법을 접목, 자연적으로는 생성되지 않는 플라스틱(unnatural polymer)의 일종으로 최근 각광을 받고 있는 폴리유산(Polylactic acid, PLA)을 효율적으로 생산할 수 있는 대장균을 개발한 것이다.

이번 연구 결과는 바이오공학 분야 최고 전통의 바이오테크놀로지 바이오엔지니어링(Biotechnology and Bioengineering)지에 게재 승인됐으며 스포트라이트 논문(Spotlight paper)으로 선정돼 2010년 1월호에 두 편의 연속 논문으로 게재될 예정이다.

두 논문의 제목은 ‘개량된 프로피오네이트 코엔자임 에이 트랜스퍼레이즈와 폴리하이드록시알카노에이트 중합효소를 이용한 폴리유산과 그의 공중합체의 생합성(Biosynthesis of Polylactic acid and its Copolymers Using Evolved Propionate CoA Transferase and PHA Synthase)’과 ‘폴리유산과 그의 공중합체의 생산을 위한 대장균의 대사공학(Metabolic Engineering of Escherichia coli for the Production of Polylactic Acid and its Copolymers)’이다. 19건의 특허가 전 세계 출원 중이다.

기존의 복잡한 2단계 공정을 통해 생산되던 폴리유산을 재생가능한 원료로부터 미생물의 직접 발효에 의해 생산이 가능하도록 한 혁신적인 본 연구 전략은 앞으로 석유 유래 플라스틱을 대체할 수 있는 다양한 비자연 고분자(unnatural polymer)들의 생산에 활용될 획기적인 기술로 평가되고 있다.

폴리유산 (Polylactic acid, PLA)은 많은 바이오매스 유래 고분자들 중에서도 생분해성, 생체적합성, 구조적 안정성, 그리고 낮은 독성과 같은 뛰어난 물성으로 인해 석유 유래 플라스틱의 대체물로서 대두되고 있다.

그러나, 폴리유산은 현재 두 단계 공정으로 합성된다. 우선, 미생물 발효를 통해 유산(락트산, Lactic acid)을 생산, 정제한 후 여러 가지 시약, 용매 및 촉매가 첨가되는 복잡한 공정의 화학적 중합반응에 의해 폴리유산이 합성된다.

또한, 폴리유산의 물성을 다양하게 개선하기 위해 폴리하이드록시알카노에이트 (Polyhydroxyalkanoate, PHA)와 같은 다른 고분자들과의 공중합이나 혼합반응 등의 연구가 이루어지고 있다.

이러한 노력에도 불구하고, 공중합 반응에 사용되는 락톤계 모노머들의 가용성과 비용을 고려했을 때, 기존의 화학적 합성 방법은 효과적이지 않다. 이에, 미생물 유래 고분자인 폴리하이드록시알카노에이트의 생합성 시스템을 기반으로, 폴리유산과 그의 공중합체들의 생합성이 가능할 수 있는 대사경로를 효소공학을 통해 구축했다.

그러나, 외래 대사경로의 도입 및 조작만으로는 폴리유산 단일 중합체와 유산의 함량이 높은 공중합체의 생산이 효율적이지 않아, 시스템 수준으로 세포 내 대사흐름을 증가시킬 필요성을 인지했다. 이에, 대장균 균주의 인실리코 게놈 수준의 시뮬레이션을 이용한 대사흐름분석 기법을 활용하여 고분자 생산을 위한 주요 전구체의 대사 흐름을 논리적으로 강화시킴으로써, 세포성장과 함께 목적 고분자의 효율적 생산이 가능하도록 했다.

따라서, 효소공학을 통한 고분자 합성 경로의 직접적 조작 및 강화 뿐 아니라, 시스템 대사공학을 통한 논리적 접근으로 조작된 대사흐름을 바탕으로 다양한 폴리유산 플라스틱을 보다 효율적으로 생산할 수 있었다.

이는 시스템 대사공학과 효소공학을 접목시킨 고기술 전략으로 비자연 고분자를 효율적으로 생산한 최초의 성공적인 예로서, 재생가능한 자원으로부터 폴리유산뿐 아니라 석유유래 플라스틱을 대체할 수 있는 다른 비자연 고분자들의 일단계 생산을 위한 기반 기술을 마련해줌으로써, 플라스틱 생산 공정에 있어 새로운 전략을 제시했다.

李 교수는 “자연계에 없는 고분자를 미생물로 생산하는 것이 과연 될까? 라는 의문을 갖고 시작했다. 우리 KAIST 연구실의 정유경박사와 LG화학 기술연구원 연구팀원 10여명이 4년간의 끈질긴 노력 끝에 성공했다”며, “이번 연구는 대장균의 가상세포 시뮬레이션을 통해 세포 내 대사흐름을 목적한 고분자 생산에 유리하도록 논리적으로 조작하고, 고분자 생합성 경로를 구성하는 외래 효소들을 새롭게 만들어 도입함으로써, 강화된 대사흐름을 이용해 보다 효율적으로 목적 고분자를 생산할 수 있는 균주를 개발하는데 성공한 세계 첫 번째 케이스다. 특히, 유산이 단량체로 함유된 공중합체의 경우에는 세계최초로 만든 것이 되어 물질특허들로 출원중이다”라고 밝혔다.

한편, 이 혁신적인 연구 성과는 22일 미국 CNN 홈페이지의 Top기사 등 해외언론의 주요기사로 소개됐다. 주요내용은 한국의 KAIST 이상엽 교수팀과 LG화학 연구팀이 전 세계적으로 석유고갈, 지구온난화 및 환경오염 문제로 재생가능한 자원을 이용한 바이오매스 기반 기술의 개발이 시급한 현 시대의 흐름에 부응하면서, 재생가능한 자원으로부터 효율적으로 바이오공학을 통한 플라스틱 (Bioengineered plastics) 폴리유산의 생산이 가능한 대장균 균주를 개발했다는 내용이다.

2009.11.24

조회수 19379

-

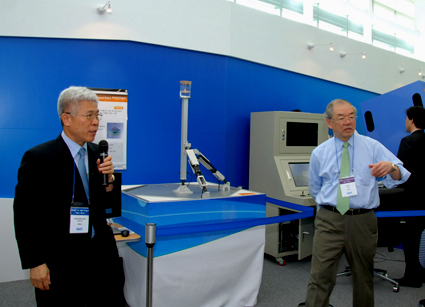

KAIST 서남표 총장, CNN 생방송 출연

- KAIST의 국가 녹색성장 프로젝트인 온라인전기차 CNN 생방송 소개

서남표 총장이 21일 오전 CNN ‘아이 온 사우스 코리아(Eye on South Korea)" 프로그램 생방송에 출연해 KAIST를 소개했다.

이번 CNN의 현장중계는 한국의 IT발전에서 KAIST가 기여한 점과 녹색성장 프로젝트를 진행하고 있는 KAIST의 역할을 높이 평가해 이루어진 것이다.

이날 CNN 간판 앵커 스타우트(Kristie Lu Stout)가 방한해 KAIST 문지캠퍼스에서 생방송을 진행했다.

서총장은 이번 방송에서 국가프로젝트인 온라인전기차(On-Line Electric Vehicle, OLEV)를 소개했다. 서총장은 CNN 간판 앵커 스타우트(Kristie Lu Stout)와의 인터뷰에서 "전 세계 많은 곳에서 다음 세대의 자동차로 전기차를 개발하고 있지만 대부분 하이브리드 자동차나 배터리식 전기차에 집중하고 있다"며 "우리는 그것이 인류의 근본적 문제를 해결하는 방법이 아니라고 생각한다"고 말했다.

또한 이 특집 프로그램을 통해 온라인 전기버스, 전기 승용차와 인간형 로봇인 휴보(HUBO)가 전 세계에 소개됐다.

이번 CNN 한국특집 프로그램은 한국의 경제회복을 초점에 맞춰 19일부터 23일까지 매일 1시간30분 이상 CNN 채널을 통해 전 세계에 24시간 방영된다. CNN은 21일 오전 8시부터 9시30분까지 KAIST 캠퍼스 현장을 중계 방송했다.

KAIST 서남표 총장, CNN 생방송 출연

- KAIST의 국가 녹색성장 프로젝트인 온라인전기차 CNN 생방송 소개

서남표 총장이 21일 오전 CNN ‘아이 온 사우스 코리아(Eye on South Korea)" 프로그램 생방송에 출연해 KAIST를 소개했다.

이번 CNN의 현장중계는 한국의 IT발전에서 KAIST가 기여한 점과 녹색성장 프로젝트를 진행하고 있는 KAIST의 역할을 높이 평가해 이루어진 것이다.

이날 CNN 간판 앵커 스타우트(Kristie Lu Stout)가 방한해 KAIST 문지캠퍼스에서 생방송을 진행했다.

서총장은 이번 방송에서 국가프로젝트인 온라인전기차(On-Line Electric Vehicle, OLEV)를 소개했다. 서총장은 CNN 간판 앵커 스타우트(Kristie Lu Stout)와의 인터뷰에서 "전 세계 많은 곳에서 다음 세대의 자동차로 전기차를 개발하고 있지만 대부분 하이브리드 자동차나 배터리식 전기차에 집중하고 있다"며 "우리는 그것이 인류의 근본적 문제를 해결하는 방법이 아니라고 생각한다"고 말했다.

또한 이 특집 프로그램을 통해 온라인 전기버스, 전기 승용차와 인간형 로봇인 휴보(HUBO)가 전 세계에 소개됐다.

이번 CNN 한국특집 프로그램은 한국의 경제회복을 초점에 맞춰 19일부터 23일까지 매일 1시간30분 이상 CNN 채널을 통해 전 세계에 24시간 방영된다. CNN은 21일 오전 8시부터 9시30분까지 KAIST 캠퍼스 현장을 중계 방송했다.

2009.10.21

조회수 13347

-

서남표 총장, CNN 생방송 출연

- KAIST의 국가 녹색성장 프로젝트인 온라인전기차와 모바일하버 소개

서남표 총장이 오는 21일 CNN ‘아이 온 사우스 코리아(Eye on South Korea)" 프로그램 생방송에 출연해 KAIST를 소개한다.

CNN은 이날 오전 8시부터 9시30분까지 KAIST 캠퍼스 현장을 중계 방송한다. 서총장은 이번 방송에서 국가프로젝트인 온라인전기차(On-Line Electric Vehicle, OLEV)와 모바일하버(Mobile Harbor)등 KAIST의 녹색성장 프로젝트를 이야기 한다.

또한 이 특집 프로그램을 통해 온라인 전기버스와 인간형 로봇인 휴보(HUBO)가 전 세계에 소개 될 예정이다.

우리대학 관계자는 “이번 CNN의 현장중계는 한국의 IT발전에서 KAIST가 기여한 점과 녹색성장 프로젝트를 진행하고 있는 KAIST의 역할을 높이 평가해 이루어진 것”이라고 말했다.

이번 CNN 한국특집 프로그램은 한국의 경제회복을 초점에 맞춰 19일부터 23일까지 매일 1시간30분 이상 CNN 채널을 통해 전 세계에 24시간 방영된다. 이날 CNN 간판 앵커 스타우트(Kristie Lu Stout)가 방한해 KAIST 문지캠퍼스에서 생방송을 진행한다.

서남표 총장, CNN 생방송 출연

- KAIST의 국가 녹색성장 프로젝트인 온라인전기차와 모바일하버 소개

서남표 총장이 오는 21일 CNN ‘아이 온 사우스 코리아(Eye on South Korea)" 프로그램 생방송에 출연해 KAIST를 소개한다.

CNN은 이날 오전 8시부터 9시30분까지 KAIST 캠퍼스 현장을 중계 방송한다. 서총장은 이번 방송에서 국가프로젝트인 온라인전기차(On-Line Electric Vehicle, OLEV)와 모바일하버(Mobile Harbor)등 KAIST의 녹색성장 프로젝트를 이야기 한다.

또한 이 특집 프로그램을 통해 온라인 전기버스와 인간형 로봇인 휴보(HUBO)가 전 세계에 소개 될 예정이다.

우리대학 관계자는 “이번 CNN의 현장중계는 한국의 IT발전에서 KAIST가 기여한 점과 녹색성장 프로젝트를 진행하고 있는 KAIST의 역할을 높이 평가해 이루어진 것”이라고 말했다.

이번 CNN 한국특집 프로그램은 한국의 경제회복을 초점에 맞춰 19일부터 23일까지 매일 1시간30분 이상 CNN 채널을 통해 전 세계에 24시간 방영된다. 이날 CNN 간판 앵커 스타우트(Kristie Lu Stout)가 방한해 KAIST 문지캠퍼스에서 생방송을 진행한다.

2009.10.20

조회수 7037

-

오준호 교수, CNN 특집프로그램 패널리스트로 출연

기계공학과 오준호(吳俊鎬, 51) 교수가 CNN 인터네셔널 특집프로그램인 “인간과 기계의 미래정상회담(Future Summit: Of Man and Machine)”에 패널리스트로 출연했다.

이번 프로그램 주제는 “인간과 기계”로 CNN 종군앵커로 유명한 마이클 홈즈(Michael Holmes)의 진행으로 로봇분야 吳 교수를 비롯, 복제양 돌리를 만든 영국의 알란 콜맨(Allan Colman) 박사, 말라리아 퇴치가 가능한 새로운 생물 알태미시닌(Artemisinin)를 개발한 버클리대 재이 키슬링(Jay Keasling) 교수, 그리고 인류학자인 스위스 로잔대 다니엘라 써퀴(Daniela Cerqui) 교수, 로봇심리학자 조안 프란스키(Joanne Pransky) 여사가 패널로 참여했다.

CNN은 10명의 각계 저명인사로 구성된 자문위원회를 통해 패널을 추천 받아 사전 인터뷰 등을 거쳐 吳 교수를 비롯한 5명의 패널을 선정했다.

吳 교수는 이 방송에서 “미래에는 움직임과 자율성을 갖는 로봇화가 우리 주변 거의 모든 것에 구현될 것이며, 로봇과 가전제품의 벽이 없어질 것이다”라고 예측했다. 특히 이 프로그램에는 吳 교수가 개발한 인간형 로봇인 휴보(HUBO)가 직접 출연, 세계최고 수준의 로봇이라는 소개와 함께 진행자와 오프닝을 진행했다.

“Future Summit”은 CNN 인터네셔널에서 과학기술이 미래사회에 미칠 영향에 대해 서로 다른 분야의 인사를 초빙하여 조명하는 특집 프로그램이다. 이번이 첫 방송인 이 프로그램은 7회에 걸쳐 우리나라를 포함한 전 세계 200여개국(미국 제외)의 CNN케이블 방송망을 통해 방송된다.

* 첨부: ① 오준호 교수 사진 1매, ② 휴보 사진 2매 ③ 한국 방송시간

<한국 방송시간>

6월 15일(목) 23:00

6월 16일(금) 06:00

6월 17일(토) 15:00, 23:00

6월 18일(일) 04:00, 15:00

6월 19일(월) 04:00

----------------------------------------------------------------------------------------------------------

CNN은 CNN International(CNNi), CNN USA, CNN 스페인어 등으로 구성되어 있으며 CNN USA 는 주로 미국 내 뉴스를 다루고 미국에서만 방영되며, CNNi 는 국제뉴스전문 채널로서 미국을 제외한 전 세계 200여개국으로 방송된다. 한국에서 시청하는 CNN은 CNN international 이다.

오준호 교수, CNN 특집프로그램 패널리스트로 출연

기계공학과 오준호(吳俊鎬, 51) 교수가 CNN 인터네셔널 특집프로그램인 “인간과 기계의 미래정상회담(Future Summit: Of Man and Machine)”에 패널리스트로 출연했다.

이번 프로그램 주제는 “인간과 기계”로 CNN 종군앵커로 유명한 마이클 홈즈(Michael Holmes)의 진행으로 로봇분야 吳 교수를 비롯, 복제양 돌리를 만든 영국의 알란 콜맨(Allan Colman) 박사, 말라리아 퇴치가 가능한 새로운 생물 알태미시닌(Artemisinin)를 개발한 버클리대 재이 키슬링(Jay Keasling) 교수, 그리고 인류학자인 스위스 로잔대 다니엘라 써퀴(Daniela Cerqui) 교수, 로봇심리학자 조안 프란스키(Joanne Pransky) 여사가 패널로 참여했다.

CNN은 10명의 각계 저명인사로 구성된 자문위원회를 통해 패널을 추천 받아 사전 인터뷰 등을 거쳐 吳 교수를 비롯한 5명의 패널을 선정했다.

吳 교수는 이 방송에서 “미래에는 움직임과 자율성을 갖는 로봇화가 우리 주변 거의 모든 것에 구현될 것이며, 로봇과 가전제품의 벽이 없어질 것이다”라고 예측했다. 특히 이 프로그램에는 吳 교수가 개발한 인간형 로봇인 휴보(HUBO)가 직접 출연, 세계최고 수준의 로봇이라는 소개와 함께 진행자와 오프닝을 진행했다.

“Future Summit”은 CNN 인터네셔널에서 과학기술이 미래사회에 미칠 영향에 대해 서로 다른 분야의 인사를 초빙하여 조명하는 특집 프로그램이다. 이번이 첫 방송인 이 프로그램은 7회에 걸쳐 우리나라를 포함한 전 세계 200여개국(미국 제외)의 CNN케이블 방송망을 통해 방송된다.

* 첨부: ① 오준호 교수 사진 1매, ② 휴보 사진 2매 ③ 한국 방송시간

<한국 방송시간>

6월 15일(목) 23:00

6월 16일(금) 06:00

6월 17일(토) 15:00, 23:00

6월 18일(일) 04:00, 15:00

6월 19일(월) 04:00

----------------------------------------------------------------------------------------------------------

CNN은 CNN International(CNNi), CNN USA, CNN 스페인어 등으로 구성되어 있으며 CNN USA 는 주로 미국 내 뉴스를 다루고 미국에서만 방영되며, CNNi 는 국제뉴스전문 채널로서 미국을 제외한 전 세계 200여개국으로 방송된다. 한국에서 시청하는 CNN은 CNN international 이다.

2006.06.16

조회수 13429

예종철 교수, 국제 응용 역문제 학회 기조강연

〈 예종철 교수 〉

우리 대학 바이오및뇌공학과 예종철 교수가 응용 수학분야 대표 학회 중 하나인 국제 응용 역문제 학회(Applied Inverse Problems Conference)에서 기조연설자로 선정돼 강연을 진행했다.

예 교수는 7월 11일 프랑스 그랑노블에서 열린 제10회 AIP 학회에서 세계 각국의 응용수학자 8백여 명을 대상으로 ‘역문제를 위한 인공지능 네트워크의 기하학적인 구조의 이해(Understanding Geometry of Encoder-Decoder CNN for Inverse Problems)’라는 주제로 영상처리 및 역문제에 사용되는 인공지능기술의 현황을 소개하고, 예 교수가 개척해 온 인공지능망의 기하학적인 구조에 대한 최신 이론을 발표했다.

예 교수는 의료 영상 복원 등 다양한 역문제에 적용되는 인공지능 기술을 개척하고, 이것이 동작하는 원리에 대한 기하학적인 구조를 밝히는 등 역문제 분야 인공지능 기술을 주도하는 점을 인정받아 이번 기조연설자로 선정됐다.

예 교수는 기조연설을 통해 “인공지능기술은 블랙박스가 아니라 조합적인 표현되는 최적화된 기저함수로서 이해할 수 있으며, 인공지능은 기존의 조화분석론(harmonic analysis)의 지평을 확대할 수 있는 새로운 수학 분야로 떠오르고 있다”라고 말했다.

또한 “인공지능은 기존의 질병 진단을 뛰어넘어 의사들의 진료를 더 정확하게 도우며 환자의 편의를 극대화할 수 있는 고화질, 저선량, 고속 촬영 기술을 가능하게 한 핵심기술로 떠오르고 있으므로 많은 연구가 필요하다”라고 인공지능 기술이 나아가야 할 미래방향을 제시했다.

2019.07.25 조회수 8261

예종철 교수, 국제 응용 역문제 학회 기조강연

〈 예종철 교수 〉

우리 대학 바이오및뇌공학과 예종철 교수가 응용 수학분야 대표 학회 중 하나인 국제 응용 역문제 학회(Applied Inverse Problems Conference)에서 기조연설자로 선정돼 강연을 진행했다.

예 교수는 7월 11일 프랑스 그랑노블에서 열린 제10회 AIP 학회에서 세계 각국의 응용수학자 8백여 명을 대상으로 ‘역문제를 위한 인공지능 네트워크의 기하학적인 구조의 이해(Understanding Geometry of Encoder-Decoder CNN for Inverse Problems)’라는 주제로 영상처리 및 역문제에 사용되는 인공지능기술의 현황을 소개하고, 예 교수가 개척해 온 인공지능망의 기하학적인 구조에 대한 최신 이론을 발표했다.

예 교수는 의료 영상 복원 등 다양한 역문제에 적용되는 인공지능 기술을 개척하고, 이것이 동작하는 원리에 대한 기하학적인 구조를 밝히는 등 역문제 분야 인공지능 기술을 주도하는 점을 인정받아 이번 기조연설자로 선정됐다.

예 교수는 기조연설을 통해 “인공지능기술은 블랙박스가 아니라 조합적인 표현되는 최적화된 기저함수로서 이해할 수 있으며, 인공지능은 기존의 조화분석론(harmonic analysis)의 지평을 확대할 수 있는 새로운 수학 분야로 떠오르고 있다”라고 말했다.

또한 “인공지능은 기존의 질병 진단을 뛰어넘어 의사들의 진료를 더 정확하게 도우며 환자의 편의를 극대화할 수 있는 고화질, 저선량, 고속 촬영 기술을 가능하게 한 핵심기술로 떠오르고 있으므로 많은 연구가 필요하다”라고 인공지능 기술이 나아가야 할 미래방향을 제시했다.

2019.07.25 조회수 8261 한동수, 신진우 교수, 느린 인터넷 환경에서도 고화질 영상 감상 기술 개발

〈 (왼쪽부터) 김재홍, 정영목 석사과정, 여현호 박사과정, 한동수, 신진우 교수 〉

우리 대학 전기및전자공학부 신진우, 한동수 교수 연구팀이 딥러닝 기술을 이용한 인터넷 비디오 전송 기술을 개발했다.

여현호, 정영목, 김재홍 학생이 주도한 이번 연구 결과는 격년으로 개최되는 컴퓨터 시스템 분야의 유명 학술회의인 ‘유즈닉스 OSDI(USENIX OSDI)’에서 10월 10일 발표됐고 현재 국제 특허 출원을 완료했다.

이 기술은 유튜브, 넷플릭스 등에서 비디오를 사용자에게 전송할 때 사용하는 적응형 스트리밍(HTTP adaptive streaming) 비디오 전송기술과 딥러닝 기술인 심층 콘볼루션 신경망(CNN) 기반의 초해상화를 접목한 새로운 방식이다.

이는 열악한 인터넷 환경에서도 고품질, 고화질(HD)의 비디오 시청이 가능할 뿐 아니라 4K, AV/VR 등을 시청할 수 있는 새로운 기반 기술이 될 것으로 기대된다.

기존의 적응형 스트리밍은 시시각각 변화하는 인터넷 대역폭에 맞춰 스트리밍 중인 비디오 화질을 실시간으로 조절한다. 이를 위해 다양한 알고리즘이 연구되고 있으나 네트워크 환경이 좋지 않을 때는 어느 알고리즘이라도 고화질의 비디오를 감상할 수 없다는 한계가 있다.

연구팀은 적응형 스트리밍에 초해상화를 접목해 인터넷 대역폭에 의존하는 기존 적응형 스트리밍의 한계를 극복했다. 기존 기술은 비디오를 시청 시 긴 영상을 짧은 시간의 여러 비디오 조각으로 나눠 다운받는다. 이를 위해 비디오를 제공하는 서버에서는 비디오를 미리 일정 시간 길이로 나눠 준비해놓는 방식이다.

연구팀이 새롭게 개발한 시스템은 추가로 신경망 조각을 비디오 조각과 같이 다운받게 했다. 이를 위해 비디오 서버에서는 각 비디오에 대해 학습이 된 신경망을 제공하며 또 사용자 컴퓨터의 사양을 고려해 다양한 크기의 신경망을 제공한다.

제일 큰 신경망의 크기는 총 2메가바이트(MB)이며 비디오에 비해 상당히 작은 크기이다. 신경망을 사용자 비디오 플레이어에서 다운받을 때는 여러 개의 조각으로 나눠 다운받으며 신경망의 일부만 다운받아도 조금 떨어지는 성능의 초해상화 기술을 이용할 수 있도록 설계했다.

사용자의 컴퓨터에서는 동영상 시청과 함께 병렬적으로 심층 콘볼루션 신경망(CNN) 기반의 초해상화 기술을 사용해 비디오 플레이어 버퍼에 저장된 저화질 비디오를 고화질로 바꾸게 된다. 모든 과정은 실시간으로 이뤄지며 이를 통해 사용자들이 고화질의 비디오를 시청할 수 있다.

연구팀이 개발한 시스템을 이용하면 최대 26.9%의 적은 인터넷 대역폭으로도 최신 적응형 스트리밍과 같은 체감 품질(QoE, Quality of Experience)을 제공할 수 있다. 또한 같은 인터넷 대역폭이 주어진 경우에는 최신 적응형 스트리밍보다 평균 40% 높은 체감 품질을 제공할 수 있다.

이 시스템은 딥러닝 방식을 이용해 기존의 비디오 압축 방식보다 더 많은 압축을 이뤄낸 것으로 볼 수 있다. 연구팀의 기술은 콘볼루션 신경망 기반의 초해상화를 인터넷 비디오에 적용한 차세대 인터넷 비디오 시스템으로 권위 잇는 학회로부터 효용성을 인정받았다.

한 교수는 “지금은 데스크톱에서만 구현했지만 향후 모바일 기기에서도 작동하도록 발전시킬 예정이다”며 “이 기술은 현재 유튜브, 넷플릭스 등 스트리밍 기업에서 사용하는 비디오 전송 시스템에 적용한 것으로 실용성에 큰 의의가 있다”고 말했다.

이번 연구는 과학기술정보통신부 정보통신기술진흥센터(IITP) 방송통신연구개발 사업의 지원을 받아 수행됐다.

비디오 자료 링크 주소 1.

https://www.dropbox.com/sh/z2hvw1iv1459698/AADk3NB5EBgDhv3J4aiZo9nta?dl=0&lst =

□ 그림 설명

그림1. 기술이 적용되기 전 화질(좌)과 적용된 후 화질 비교(우)

그림2. 기술 개념도

그림3. 비디오 서버로부터 비디오가 전송된 후 저화질의 비디오가 고화질의 비디오로 변환되는 과정

2018.10.30 조회수 9093

한동수, 신진우 교수, 느린 인터넷 환경에서도 고화질 영상 감상 기술 개발

〈 (왼쪽부터) 김재홍, 정영목 석사과정, 여현호 박사과정, 한동수, 신진우 교수 〉

우리 대학 전기및전자공학부 신진우, 한동수 교수 연구팀이 딥러닝 기술을 이용한 인터넷 비디오 전송 기술을 개발했다.

여현호, 정영목, 김재홍 학생이 주도한 이번 연구 결과는 격년으로 개최되는 컴퓨터 시스템 분야의 유명 학술회의인 ‘유즈닉스 OSDI(USENIX OSDI)’에서 10월 10일 발표됐고 현재 국제 특허 출원을 완료했다.

이 기술은 유튜브, 넷플릭스 등에서 비디오를 사용자에게 전송할 때 사용하는 적응형 스트리밍(HTTP adaptive streaming) 비디오 전송기술과 딥러닝 기술인 심층 콘볼루션 신경망(CNN) 기반의 초해상화를 접목한 새로운 방식이다.

이는 열악한 인터넷 환경에서도 고품질, 고화질(HD)의 비디오 시청이 가능할 뿐 아니라 4K, AV/VR 등을 시청할 수 있는 새로운 기반 기술이 될 것으로 기대된다.

기존의 적응형 스트리밍은 시시각각 변화하는 인터넷 대역폭에 맞춰 스트리밍 중인 비디오 화질을 실시간으로 조절한다. 이를 위해 다양한 알고리즘이 연구되고 있으나 네트워크 환경이 좋지 않을 때는 어느 알고리즘이라도 고화질의 비디오를 감상할 수 없다는 한계가 있다.

연구팀은 적응형 스트리밍에 초해상화를 접목해 인터넷 대역폭에 의존하는 기존 적응형 스트리밍의 한계를 극복했다. 기존 기술은 비디오를 시청 시 긴 영상을 짧은 시간의 여러 비디오 조각으로 나눠 다운받는다. 이를 위해 비디오를 제공하는 서버에서는 비디오를 미리 일정 시간 길이로 나눠 준비해놓는 방식이다.

연구팀이 새롭게 개발한 시스템은 추가로 신경망 조각을 비디오 조각과 같이 다운받게 했다. 이를 위해 비디오 서버에서는 각 비디오에 대해 학습이 된 신경망을 제공하며 또 사용자 컴퓨터의 사양을 고려해 다양한 크기의 신경망을 제공한다.

제일 큰 신경망의 크기는 총 2메가바이트(MB)이며 비디오에 비해 상당히 작은 크기이다. 신경망을 사용자 비디오 플레이어에서 다운받을 때는 여러 개의 조각으로 나눠 다운받으며 신경망의 일부만 다운받아도 조금 떨어지는 성능의 초해상화 기술을 이용할 수 있도록 설계했다.

사용자의 컴퓨터에서는 동영상 시청과 함께 병렬적으로 심층 콘볼루션 신경망(CNN) 기반의 초해상화 기술을 사용해 비디오 플레이어 버퍼에 저장된 저화질 비디오를 고화질로 바꾸게 된다. 모든 과정은 실시간으로 이뤄지며 이를 통해 사용자들이 고화질의 비디오를 시청할 수 있다.

연구팀이 개발한 시스템을 이용하면 최대 26.9%의 적은 인터넷 대역폭으로도 최신 적응형 스트리밍과 같은 체감 품질(QoE, Quality of Experience)을 제공할 수 있다. 또한 같은 인터넷 대역폭이 주어진 경우에는 최신 적응형 스트리밍보다 평균 40% 높은 체감 품질을 제공할 수 있다.

이 시스템은 딥러닝 방식을 이용해 기존의 비디오 압축 방식보다 더 많은 압축을 이뤄낸 것으로 볼 수 있다. 연구팀의 기술은 콘볼루션 신경망 기반의 초해상화를 인터넷 비디오에 적용한 차세대 인터넷 비디오 시스템으로 권위 잇는 학회로부터 효용성을 인정받았다.

한 교수는 “지금은 데스크톱에서만 구현했지만 향후 모바일 기기에서도 작동하도록 발전시킬 예정이다”며 “이 기술은 현재 유튜브, 넷플릭스 등 스트리밍 기업에서 사용하는 비디오 전송 시스템에 적용한 것으로 실용성에 큰 의의가 있다”고 말했다.

이번 연구는 과학기술정보통신부 정보통신기술진흥센터(IITP) 방송통신연구개발 사업의 지원을 받아 수행됐다.

비디오 자료 링크 주소 1.

https://www.dropbox.com/sh/z2hvw1iv1459698/AADk3NB5EBgDhv3J4aiZo9nta?dl=0&lst =

□ 그림 설명

그림1. 기술이 적용되기 전 화질(좌)과 적용된 후 화질 비교(우)

그림2. 기술 개념도

그림3. 비디오 서버로부터 비디오가 전송된 후 저화질의 비디오가 고화질의 비디오로 변환되는 과정

2018.10.30 조회수 9093 유회준 교수, 딥러닝용 AI 반도체 개발

우리대학 전기및전자공학부 유회준 교수 연구팀이 스타트업 '유엑스 팩토리'와 함께 가변 인공신경망 기술을 적용해 딥러닝을 효율적으로 처리하는 AI 반도체를 개발했다. 딥러닝이란 컴퓨터가 마치 사람처럼 스스로 학습할 수 있도록 인공신경망을 기반으로 구축한 '기계 학습' 기술이다.

유 교수 연구팀이 개발한 새로운 칩은 반도체 안에서 인공신경망의 무게 정밀도를 조절함으로써 에너지 효율과 정확도를 조절한다. 1비트부터 16비트까지 소프트웨어로 간편하게 조절하면서 상황에 맞춰 최적화된 동작을 얻어낸다. 하나의 칩이지만 '콘볼루션 신경망'(CNN)과 '재귀 신경망'(RNN)을 동시에 처리할 수 있다. CNN은 이미지를 분류나 탐지하는 데 쓰이며, RNN은 주로 시간의 흐름에 따라 변화하는 영상과 음성 등 데이터 학습에 적합하다. 또 통합 신경망 프로세서(UNPU)를 통해 인식 대상에 따라 에너지효율과 정확도를 다르게 설정하는 것도 가능하다.

모바일에서 AI 기술을 구현하려면 고속 연산을 '저전력'으로 처리해야 한다. 그렇지 않으면 한꺼번에 많은 정보를 처리하면서 발생하는 발열로 인해 배터리 폭발 등의 사고가 일어날 수 있기 때문이다. 연구팀에 따르면 이번 칩은 세계 최고 수준 모바일용 AI 칩 대비 CNN과 RNN 연산 성능이 각각 1.15배, 13.8배이 달한다. 에너지효율도 40% 높은 것으로 나타났다.

스마트폰 카메라를 통해 사람의 얼굴 표정을 인식해 행복, 슬픔, 놀람, 공포, 무표정 등 7가지의 감정을 자동으로 인식하는 감정인식 시스템도 개발됐다. 이 시스템은 감정 상태를 스마트폰 상에 실시간으로 표시한다. 유 교수 연구팀의 이번 연구는 지난 13일 미국 샌프란시스코에서 열린 국제고체회로설계학회(ISSCC)에서 발표됐다.

유회준 교수는 "기술 상용화에는 1년 정도 더 걸릴 전망"이라며 " 모바일에서 AI를 구현하기 위해 저전력으로 가속하는 반도체를 개발했으며, 향후 물체인식, 감정인식, 동작인식, 자동 번역 등 다양하게 응용될 것으로 기대된다"고 설명했다.

2018.02.26 조회수 12335

유회준 교수, 딥러닝용 AI 반도체 개발

우리대학 전기및전자공학부 유회준 교수 연구팀이 스타트업 '유엑스 팩토리'와 함께 가변 인공신경망 기술을 적용해 딥러닝을 효율적으로 처리하는 AI 반도체를 개발했다. 딥러닝이란 컴퓨터가 마치 사람처럼 스스로 학습할 수 있도록 인공신경망을 기반으로 구축한 '기계 학습' 기술이다.

유 교수 연구팀이 개발한 새로운 칩은 반도체 안에서 인공신경망의 무게 정밀도를 조절함으로써 에너지 효율과 정확도를 조절한다. 1비트부터 16비트까지 소프트웨어로 간편하게 조절하면서 상황에 맞춰 최적화된 동작을 얻어낸다. 하나의 칩이지만 '콘볼루션 신경망'(CNN)과 '재귀 신경망'(RNN)을 동시에 처리할 수 있다. CNN은 이미지를 분류나 탐지하는 데 쓰이며, RNN은 주로 시간의 흐름에 따라 변화하는 영상과 음성 등 데이터 학습에 적합하다. 또 통합 신경망 프로세서(UNPU)를 통해 인식 대상에 따라 에너지효율과 정확도를 다르게 설정하는 것도 가능하다.

모바일에서 AI 기술을 구현하려면 고속 연산을 '저전력'으로 처리해야 한다. 그렇지 않으면 한꺼번에 많은 정보를 처리하면서 발생하는 발열로 인해 배터리 폭발 등의 사고가 일어날 수 있기 때문이다. 연구팀에 따르면 이번 칩은 세계 최고 수준 모바일용 AI 칩 대비 CNN과 RNN 연산 성능이 각각 1.15배, 13.8배이 달한다. 에너지효율도 40% 높은 것으로 나타났다.

스마트폰 카메라를 통해 사람의 얼굴 표정을 인식해 행복, 슬픔, 놀람, 공포, 무표정 등 7가지의 감정을 자동으로 인식하는 감정인식 시스템도 개발됐다. 이 시스템은 감정 상태를 스마트폰 상에 실시간으로 표시한다. 유 교수 연구팀의 이번 연구는 지난 13일 미국 샌프란시스코에서 열린 국제고체회로설계학회(ISSCC)에서 발표됐다.

유회준 교수는 "기술 상용화에는 1년 정도 더 걸릴 전망"이라며 " 모바일에서 AI를 구현하기 위해 저전력으로 가속하는 반도체를 개발했으며, 향후 물체인식, 감정인식, 동작인식, 자동 번역 등 다양하게 응용될 것으로 기대된다"고 설명했다.

2018.02.26 조회수 12335 김문철 교수, 인공지능 통해 풀HD영상 4K UHD로 실시간 변환

〈 김 문 철 교수 〉

우리 대학 전기및전자공학부 김문철 교수 연구팀이 딥러닝 기술을 이용해 풀 HD 비디오 영상을 4K UHD 초고화질 영상으로 초해상화 변환할 수 있는 기술을 개발했다.

이 기술은 인공지능의 핵심 기술인 심층 콘볼루션 신경망(Deep Convolutional Neural Network, DCNN)을 하드웨어로 구현했다. 초당 60프레임의 초고해상도 4K UHD 화면을 실시간으로 생성할 수 있는 알고리즘 및 하드웨어 개발을 통해 향후 프리미엄 UHD TV, 360 VR, 4K IPTV 등에 기여할 것으로 기대된다.

이번 연구는 KAIST 전기및전자공학부 김용우, 최재석 박사과정 등이 주도했고 현재 특허 출원을 준비 중이다.

최근 영상 화질 개선 연구에 인공지능의 핵심 기술인 심층 콘볼루션 신경망을 적용시키려는 노력이 활발히 이뤄지고 있다. 그러나 이러한 심층 콘볼루션 신경망 기술은 연산 복잡도와 매우 높고 사용되는 메모리가 커 작은 규모의 하드웨어를 통해 초고해상도 영상으로 실시간 변환하는 데 한계가 있다.

기존의 프레임 단위로 영상을 처리하던 방식은 DRAM과 같은 외부 메모리 사용이 필수적인데 이로 인해 영상 데이터를 처리할 때 지나친 외부 메모리 접근으로 인한 메모리 병목현상과 전력 소모 현상이 발생했다.

김 교수 연구팀은 프레임 단위 대신 라인 단위로 데이터를 처리할 수 있는 효율적인 심층 콘볼루션 신경망 구조를 개발해 외부 메모리를 사용하지 않고도 작은 규모의 하드웨어에서 초당 60 프레임의 4K UHD 초해상화를 구현했다.

연구팀은 기존 소프트웨어 방식의 심층 콘볼루션 신경망 기반의 고속 알고리즘과 비교해 필터 파라미터를 65% 정도만 적용하고도 유사한 화질을 유지했다.

이는 딥러닝 기술을 이용한 고해상도 영상 변환 기술이 활발히 진행되는 가운데 초당 60프레임의 4K UHD 초해상화를 하드웨어로 실현한 첫 사례로 꼽힌다.

김 교수는 “이번 연구는 심층 콘볼루션 신경망이 작은 규모의 하드웨어에서 초고품질 영상 처리에 실질적으로 응요 가능한 기술임을 보인 매우 중요한 사례다”며 “현재 프리미엄 UHD TV 및 UHD 방송 콘텐츠 생성, 360도 VR 콘텐츠, 4K IPTV 서비스에 매우 효과적으로 적용할 수 있다”고 말했다.

이번 연구는 과학기술정보통신부 정보통신기술진흥센터(IITP) ICT 기초연구실지원사업의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 실시간 AI(딥러닝) 기반 고속 초고해상도 업스케일링 기술

그림2.심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 (FPGA)

그림3. 심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 시연

2018.01.16 조회수 14382

김문철 교수, 인공지능 통해 풀HD영상 4K UHD로 실시간 변환

〈 김 문 철 교수 〉

우리 대학 전기및전자공학부 김문철 교수 연구팀이 딥러닝 기술을 이용해 풀 HD 비디오 영상을 4K UHD 초고화질 영상으로 초해상화 변환할 수 있는 기술을 개발했다.

이 기술은 인공지능의 핵심 기술인 심층 콘볼루션 신경망(Deep Convolutional Neural Network, DCNN)을 하드웨어로 구현했다. 초당 60프레임의 초고해상도 4K UHD 화면을 실시간으로 생성할 수 있는 알고리즘 및 하드웨어 개발을 통해 향후 프리미엄 UHD TV, 360 VR, 4K IPTV 등에 기여할 것으로 기대된다.

이번 연구는 KAIST 전기및전자공학부 김용우, 최재석 박사과정 등이 주도했고 현재 특허 출원을 준비 중이다.

최근 영상 화질 개선 연구에 인공지능의 핵심 기술인 심층 콘볼루션 신경망을 적용시키려는 노력이 활발히 이뤄지고 있다. 그러나 이러한 심층 콘볼루션 신경망 기술은 연산 복잡도와 매우 높고 사용되는 메모리가 커 작은 규모의 하드웨어를 통해 초고해상도 영상으로 실시간 변환하는 데 한계가 있다.

기존의 프레임 단위로 영상을 처리하던 방식은 DRAM과 같은 외부 메모리 사용이 필수적인데 이로 인해 영상 데이터를 처리할 때 지나친 외부 메모리 접근으로 인한 메모리 병목현상과 전력 소모 현상이 발생했다.

김 교수 연구팀은 프레임 단위 대신 라인 단위로 데이터를 처리할 수 있는 효율적인 심층 콘볼루션 신경망 구조를 개발해 외부 메모리를 사용하지 않고도 작은 규모의 하드웨어에서 초당 60 프레임의 4K UHD 초해상화를 구현했다.

연구팀은 기존 소프트웨어 방식의 심층 콘볼루션 신경망 기반의 고속 알고리즘과 비교해 필터 파라미터를 65% 정도만 적용하고도 유사한 화질을 유지했다.

이는 딥러닝 기술을 이용한 고해상도 영상 변환 기술이 활발히 진행되는 가운데 초당 60프레임의 4K UHD 초해상화를 하드웨어로 실현한 첫 사례로 꼽힌다.

김 교수는 “이번 연구는 심층 콘볼루션 신경망이 작은 규모의 하드웨어에서 초고품질 영상 처리에 실질적으로 응요 가능한 기술임을 보인 매우 중요한 사례다”며 “현재 프리미엄 UHD TV 및 UHD 방송 콘텐츠 생성, 360도 VR 콘텐츠, 4K IPTV 서비스에 매우 효과적으로 적용할 수 있다”고 말했다.

이번 연구는 과학기술정보통신부 정보통신기술진흥센터(IITP) ICT 기초연구실지원사업의 지원을 받아 수행됐다.

□ 그림 설명

그림1. 실시간 AI(딥러닝) 기반 고속 초고해상도 업스케일링 기술

그림2.심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 (FPGA)

그림3. 심층 신경망 AI 기반 4K UHD 60fps 실시간 초해상화 하드웨어 시연

2018.01.16 조회수 14382 유회준 교수, 인공지능 얼굴인식 시스템 K-EYE 개발

우리 대학 전기및전자공학과 유회준 교수 연구팀이 딥러닝 알고리즘을 세계 최소 전력으로 구현하는 인공지능 반도체 칩 CNNP를 개발했다. 그리고 이를 내장한 얼굴인식 시스템 K-Eye 시리즈를 개발했다.

연구팀이 개발한 K-Eye 시리즈는 웨어러블 디바이스와 동글 타입 2가지로 구성된다. 웨어러블 타입인 K-Eye는 블루투스로 스마트폰과 연동 가능하다.

봉경렬 박사과정이 주도하고 ㈜유엑스팩토리(대표 박준영)과 공동으로 개발한 이번 연구는 지난 2월 미국에서 열린 국제고체회로설계학회(ISSCC)에서 세계 최저전력 CNN칩으로 발표돼 주목을 받았다.

최근 글로벌 IT 기업들이 알파고를 비롯한 인공지능 관련 기술들을 경쟁적으로 발표하고 있다. 그러나 대부분은 소프트웨어 기술이라 속도가 느리고 모바일 환경에서는 구현이 어렵다는 한계가 있다.

따라서 이를 고속 및 저전력으로 구동하기 위해 인공지능 반도체 칩 개발이 필수적이다.

연구팀의 K-Eye 시리즈는 1mW 내외의 적은 전력만으로도 항상 얼굴 인식을 수행하는 상태를 유지하면서 사람의 얼굴을 먼저 알아보고 반응할 수 있다는 특징을 갖는다.

K-Eye의 핵심 기술인 얼웨이즈 온(Always-On) 이미지 센서와 CNNP라는 얼굴 인식 처리 칩이 있었기 때문에 위와 같은 세계 최저전력 기술이 가능했다.

첫 번째 칩인 얼웨이즈 온(Always-On) 이미지 센서는 얼굴이 있는지 없는지 스스로 판단할 수 있어 얼굴 인식이 될 때에만 작동하게 해 대기 전력을 대폭 낮출 수 있다.

얼굴 검출 이미지 센서는 아날로그 프로세싱으로 디지털 프로세싱을 제어해 센서 자체의 출력 소모를 줄였다. 픽셀과 결합된 아날로그 프로세서는 배경 부분과 얼굴 부분을 구분하는 역할을 하고 디지털 프로세서는 선택된 일부 영역에서만 얼굴 검출을 수행하면 돼 효율적인 작업이 가능하다.

두 번째 칩인 CNNP는 딥러닝을 회로, 구조, 알고리즘 전반에 도입하고 재해석을 진행해 최저 수준의 전력을 구현하는 역할을 했다.

특히 CNNP칩은 3가지의 핵심 기술을 사용했는데 ▲알파고 인공지능 알고리즘에서 사용하는 2차원 계산을 1차원 계산으로 바꿔 고속 저전력화 ▲분산형으로 배치된 칩 내 메모리가 가로방향 뿐 아니라 세로방향도 읽어낼 수 있는 특수 저전력 분산 메모리로의 설계 ▲1024개의 곱셈기와 덧셈기가 동시에 구동돼 막강한 계산력을 가지면서 외부 통신망을 거치지 않고 직접 계산 결과를 주고받을 수 있게 한 점이다.

CNNP는 97%의 인식률을 가지면서도 알파고에 사용된 GPU에 비해 5천분의 1정도의 낮은 전력인 0.6mW만을 소모한다.

K-Eye를 목에 건 사용자는 앞에서 다가오는 상대방의 얼굴이 화면에 떠오르면 미리 저장된 정보와 실시간으로 찍힌 사진을 비교해 상대방의 이름 등 정보를 자연스럽게 확인할 수 있다.

동글 타입인 K-EyeQ는 스마트폰에 장착해 이용할 수 있는데 사용자를 알아보고 반응하는 기능을 한다. 미리 기억시킨 사용자의 얼굴이 화면을 향하기만 하면 스마트폰 화면이 저절로 켜지면서 그와 관련된 정보를 제공한다.

또한 입력된 얼굴이 사진인지 실제 사람인지도 구분할 수 있어 사용자의 얼굴 대신 사진을 보여주면 스마트폰은 반응하지 않는다.

유 교수는 “인공지능 반도체 프로세서가 4차 산업혁명시대를 주도할 것으로 기대된다”며 “이번 인공지능 칩과 인식기의 개발로 인해 세계시장에서 한국이 인공지능 산업의 주도권을 갖길 기대한다”고 말했다.

□ 사진 설명.

사진1. K-EYE 사진

사진2. K-EYEQ 사진

사진3. CNNP 칩 사진

2017.06.14 조회수 13033

유회준 교수, 인공지능 얼굴인식 시스템 K-EYE 개발

우리 대학 전기및전자공학과 유회준 교수 연구팀이 딥러닝 알고리즘을 세계 최소 전력으로 구현하는 인공지능 반도체 칩 CNNP를 개발했다. 그리고 이를 내장한 얼굴인식 시스템 K-Eye 시리즈를 개발했다.

연구팀이 개발한 K-Eye 시리즈는 웨어러블 디바이스와 동글 타입 2가지로 구성된다. 웨어러블 타입인 K-Eye는 블루투스로 스마트폰과 연동 가능하다.

봉경렬 박사과정이 주도하고 ㈜유엑스팩토리(대표 박준영)과 공동으로 개발한 이번 연구는 지난 2월 미국에서 열린 국제고체회로설계학회(ISSCC)에서 세계 최저전력 CNN칩으로 발표돼 주목을 받았다.

최근 글로벌 IT 기업들이 알파고를 비롯한 인공지능 관련 기술들을 경쟁적으로 발표하고 있다. 그러나 대부분은 소프트웨어 기술이라 속도가 느리고 모바일 환경에서는 구현이 어렵다는 한계가 있다.

따라서 이를 고속 및 저전력으로 구동하기 위해 인공지능 반도체 칩 개발이 필수적이다.

연구팀의 K-Eye 시리즈는 1mW 내외의 적은 전력만으로도 항상 얼굴 인식을 수행하는 상태를 유지하면서 사람의 얼굴을 먼저 알아보고 반응할 수 있다는 특징을 갖는다.

K-Eye의 핵심 기술인 얼웨이즈 온(Always-On) 이미지 센서와 CNNP라는 얼굴 인식 처리 칩이 있었기 때문에 위와 같은 세계 최저전력 기술이 가능했다.

첫 번째 칩인 얼웨이즈 온(Always-On) 이미지 센서는 얼굴이 있는지 없는지 스스로 판단할 수 있어 얼굴 인식이 될 때에만 작동하게 해 대기 전력을 대폭 낮출 수 있다.

얼굴 검출 이미지 센서는 아날로그 프로세싱으로 디지털 프로세싱을 제어해 센서 자체의 출력 소모를 줄였다. 픽셀과 결합된 아날로그 프로세서는 배경 부분과 얼굴 부분을 구분하는 역할을 하고 디지털 프로세서는 선택된 일부 영역에서만 얼굴 검출을 수행하면 돼 효율적인 작업이 가능하다.

두 번째 칩인 CNNP는 딥러닝을 회로, 구조, 알고리즘 전반에 도입하고 재해석을 진행해 최저 수준의 전력을 구현하는 역할을 했다.

특히 CNNP칩은 3가지의 핵심 기술을 사용했는데 ▲알파고 인공지능 알고리즘에서 사용하는 2차원 계산을 1차원 계산으로 바꿔 고속 저전력화 ▲분산형으로 배치된 칩 내 메모리가 가로방향 뿐 아니라 세로방향도 읽어낼 수 있는 특수 저전력 분산 메모리로의 설계 ▲1024개의 곱셈기와 덧셈기가 동시에 구동돼 막강한 계산력을 가지면서 외부 통신망을 거치지 않고 직접 계산 결과를 주고받을 수 있게 한 점이다.

CNNP는 97%의 인식률을 가지면서도 알파고에 사용된 GPU에 비해 5천분의 1정도의 낮은 전력인 0.6mW만을 소모한다.

K-Eye를 목에 건 사용자는 앞에서 다가오는 상대방의 얼굴이 화면에 떠오르면 미리 저장된 정보와 실시간으로 찍힌 사진을 비교해 상대방의 이름 등 정보를 자연스럽게 확인할 수 있다.

동글 타입인 K-EyeQ는 스마트폰에 장착해 이용할 수 있는데 사용자를 알아보고 반응하는 기능을 한다. 미리 기억시킨 사용자의 얼굴이 화면을 향하기만 하면 스마트폰 화면이 저절로 켜지면서 그와 관련된 정보를 제공한다.

또한 입력된 얼굴이 사진인지 실제 사람인지도 구분할 수 있어 사용자의 얼굴 대신 사진을 보여주면 스마트폰은 반응하지 않는다.

유 교수는 “인공지능 반도체 프로세서가 4차 산업혁명시대를 주도할 것으로 기대된다”며 “이번 인공지능 칩과 인식기의 개발로 인해 세계시장에서 한국이 인공지능 산업의 주도권을 갖길 기대한다”고 말했다.

□ 사진 설명.

사진1. K-EYE 사진

사진2. K-EYEQ 사진

사진3. CNNP 칩 사진

2017.06.14 조회수 13033KAIST 무선충전전기자동차, CNN 방영 우리 학교에서 개발한 무선충전전기자동차가 지난 8월 29일 미국 CNN방송의 "Eco Solutions"라는 프로그램에 방영됐다. CNN은 올 7월 19일 서울대공원에서 상용서비스를 시작한 KAIST 무선충전전기자동차가 기존 디젤 "코끼리열차"에 비해 매연과 소음이 없는 친환경 전기자동차로 방문객들로부터 커다란 호응을 받고 있다고 소개했다. CNN 링크 : http://edition.cnn.com/CNNI/Programs/eco.solutions/index.html YouTube 링크 : http://www.youtube.com/watch?v=QLzmFFqPJfo

2011.09.04 조회수 9958 대사공학적으로 개량된 박테리아로 범용 플라스틱 생산기술 개발

- 이상엽 교수팀과 LG 화학 연구팀 공동개발

- 바이오테크놀로지 바이오엔지니어링(Biotechnology and Bioengineering)지 게재예정

생명화학공학과 이상엽(李相燁, 45세, LG화학 석좌교수, 생명과학기술대학 학장) 특훈교수팀과 LG화학 기술연구원(원장 유진녕) 박시재, 양택호박사팀이 4년여 간의 공동연구를 통해 박테리아를 이용하여 재생 가능한 바이오매스로부터 플라스틱을 생산하는 기술을 최근 개발했다.

교육과학기술부 시스템생물학 연구개발 사업과 LG화학 석좌교수 연구비로 지원된 이번 연구에서는 시스템 대사공학과 효소공학 기법을 접목, 자연적으로는 생성되지 않는 플라스틱(unnatural polymer)의 일종으로 최근 각광을 받고 있는 폴리유산(Polylactic acid, PLA)을 효율적으로 생산할 수 있는 대장균을 개발한 것이다.

이번 연구 결과는 바이오공학 분야 최고 전통의 바이오테크놀로지 바이오엔지니어링(Biotechnology and Bioengineering)지에 게재 승인됐으며 스포트라이트 논문(Spotlight paper)으로 선정돼 2010년 1월호에 두 편의 연속 논문으로 게재될 예정이다.

두 논문의 제목은 ‘개량된 프로피오네이트 코엔자임 에이 트랜스퍼레이즈와 폴리하이드록시알카노에이트 중합효소를 이용한 폴리유산과 그의 공중합체의 생합성(Biosynthesis of Polylactic acid and its Copolymers Using Evolved Propionate CoA Transferase and PHA Synthase)’과 ‘폴리유산과 그의 공중합체의 생산을 위한 대장균의 대사공학(Metabolic Engineering of Escherichia coli for the Production of Polylactic Acid and its Copolymers)’이다. 19건의 특허가 전 세계 출원 중이다.

기존의 복잡한 2단계 공정을 통해 생산되던 폴리유산을 재생가능한 원료로부터 미생물의 직접 발효에 의해 생산이 가능하도록 한 혁신적인 본 연구 전략은 앞으로 석유 유래 플라스틱을 대체할 수 있는 다양한 비자연 고분자(unnatural polymer)들의 생산에 활용될 획기적인 기술로 평가되고 있다.

폴리유산 (Polylactic acid, PLA)은 많은 바이오매스 유래 고분자들 중에서도 생분해성, 생체적합성, 구조적 안정성, 그리고 낮은 독성과 같은 뛰어난 물성으로 인해 석유 유래 플라스틱의 대체물로서 대두되고 있다.

그러나, 폴리유산은 현재 두 단계 공정으로 합성된다. 우선, 미생물 발효를 통해 유산(락트산, Lactic acid)을 생산, 정제한 후 여러 가지 시약, 용매 및 촉매가 첨가되는 복잡한 공정의 화학적 중합반응에 의해 폴리유산이 합성된다.

또한, 폴리유산의 물성을 다양하게 개선하기 위해 폴리하이드록시알카노에이트 (Polyhydroxyalkanoate, PHA)와 같은 다른 고분자들과의 공중합이나 혼합반응 등의 연구가 이루어지고 있다.

이러한 노력에도 불구하고, 공중합 반응에 사용되는 락톤계 모노머들의 가용성과 비용을 고려했을 때, 기존의 화학적 합성 방법은 효과적이지 않다. 이에, 미생물 유래 고분자인 폴리하이드록시알카노에이트의 생합성 시스템을 기반으로, 폴리유산과 그의 공중합체들의 생합성이 가능할 수 있는 대사경로를 효소공학을 통해 구축했다.

그러나, 외래 대사경로의 도입 및 조작만으로는 폴리유산 단일 중합체와 유산의 함량이 높은 공중합체의 생산이 효율적이지 않아, 시스템 수준으로 세포 내 대사흐름을 증가시킬 필요성을 인지했다. 이에, 대장균 균주의 인실리코 게놈 수준의 시뮬레이션을 이용한 대사흐름분석 기법을 활용하여 고분자 생산을 위한 주요 전구체의 대사 흐름을 논리적으로 강화시킴으로써, 세포성장과 함께 목적 고분자의 효율적 생산이 가능하도록 했다.

따라서, 효소공학을 통한 고분자 합성 경로의 직접적 조작 및 강화 뿐 아니라, 시스템 대사공학을 통한 논리적 접근으로 조작된 대사흐름을 바탕으로 다양한 폴리유산 플라스틱을 보다 효율적으로 생산할 수 있었다.

이는 시스템 대사공학과 효소공학을 접목시킨 고기술 전략으로 비자연 고분자를 효율적으로 생산한 최초의 성공적인 예로서, 재생가능한 자원으로부터 폴리유산뿐 아니라 석유유래 플라스틱을 대체할 수 있는 다른 비자연 고분자들의 일단계 생산을 위한 기반 기술을 마련해줌으로써, 플라스틱 생산 공정에 있어 새로운 전략을 제시했다.

李 교수는 “자연계에 없는 고분자를 미생물로 생산하는 것이 과연 될까? 라는 의문을 갖고 시작했다. 우리 KAIST 연구실의 정유경박사와 LG화학 기술연구원 연구팀원 10여명이 4년간의 끈질긴 노력 끝에 성공했다”며, “이번 연구는 대장균의 가상세포 시뮬레이션을 통해 세포 내 대사흐름을 목적한 고분자 생산에 유리하도록 논리적으로 조작하고, 고분자 생합성 경로를 구성하는 외래 효소들을 새롭게 만들어 도입함으로써, 강화된 대사흐름을 이용해 보다 효율적으로 목적 고분자를 생산할 수 있는 균주를 개발하는데 성공한 세계 첫 번째 케이스다. 특히, 유산이 단량체로 함유된 공중합체의 경우에는 세계최초로 만든 것이 되어 물질특허들로 출원중이다”라고 밝혔다.

한편, 이 혁신적인 연구 성과는 22일 미국 CNN 홈페이지의 Top기사 등 해외언론의 주요기사로 소개됐다. 주요내용은 한국의 KAIST 이상엽 교수팀과 LG화학 연구팀이 전 세계적으로 석유고갈, 지구온난화 및 환경오염 문제로 재생가능한 자원을 이용한 바이오매스 기반 기술의 개발이 시급한 현 시대의 흐름에 부응하면서, 재생가능한 자원으로부터 효율적으로 바이오공학을 통한 플라스틱 (Bioengineered plastics) 폴리유산의 생산이 가능한 대장균 균주를 개발했다는 내용이다.

2009.11.24 조회수 19379

대사공학적으로 개량된 박테리아로 범용 플라스틱 생산기술 개발

- 이상엽 교수팀과 LG 화학 연구팀 공동개발

- 바이오테크놀로지 바이오엔지니어링(Biotechnology and Bioengineering)지 게재예정

생명화학공학과 이상엽(李相燁, 45세, LG화학 석좌교수, 생명과학기술대학 학장) 특훈교수팀과 LG화학 기술연구원(원장 유진녕) 박시재, 양택호박사팀이 4년여 간의 공동연구를 통해 박테리아를 이용하여 재생 가능한 바이오매스로부터 플라스틱을 생산하는 기술을 최근 개발했다.

교육과학기술부 시스템생물학 연구개발 사업과 LG화학 석좌교수 연구비로 지원된 이번 연구에서는 시스템 대사공학과 효소공학 기법을 접목, 자연적으로는 생성되지 않는 플라스틱(unnatural polymer)의 일종으로 최근 각광을 받고 있는 폴리유산(Polylactic acid, PLA)을 효율적으로 생산할 수 있는 대장균을 개발한 것이다.

이번 연구 결과는 바이오공학 분야 최고 전통의 바이오테크놀로지 바이오엔지니어링(Biotechnology and Bioengineering)지에 게재 승인됐으며 스포트라이트 논문(Spotlight paper)으로 선정돼 2010년 1월호에 두 편의 연속 논문으로 게재될 예정이다.

두 논문의 제목은 ‘개량된 프로피오네이트 코엔자임 에이 트랜스퍼레이즈와 폴리하이드록시알카노에이트 중합효소를 이용한 폴리유산과 그의 공중합체의 생합성(Biosynthesis of Polylactic acid and its Copolymers Using Evolved Propionate CoA Transferase and PHA Synthase)’과 ‘폴리유산과 그의 공중합체의 생산을 위한 대장균의 대사공학(Metabolic Engineering of Escherichia coli for the Production of Polylactic Acid and its Copolymers)’이다. 19건의 특허가 전 세계 출원 중이다.

기존의 복잡한 2단계 공정을 통해 생산되던 폴리유산을 재생가능한 원료로부터 미생물의 직접 발효에 의해 생산이 가능하도록 한 혁신적인 본 연구 전략은 앞으로 석유 유래 플라스틱을 대체할 수 있는 다양한 비자연 고분자(unnatural polymer)들의 생산에 활용될 획기적인 기술로 평가되고 있다.

폴리유산 (Polylactic acid, PLA)은 많은 바이오매스 유래 고분자들 중에서도 생분해성, 생체적합성, 구조적 안정성, 그리고 낮은 독성과 같은 뛰어난 물성으로 인해 석유 유래 플라스틱의 대체물로서 대두되고 있다.

그러나, 폴리유산은 현재 두 단계 공정으로 합성된다. 우선, 미생물 발효를 통해 유산(락트산, Lactic acid)을 생산, 정제한 후 여러 가지 시약, 용매 및 촉매가 첨가되는 복잡한 공정의 화학적 중합반응에 의해 폴리유산이 합성된다.

또한, 폴리유산의 물성을 다양하게 개선하기 위해 폴리하이드록시알카노에이트 (Polyhydroxyalkanoate, PHA)와 같은 다른 고분자들과의 공중합이나 혼합반응 등의 연구가 이루어지고 있다.

이러한 노력에도 불구하고, 공중합 반응에 사용되는 락톤계 모노머들의 가용성과 비용을 고려했을 때, 기존의 화학적 합성 방법은 효과적이지 않다. 이에, 미생물 유래 고분자인 폴리하이드록시알카노에이트의 생합성 시스템을 기반으로, 폴리유산과 그의 공중합체들의 생합성이 가능할 수 있는 대사경로를 효소공학을 통해 구축했다.

그러나, 외래 대사경로의 도입 및 조작만으로는 폴리유산 단일 중합체와 유산의 함량이 높은 공중합체의 생산이 효율적이지 않아, 시스템 수준으로 세포 내 대사흐름을 증가시킬 필요성을 인지했다. 이에, 대장균 균주의 인실리코 게놈 수준의 시뮬레이션을 이용한 대사흐름분석 기법을 활용하여 고분자 생산을 위한 주요 전구체의 대사 흐름을 논리적으로 강화시킴으로써, 세포성장과 함께 목적 고분자의 효율적 생산이 가능하도록 했다.

따라서, 효소공학을 통한 고분자 합성 경로의 직접적 조작 및 강화 뿐 아니라, 시스템 대사공학을 통한 논리적 접근으로 조작된 대사흐름을 바탕으로 다양한 폴리유산 플라스틱을 보다 효율적으로 생산할 수 있었다.

이는 시스템 대사공학과 효소공학을 접목시킨 고기술 전략으로 비자연 고분자를 효율적으로 생산한 최초의 성공적인 예로서, 재생가능한 자원으로부터 폴리유산뿐 아니라 석유유래 플라스틱을 대체할 수 있는 다른 비자연 고분자들의 일단계 생산을 위한 기반 기술을 마련해줌으로써, 플라스틱 생산 공정에 있어 새로운 전략을 제시했다.

李 교수는 “자연계에 없는 고분자를 미생물로 생산하는 것이 과연 될까? 라는 의문을 갖고 시작했다. 우리 KAIST 연구실의 정유경박사와 LG화학 기술연구원 연구팀원 10여명이 4년간의 끈질긴 노력 끝에 성공했다”며, “이번 연구는 대장균의 가상세포 시뮬레이션을 통해 세포 내 대사흐름을 목적한 고분자 생산에 유리하도록 논리적으로 조작하고, 고분자 생합성 경로를 구성하는 외래 효소들을 새롭게 만들어 도입함으로써, 강화된 대사흐름을 이용해 보다 효율적으로 목적 고분자를 생산할 수 있는 균주를 개발하는데 성공한 세계 첫 번째 케이스다. 특히, 유산이 단량체로 함유된 공중합체의 경우에는 세계최초로 만든 것이 되어 물질특허들로 출원중이다”라고 밝혔다.

한편, 이 혁신적인 연구 성과는 22일 미국 CNN 홈페이지의 Top기사 등 해외언론의 주요기사로 소개됐다. 주요내용은 한국의 KAIST 이상엽 교수팀과 LG화학 연구팀이 전 세계적으로 석유고갈, 지구온난화 및 환경오염 문제로 재생가능한 자원을 이용한 바이오매스 기반 기술의 개발이 시급한 현 시대의 흐름에 부응하면서, 재생가능한 자원으로부터 효율적으로 바이오공학을 통한 플라스틱 (Bioengineered plastics) 폴리유산의 생산이 가능한 대장균 균주를 개발했다는 내용이다.

2009.11.24 조회수 19379 KAIST 서남표 총장, CNN 생방송 출연

- KAIST의 국가 녹색성장 프로젝트인 온라인전기차 CNN 생방송 소개

서남표 총장이 21일 오전 CNN ‘아이 온 사우스 코리아(Eye on South Korea)" 프로그램 생방송에 출연해 KAIST를 소개했다.

이번 CNN의 현장중계는 한국의 IT발전에서 KAIST가 기여한 점과 녹색성장 프로젝트를 진행하고 있는 KAIST의 역할을 높이 평가해 이루어진 것이다.

이날 CNN 간판 앵커 스타우트(Kristie Lu Stout)가 방한해 KAIST 문지캠퍼스에서 생방송을 진행했다.

서총장은 이번 방송에서 국가프로젝트인 온라인전기차(On-Line Electric Vehicle, OLEV)를 소개했다. 서총장은 CNN 간판 앵커 스타우트(Kristie Lu Stout)와의 인터뷰에서 "전 세계 많은 곳에서 다음 세대의 자동차로 전기차를 개발하고 있지만 대부분 하이브리드 자동차나 배터리식 전기차에 집중하고 있다"며 "우리는 그것이 인류의 근본적 문제를 해결하는 방법이 아니라고 생각한다"고 말했다.

또한 이 특집 프로그램을 통해 온라인 전기버스, 전기 승용차와 인간형 로봇인 휴보(HUBO)가 전 세계에 소개됐다.

이번 CNN 한국특집 프로그램은 한국의 경제회복을 초점에 맞춰 19일부터 23일까지 매일 1시간30분 이상 CNN 채널을 통해 전 세계에 24시간 방영된다. CNN은 21일 오전 8시부터 9시30분까지 KAIST 캠퍼스 현장을 중계 방송했다.

2009.10.21 조회수 13347

KAIST 서남표 총장, CNN 생방송 출연

- KAIST의 국가 녹색성장 프로젝트인 온라인전기차 CNN 생방송 소개

서남표 총장이 21일 오전 CNN ‘아이 온 사우스 코리아(Eye on South Korea)" 프로그램 생방송에 출연해 KAIST를 소개했다.

이번 CNN의 현장중계는 한국의 IT발전에서 KAIST가 기여한 점과 녹색성장 프로젝트를 진행하고 있는 KAIST의 역할을 높이 평가해 이루어진 것이다.

이날 CNN 간판 앵커 스타우트(Kristie Lu Stout)가 방한해 KAIST 문지캠퍼스에서 생방송을 진행했다.

서총장은 이번 방송에서 국가프로젝트인 온라인전기차(On-Line Electric Vehicle, OLEV)를 소개했다. 서총장은 CNN 간판 앵커 스타우트(Kristie Lu Stout)와의 인터뷰에서 "전 세계 많은 곳에서 다음 세대의 자동차로 전기차를 개발하고 있지만 대부분 하이브리드 자동차나 배터리식 전기차에 집중하고 있다"며 "우리는 그것이 인류의 근본적 문제를 해결하는 방법이 아니라고 생각한다"고 말했다.

또한 이 특집 프로그램을 통해 온라인 전기버스, 전기 승용차와 인간형 로봇인 휴보(HUBO)가 전 세계에 소개됐다.

이번 CNN 한국특집 프로그램은 한국의 경제회복을 초점에 맞춰 19일부터 23일까지 매일 1시간30분 이상 CNN 채널을 통해 전 세계에 24시간 방영된다. CNN은 21일 오전 8시부터 9시30분까지 KAIST 캠퍼스 현장을 중계 방송했다.

2009.10.21 조회수 13347 서남표 총장, CNN 생방송 출연

- KAIST의 국가 녹색성장 프로젝트인 온라인전기차와 모바일하버 소개

서남표 총장이 오는 21일 CNN ‘아이 온 사우스 코리아(Eye on South Korea)" 프로그램 생방송에 출연해 KAIST를 소개한다.

CNN은 이날 오전 8시부터 9시30분까지 KAIST 캠퍼스 현장을 중계 방송한다. 서총장은 이번 방송에서 국가프로젝트인 온라인전기차(On-Line Electric Vehicle, OLEV)와 모바일하버(Mobile Harbor)등 KAIST의 녹색성장 프로젝트를 이야기 한다.

또한 이 특집 프로그램을 통해 온라인 전기버스와 인간형 로봇인 휴보(HUBO)가 전 세계에 소개 될 예정이다.

우리대학 관계자는 “이번 CNN의 현장중계는 한국의 IT발전에서 KAIST가 기여한 점과 녹색성장 프로젝트를 진행하고 있는 KAIST의 역할을 높이 평가해 이루어진 것”이라고 말했다.

이번 CNN 한국특집 프로그램은 한국의 경제회복을 초점에 맞춰 19일부터 23일까지 매일 1시간30분 이상 CNN 채널을 통해 전 세계에 24시간 방영된다. 이날 CNN 간판 앵커 스타우트(Kristie Lu Stout)가 방한해 KAIST 문지캠퍼스에서 생방송을 진행한다.

2009.10.20 조회수 7037

서남표 총장, CNN 생방송 출연

- KAIST의 국가 녹색성장 프로젝트인 온라인전기차와 모바일하버 소개

서남표 총장이 오는 21일 CNN ‘아이 온 사우스 코리아(Eye on South Korea)" 프로그램 생방송에 출연해 KAIST를 소개한다.

CNN은 이날 오전 8시부터 9시30분까지 KAIST 캠퍼스 현장을 중계 방송한다. 서총장은 이번 방송에서 국가프로젝트인 온라인전기차(On-Line Electric Vehicle, OLEV)와 모바일하버(Mobile Harbor)등 KAIST의 녹색성장 프로젝트를 이야기 한다.

또한 이 특집 프로그램을 통해 온라인 전기버스와 인간형 로봇인 휴보(HUBO)가 전 세계에 소개 될 예정이다.

우리대학 관계자는 “이번 CNN의 현장중계는 한국의 IT발전에서 KAIST가 기여한 점과 녹색성장 프로젝트를 진행하고 있는 KAIST의 역할을 높이 평가해 이루어진 것”이라고 말했다.

이번 CNN 한국특집 프로그램은 한국의 경제회복을 초점에 맞춰 19일부터 23일까지 매일 1시간30분 이상 CNN 채널을 통해 전 세계에 24시간 방영된다. 이날 CNN 간판 앵커 스타우트(Kristie Lu Stout)가 방한해 KAIST 문지캠퍼스에서 생방송을 진행한다.

2009.10.20 조회수 7037 오준호 교수, CNN 특집프로그램 패널리스트로 출연

기계공학과 오준호(吳俊鎬, 51) 교수가 CNN 인터네셔널 특집프로그램인 “인간과 기계의 미래정상회담(Future Summit: Of Man and Machine)”에 패널리스트로 출연했다.

이번 프로그램 주제는 “인간과 기계”로 CNN 종군앵커로 유명한 마이클 홈즈(Michael Holmes)의 진행으로 로봇분야 吳 교수를 비롯, 복제양 돌리를 만든 영국의 알란 콜맨(Allan Colman) 박사, 말라리아 퇴치가 가능한 새로운 생물 알태미시닌(Artemisinin)를 개발한 버클리대 재이 키슬링(Jay Keasling) 교수, 그리고 인류학자인 스위스 로잔대 다니엘라 써퀴(Daniela Cerqui) 교수, 로봇심리학자 조안 프란스키(Joanne Pransky) 여사가 패널로 참여했다.

CNN은 10명의 각계 저명인사로 구성된 자문위원회를 통해 패널을 추천 받아 사전 인터뷰 등을 거쳐 吳 교수를 비롯한 5명의 패널을 선정했다.

吳 교수는 이 방송에서 “미래에는 움직임과 자율성을 갖는 로봇화가 우리 주변 거의 모든 것에 구현될 것이며, 로봇과 가전제품의 벽이 없어질 것이다”라고 예측했다. 특히 이 프로그램에는 吳 교수가 개발한 인간형 로봇인 휴보(HUBO)가 직접 출연, 세계최고 수준의 로봇이라는 소개와 함께 진행자와 오프닝을 진행했다.

“Future Summit”은 CNN 인터네셔널에서 과학기술이 미래사회에 미칠 영향에 대해 서로 다른 분야의 인사를 초빙하여 조명하는 특집 프로그램이다. 이번이 첫 방송인 이 프로그램은 7회에 걸쳐 우리나라를 포함한 전 세계 200여개국(미국 제외)의 CNN케이블 방송망을 통해 방송된다.

* 첨부: ① 오준호 교수 사진 1매, ② 휴보 사진 2매 ③ 한국 방송시간

<한국 방송시간>

6월 15일(목) 23:00

6월 16일(금) 06:00

6월 17일(토) 15:00, 23:00

6월 18일(일) 04:00, 15:00

6월 19일(월) 04:00

----------------------------------------------------------------------------------------------------------

CNN은 CNN International(CNNi), CNN USA, CNN 스페인어 등으로 구성되어 있으며 CNN USA 는 주로 미국 내 뉴스를 다루고 미국에서만 방영되며, CNNi 는 국제뉴스전문 채널로서 미국을 제외한 전 세계 200여개국으로 방송된다. 한국에서 시청하는 CNN은 CNN international 이다.

2006.06.16 조회수 13429

오준호 교수, CNN 특집프로그램 패널리스트로 출연

기계공학과 오준호(吳俊鎬, 51) 교수가 CNN 인터네셔널 특집프로그램인 “인간과 기계의 미래정상회담(Future Summit: Of Man and Machine)”에 패널리스트로 출연했다.

이번 프로그램 주제는 “인간과 기계”로 CNN 종군앵커로 유명한 마이클 홈즈(Michael Holmes)의 진행으로 로봇분야 吳 교수를 비롯, 복제양 돌리를 만든 영국의 알란 콜맨(Allan Colman) 박사, 말라리아 퇴치가 가능한 새로운 생물 알태미시닌(Artemisinin)를 개발한 버클리대 재이 키슬링(Jay Keasling) 교수, 그리고 인류학자인 스위스 로잔대 다니엘라 써퀴(Daniela Cerqui) 교수, 로봇심리학자 조안 프란스키(Joanne Pransky) 여사가 패널로 참여했다.

CNN은 10명의 각계 저명인사로 구성된 자문위원회를 통해 패널을 추천 받아 사전 인터뷰 등을 거쳐 吳 교수를 비롯한 5명의 패널을 선정했다.

吳 교수는 이 방송에서 “미래에는 움직임과 자율성을 갖는 로봇화가 우리 주변 거의 모든 것에 구현될 것이며, 로봇과 가전제품의 벽이 없어질 것이다”라고 예측했다. 특히 이 프로그램에는 吳 교수가 개발한 인간형 로봇인 휴보(HUBO)가 직접 출연, 세계최고 수준의 로봇이라는 소개와 함께 진행자와 오프닝을 진행했다.

“Future Summit”은 CNN 인터네셔널에서 과학기술이 미래사회에 미칠 영향에 대해 서로 다른 분야의 인사를 초빙하여 조명하는 특집 프로그램이다. 이번이 첫 방송인 이 프로그램은 7회에 걸쳐 우리나라를 포함한 전 세계 200여개국(미국 제외)의 CNN케이블 방송망을 통해 방송된다.

* 첨부: ① 오준호 교수 사진 1매, ② 휴보 사진 2매 ③ 한국 방송시간

<한국 방송시간>

6월 15일(목) 23:00

6월 16일(금) 06:00

6월 17일(토) 15:00, 23:00

6월 18일(일) 04:00, 15:00

6월 19일(월) 04:00

----------------------------------------------------------------------------------------------------------

CNN은 CNN International(CNNi), CNN USA, CNN 스페인어 등으로 구성되어 있으며 CNN USA 는 주로 미국 내 뉴스를 다루고 미국에서만 방영되며, CNNi 는 국제뉴스전문 채널로서 미국을 제외한 전 세계 200여개국으로 방송된다. 한국에서 시청하는 CNN은 CNN international 이다.

2006.06.16 조회수 13429